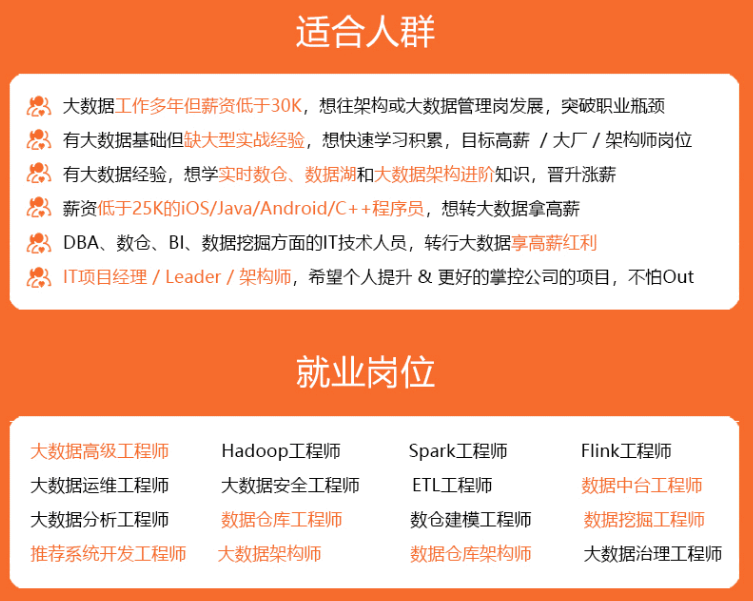

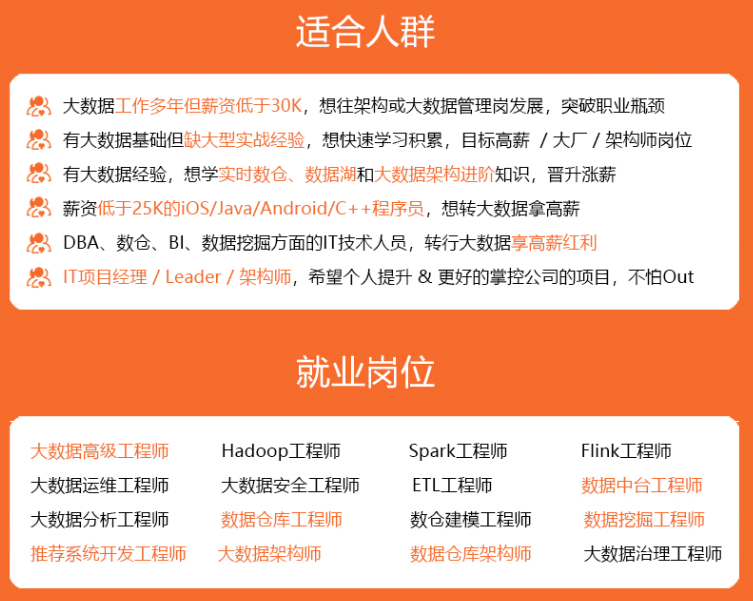

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

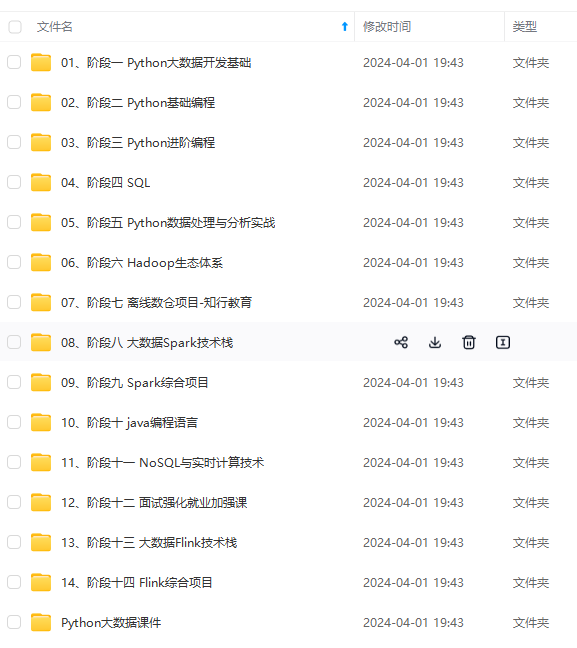

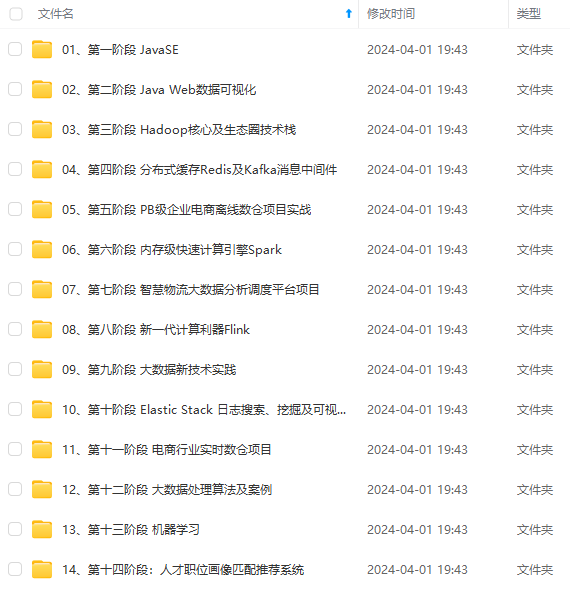

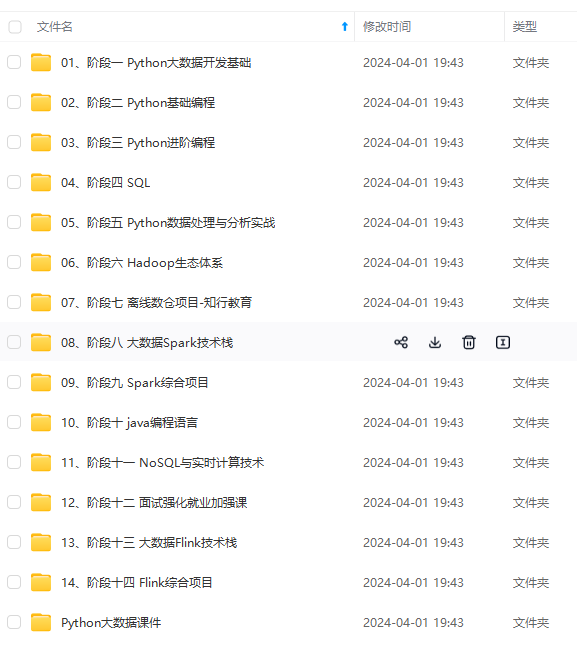

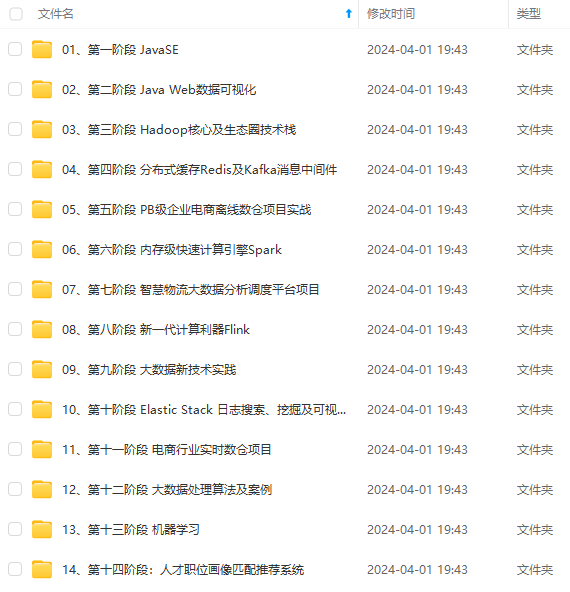

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

源码地址

https://github.com/MIC-DKFZ/nnUNet

以下都是直接在服务器的Terminal下完成的

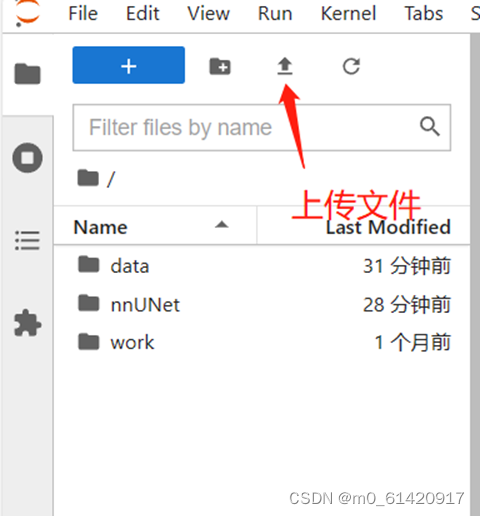

步骤零:上传数据

我服务器用的featurize,他可以在实例外部预先上传,参考:数据集 | Featurize

当然也可以在实例里上传(会比较慢)

在右侧任务框上侧,也可以直接选择上传(一般仅支持zip等压缩文件)

步骤一:先conda 新环境 python==3.9:

非必须,如果服务器本来环境就已经是pytorch2.0+python3.9就没问题(这和nnunet初代版本配置有很大差别)

模板:

conda create -n your_env_name python=x.x

conda activate your_env_name

conda create -n nnunet python=3.9 #过程中y 确认 conda activate nnunet 常用conda语句参考:

Anaconda conda常用命令:从入门到精通_conda命令_笨牛慢耕的博客-CSDN博客

步骤二:安装pytorch大礼包(注意:pytorch 2.0)

conda install pytorch torchvision torchaudio pytorch-cuda=11.7 -c pytorch -c nvidia 中间有报错重新输入输入即可,【Y/n】输入Y确认

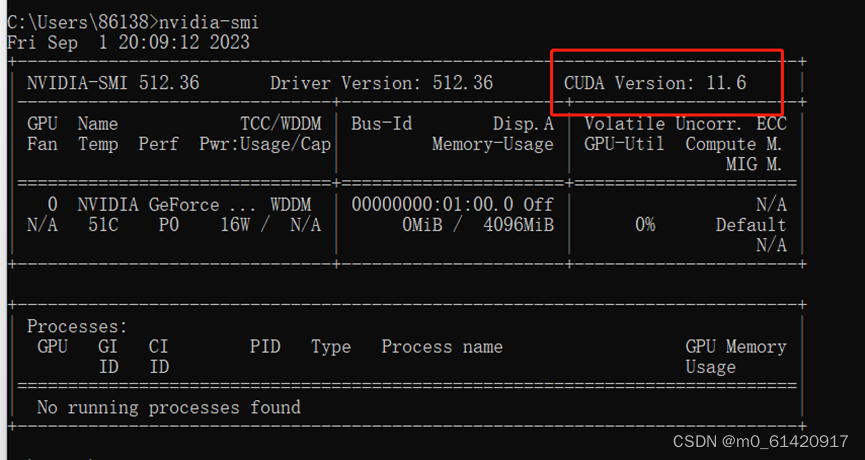

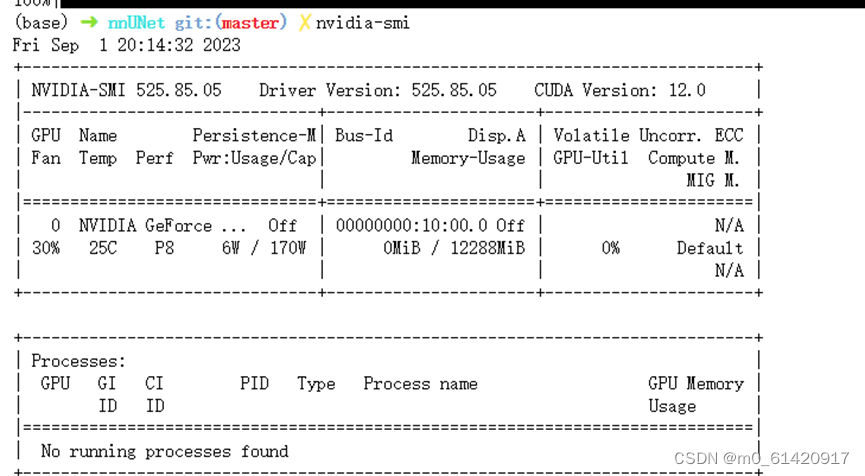

补充:查看显卡版本,torch安装GPU版本的时候,要安装显卡以下的版本(即上述代码pytorch-cuda=11.7,这个11.7要小于显卡的cuda-version值)

(本地)windows+R,打开**Windows****命令,输入cmd,**再输入nvidia-smi

(服务器的terminal)直接输入nvidia-smi

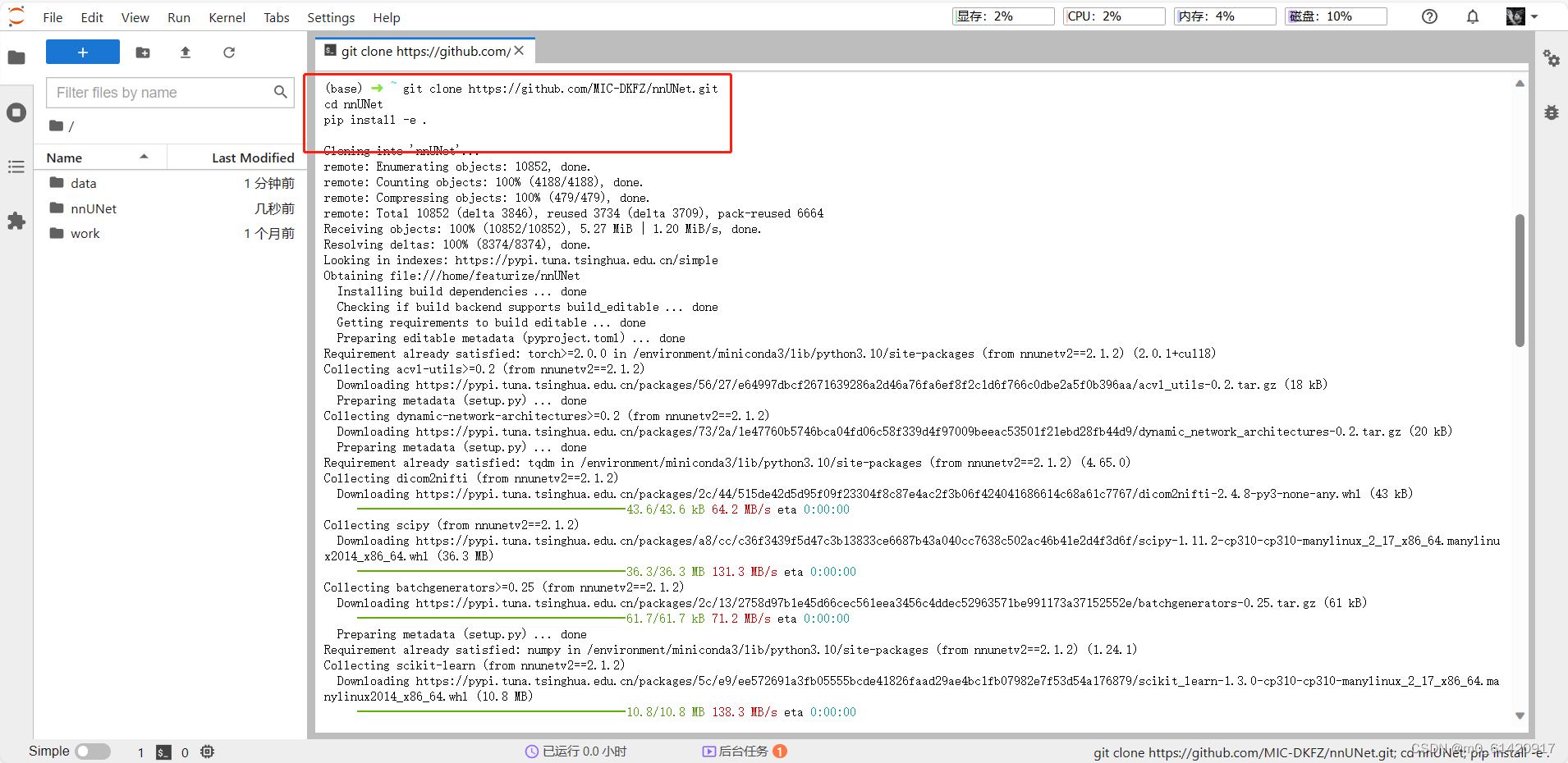

步骤三:安装nnunetv2

git clone https://github.com/MIC-DKFZ/nnUNet.git cd nnUNet pip install -e . 注意最后一行e后面还有一个点!

自己就会安装nnunetv2了!

一套流程后 pip list 里面有 nnunetv2 即完成(或者 pip show nnunetv2)

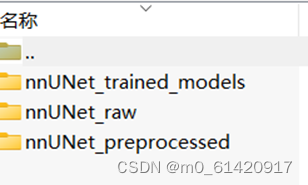

步骤四:开始配置文件结构(可以在本地提前准备好)

这部分还是和以前差不多

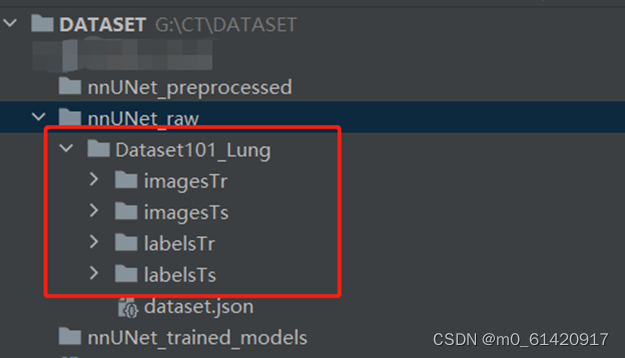

DATASET文件夹下方创建三个文件夹,分别为

| nnUNet_raw | 存放初始的影像和mask文件 |

| nnUNet_preprocessed | 预处理后的中间文件存放地 |

| nnUNet_trained_models | 训练完成的模型、训练过程存放地 |

在nnUNet_raw文件夹下方在创立一个"DatsetXXX_NAME”

参考名:“Dataset101_Lung”

(数字编号是000-999的三位数字,最好大于200,因为比较小的数字已经被fabian的task id占用,以免在哪里莫名其妙冲突了)

Dataset101_Lung下四个文件夹+一个json文件

| imagesTr | train训练集的医学影像(CT、MRI等) |

| imagesTs | test 检验集的医学影像(CT、MRI等)(optional) |

| labelsTr | train训练集的label涂层 |

| labelsTs | test 训练集的label涂层(optional) |

| dataset.json | 文件信息,详见步骤五 |

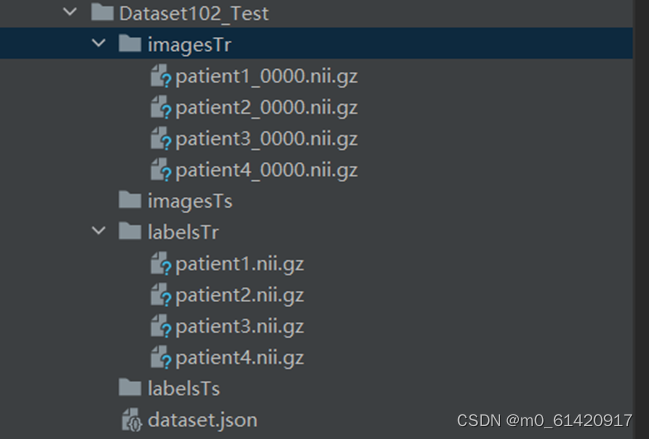

特别注意,取名原则如下:

images里面在.nii.gz前要加入0000(代表是模态0,若有其他模态的就依次0001,这个数字在json文件里要有体现,比如0模态是CT,1模态是MRI,详情请见步骤6),label是同名文件,但没有0000,0001

不同于nnunet初代版本在nnUNet_raw里面不需要额外的 cropped

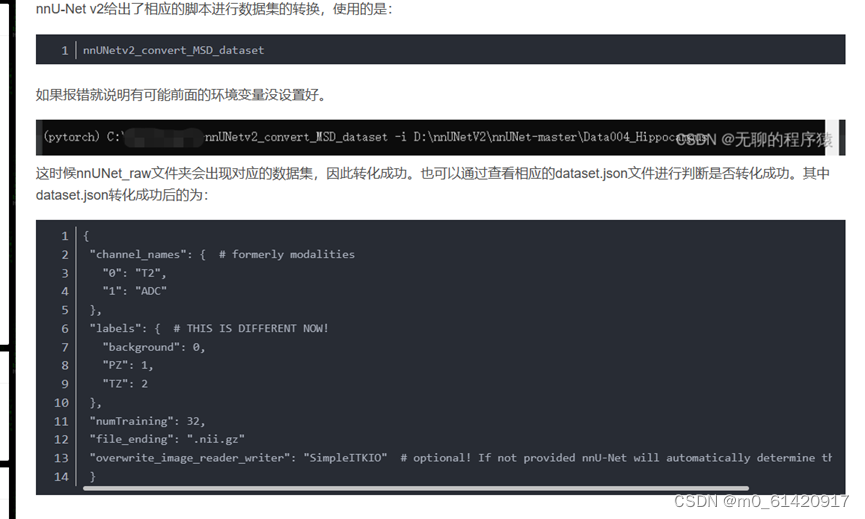

步骤五:数据集的转换与json文件

数据集转化这次没用上,就先不细说了,后续再补充

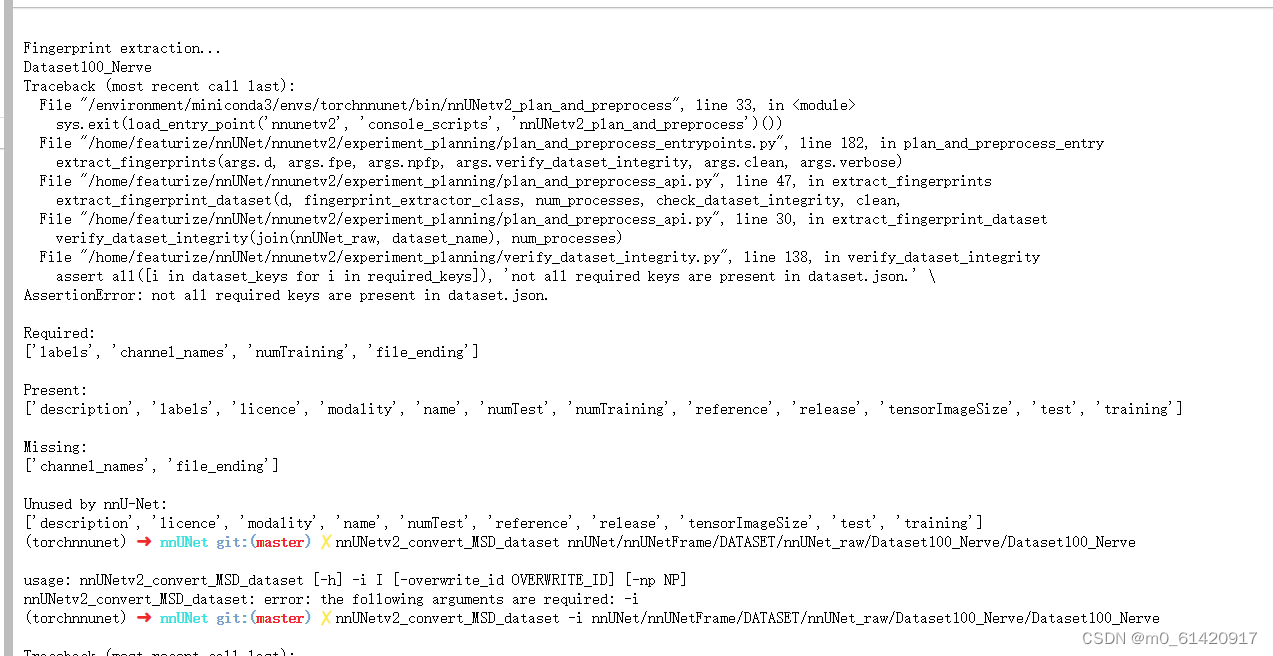

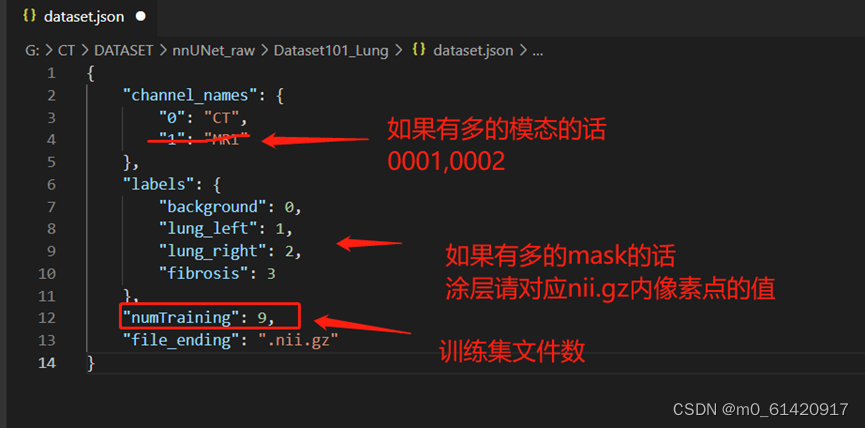

json文件相较nnunet初代版本改了好多。但考虑到其实写的比原先版本更简洁了,可以认为是件好事情吧:

我一开始用了初代的json惨遭报错:

标准格式的文件如下:

nnunetV2给了相应的脚本:

可参考:nnU-Net v2的环境配置到训练自己的数据集(详细步骤)_小萝北hh的博客-CSDN博客

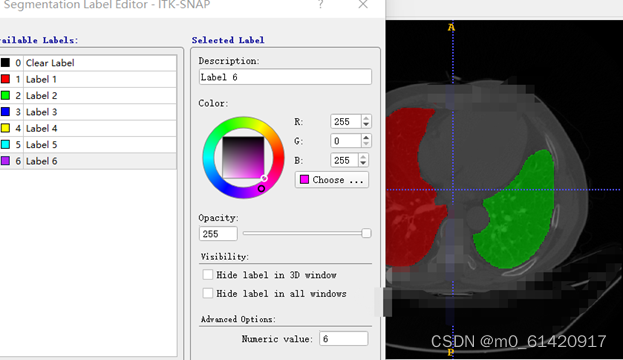

其中labels 0,1,2,3请务必对应好!所有mask文件上出现的数字都要有归属,目前nnunet尚不支持重合的mask(即不同mask之间有交集)。对文件里mask数字位置的,可以打开python去读文件或者,ITK-SNAP读一下:ITK-SNAP Home (itksnap.org)")

Label1是红色,label2是绿色,则这层mask的矩阵,对应红色区域位置是1,绿色的是2,其余(background)是0

(备注:ITK-SNAP,包括python里面一些需要调用itk包,都是在路径中不能出现中文字,甚至“-”都不能出现,可以改用为“_”)

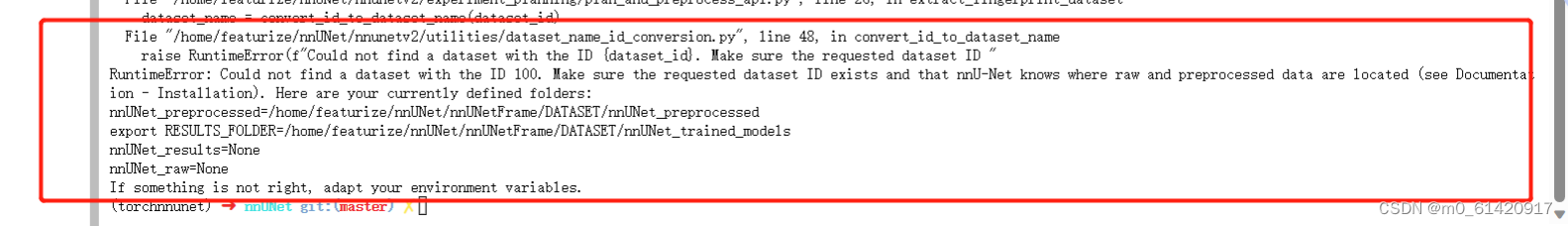

步骤六:修改环境变量(三个)

这一步即为重要,在服务器上面无法ctrl+H的打开.bashrc文件,一般的本地也需要修改环境变量,用这个方法应该也可以

需要用到vim

1、进入vim

vim ~/.zshrc vim ~/.bashrc (在我的使用中是 vim ~/.zshrc

2、进入编辑模式

:a (注意冒号!)

3、修改三个环境变量:

请一一对应好步骤四 上述文件格式里的三个文件夹

(可以点到这个文件夹的位置,然后右键弹开,点击“复制绝对路径”)

export nnUNet_preprocessed="/home/featurize/nnUNet/nnUNetFrame/DATASET/nnUNet_preprocessed" export nnUNet_results="/home/featurize/nnUNet/nnUNetFrame/DATASET/nnUNet_trained_models" export nnUNet_raw="/home/featurize/nnUNet/nnUNetFrame/DATASET/nnUNet_raw" 4、退出编辑模式

按 Esc

5、退出 记得先按上一步的Esc

:wq 输入 :wq ( :不可忽略,保存退出)

输入 :q! (不保存退出)

6、退出后加载更新后的配置

source ~/.zshrc source ~/.bashrc (我的是source ~/zshrc)

7、更新后重新激活之前配置的环境

conda activate your_env_name

conda activate nnunet 常见问题: 这个就是典型环境变量没配好,报错写的很明显了,写明了nnUNet_result变量不存在

潜在的问题:

- 名字(可能在超算里面复制的路径前面还要加上 /home/xxxxx/)[一般来说,直接右键文件夹,然后复制绝对路径就没问题了]

- 文件结构是否有问题,特别是raw的路径要是DATASET01_NAME1的上一层

- 是否 source ~/.zshrc (否则相当于没刷新)

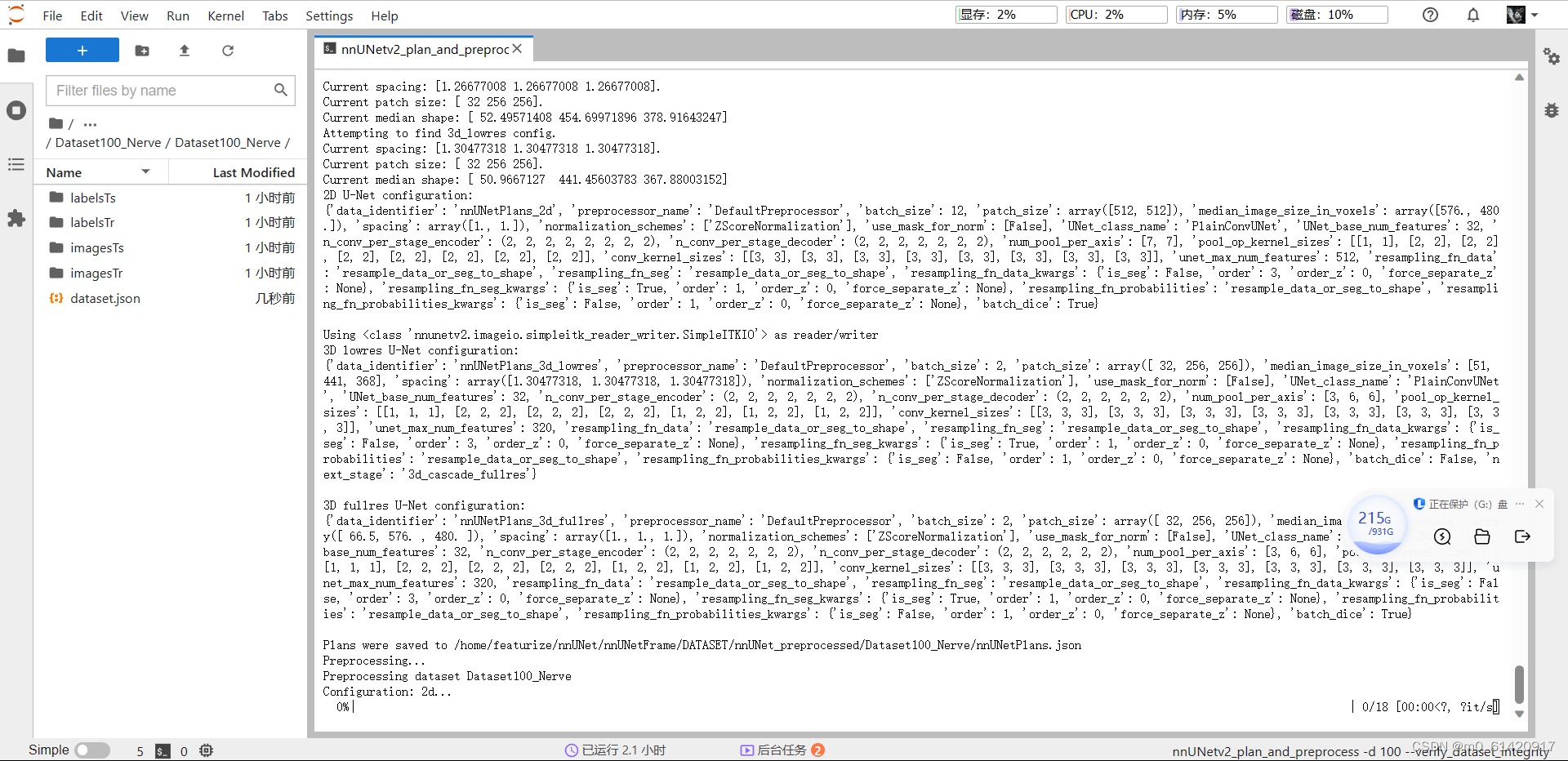

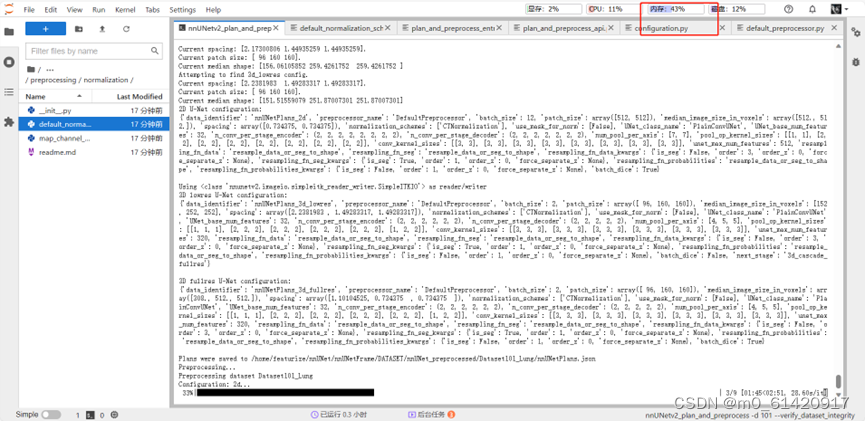

步骤七:数据集预处理

nnUNetv2_plan_and_preprocess -d TASK-NUM --verify_dataset_integrity

TASK-NUM是之前写的数字编号

nnUNetv2_plan_and_preprocess -d 101 --verify_dataset_integrity

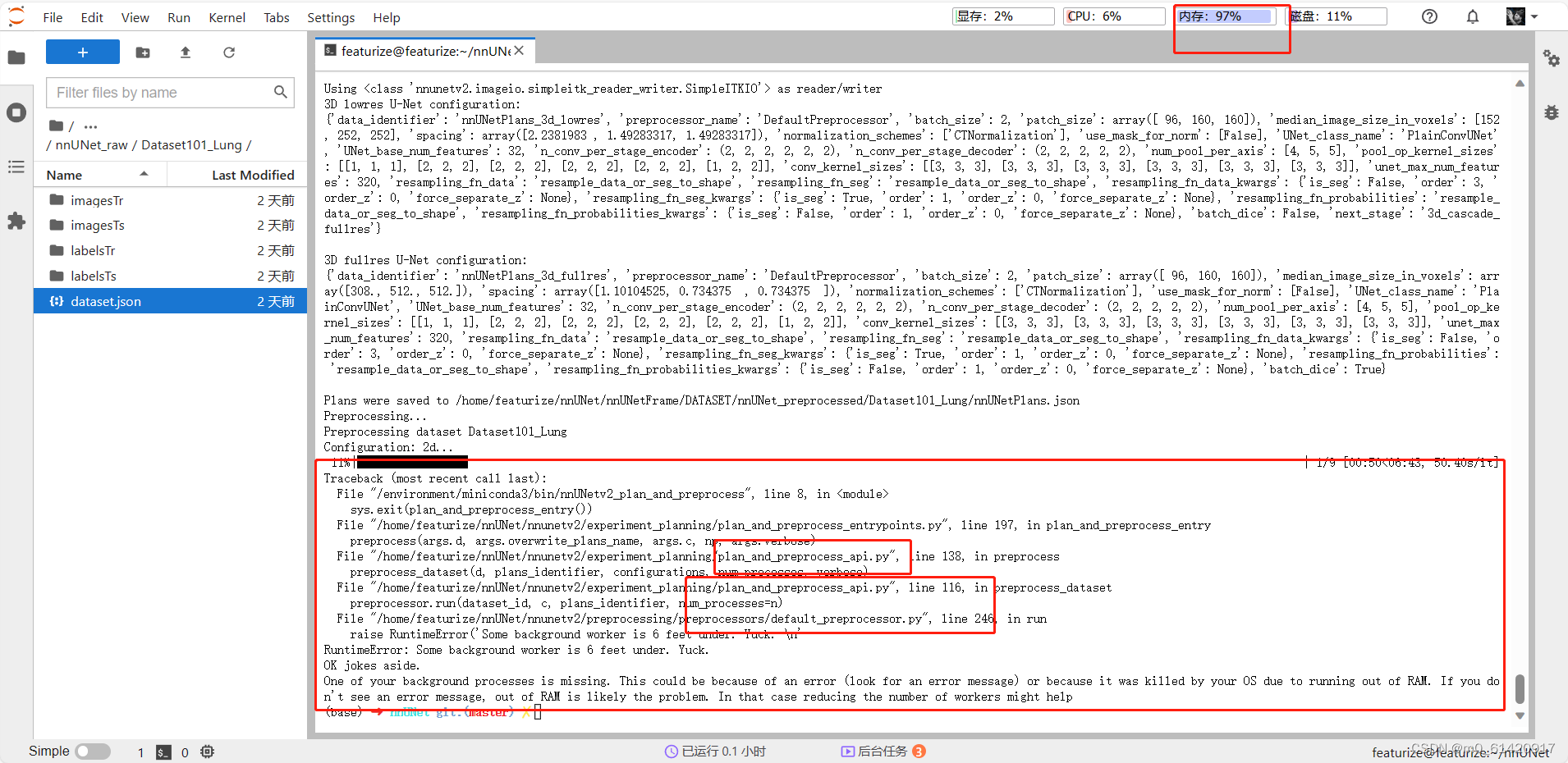

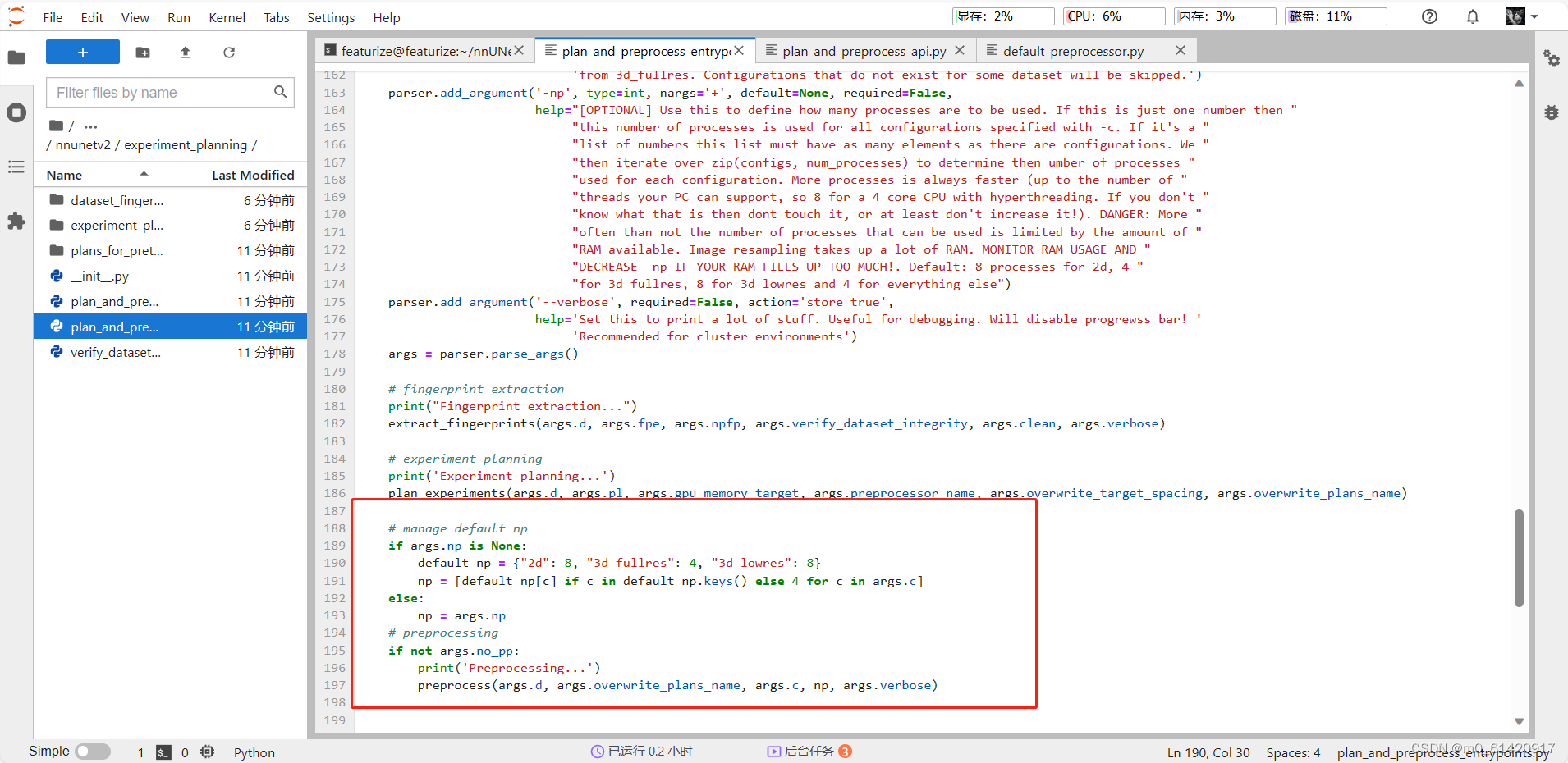

常见报错:RAM爆了,我当时在报错回溯一个一个去查,在plan_preprocess_entrypoints.py里找到了可以修改的地方

default_np = {“2d”:8, “3d_fullres”: 4, “3d_lowres”: 8} 改成了2,2,2(还不行就1,1,1;再不行就提升下换个配置吧。。。或者修改一下其他看上去能减少workers的地方)

减少这个np,能够让内存不会爆,但速度肯定会低,建议大家可以试试自己设备能够容纳的最大值

修改后内存就处于一个比较健康的状态了

修改后内存就处于一个比较健康的状态了

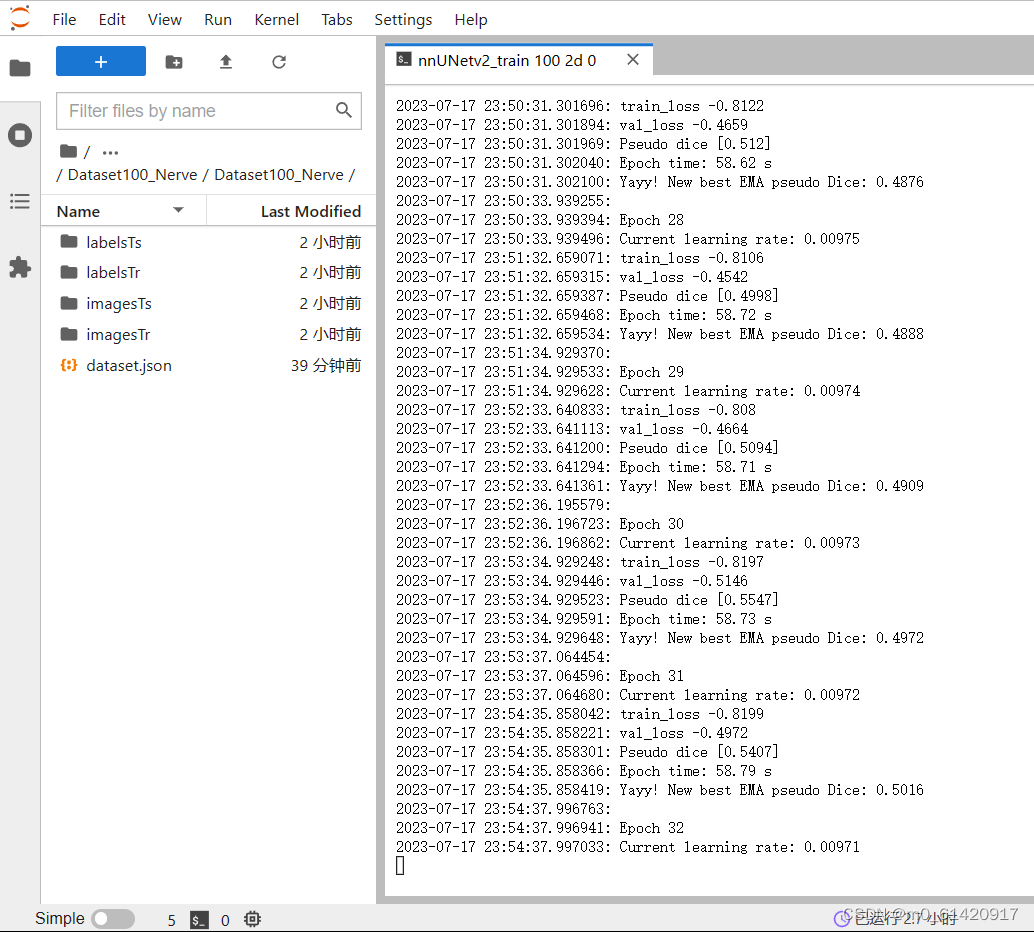

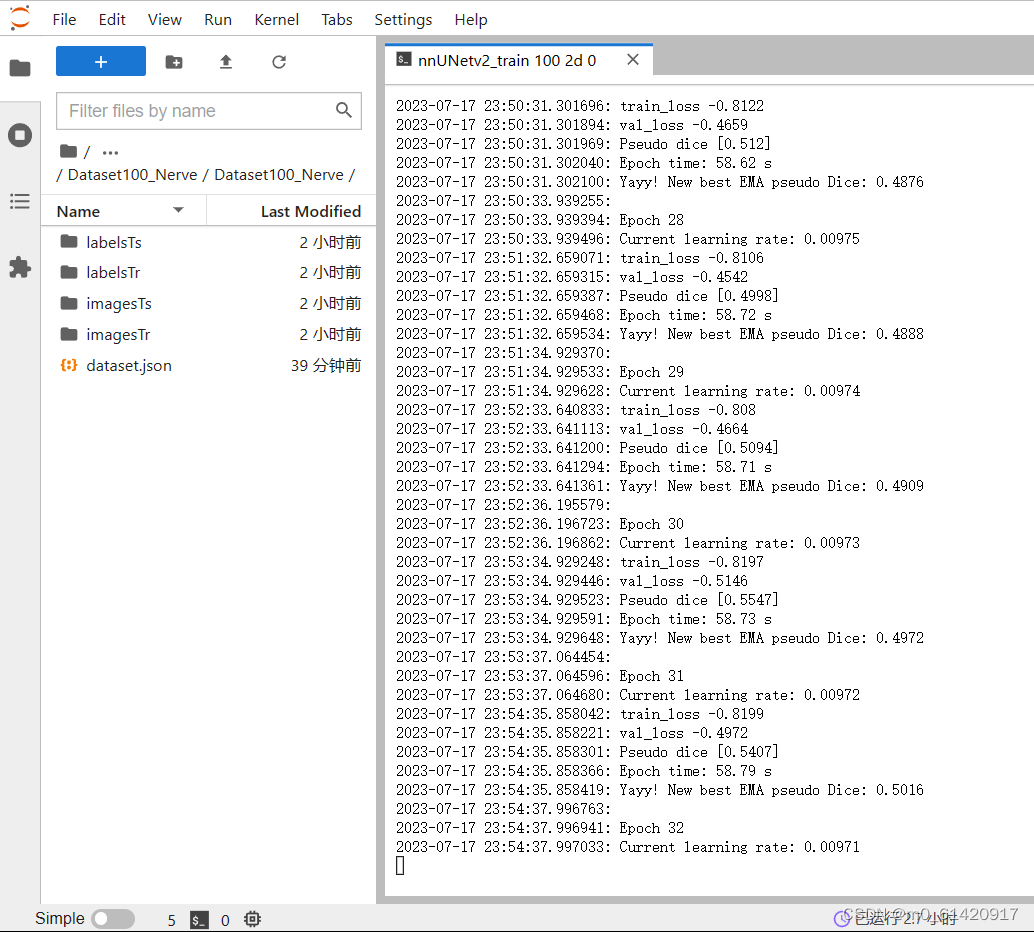

步骤八:模型训练

我贪方便,直接命令行里面写,跑完一折再写下一次。当然也可以编写终端运行此 tst.sh 文件,使用 source命令执行脚本(待补充学习)

nnUNetv2_train TASK-NUM 2d FOLD

nnUNetv2_train 101 2d 0 nnUNetv2_train 101 2d 1 nnUNetv2_train 101 2d 2 nnUNetv2_train 101 2d 3 nnUNetv2_train 101 2d 4 # 其中101表示数据集ID,上述提及过。0表示第1折

2d指的是训练Unet中的2d模型,可以选择3d_fullres,3d_lowres

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

_lowres

[外链图片转存中…(img-fWpP18V0-1715035951133)]

[外链图片转存中…(img-5HbaUYgo-1715035951134)]

[外链图片转存中…(img-VLDYREpx-1715035951134)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新