目录

由于项目代码要求pytorch2.0版本,而pytorch2.0版本需要cuda11.8,高于我之前的11.0的cuda版本。

因此考虑使用conda新建一个虚拟环境,在里面使用高版本的cuda和pytorch。

0. 背景分析

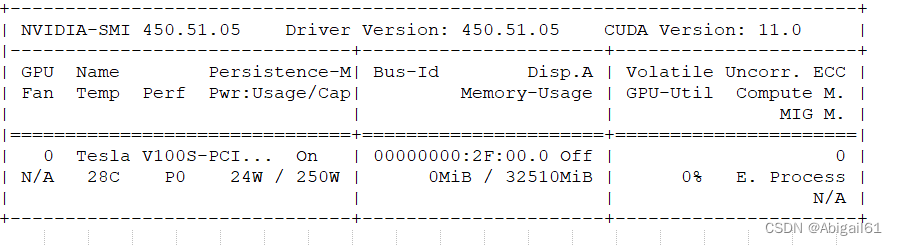

我使用的是lunix多人集群服务器。集群服务器需要用作业调度系统,也就是bsub命令之后才能提交作业,运行任务。在这种多人服务器下,如果想要查看原本的cuda版本,在命令行中直接输入nvidia-smi是无效的,会报错nvidia-smi:command not found。这种情况下如何查看cuda版本呢?可以看我之前的这篇文章 【nvidia-smi:command not found】如何在集群服务器上使用nvidia-smi查看GPU信息

看右上角,GPU的cuda版本为11.0,低于pytorch2.0需要的cuda11.8,因此考虑新安装一个高版本的cuda。(此前我也有疑惑,11.0是不是这块GPU支持的最高版本,但好像不是,可以自行下载更高版本的)

1. 新建conda虚拟环境

为了不影响其他版本的cuda,先新建虚拟环境。这里安装的是python3.10版本

conda create -n env_name python==3.10 其中env_name是虚拟环境的名字,安装过程中输入y,随后用conda activate env_name命令进入虚拟环境。

2. CUDA11.8安装

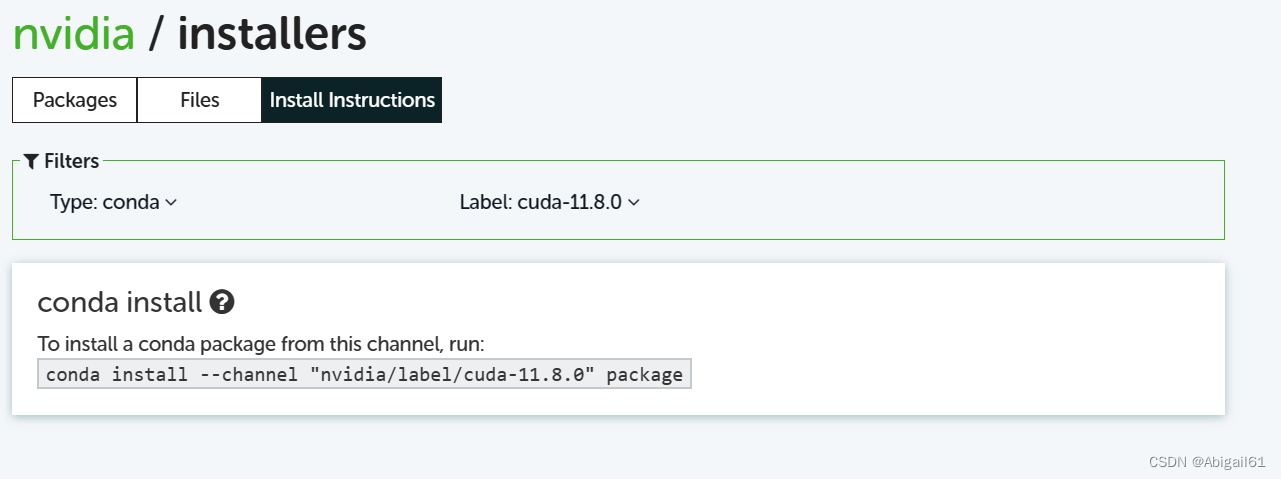

网上的教程有很多,也很复杂。但我突然发现conda官网里有一键下载cuda版本包的命令,抱着试试看的心态就使用了。

可以从label中筛选所需要的cuda版本,然后复制下载命令,直接在命令行中运行。

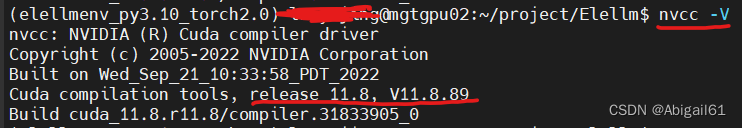

安装好之后输入nvcc -V,可以查看到相应版本的cuda。

3. torch2.0安装

下载

这里选择使用下载.whl安装包的形式。在这个网站上选择相应版本的torch。我选择的是第一个,即torch2.0版本+cuda11.8+python3.10,并且是linux系统的。(win_amd64指的是windows系统)

右键选择复制链接,然后在之前安装好的conda环境中,输入wget + 链接进行下载。如

wget https://download.pytorch.org/whl/cu118/torch-2.0.0%2Bcu118-cp310-cp310-linux_x86_64.whl#sha256=4b690e2b77f21073500c65d8bb9ea9656b8cb4e969f357370bbc992a3b074764 安装

下载结束后使用pip install 安装包名字.whl 进行安装

pip install torch-2.0.0+cu118-cp310-cp310-linux_x86_64.whl 查询是否成功

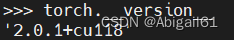

输入python进入python环境,输入torch.__version__进行查询

python torch.__version__ 结果如图所示:

到这一步就在新的环境里配上cuda和torch了,运行项目代码总算不报错了。