NVIDIA 将在 Hot Chips 2024 上展示其 Blackwell 技术堆栈,并在本周末和下周的主要活动中进行会前演示。对于 NVIDIA 发烧友来说,这是一个激动人心的时刻,他们将深入了解NVIDIA的一些最新技术。然而,Blackwell GPU 的潜在延迟可能会影响其中一些产品的时间表。

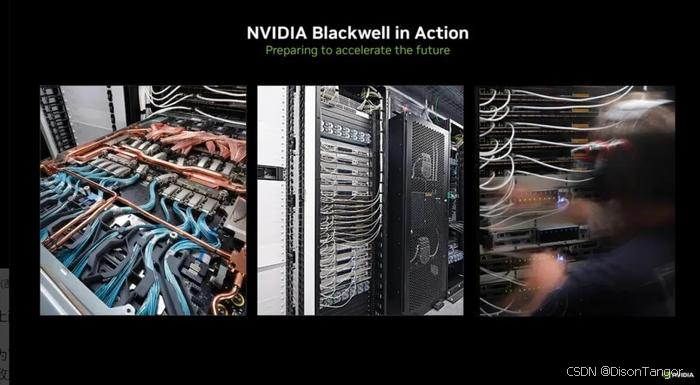

NVIDIA 决心利用其 Blackwell 平台重新定义人工智能领域,将其定位为超越传统 GPU 功能的综合生态系统。NVIDIA 将在 Hot Chips 2024 会议上展示其Blackwell 服务器的设置和配置,以及各种先进组件的集成。

在 NVIDIA 即将举行的演讲中,许多内容都是大家耳熟能详的,包括他们的数据中心和人工智能战略以及 Blackwell 路线图。该路线图概述了明年 Blackwell Ultra 的发布,随后是 2026 年的 Vera CPU 和 Rubin GPU,以及 2027 年的 Vera Ultra。NVIDIA 在去年 6 月的 Computex 上已经分享了这一路线图。

对于渴望深入了解 NVIDIA Blackwell 堆栈及其不断发展的使用案例的技术爱好者来说,Hot Chips 2024 将提供一个探索 NVIDIA 在人工智能硬件、液体冷却创新和人工智能驱动的芯片设计方面最新进展的机会。

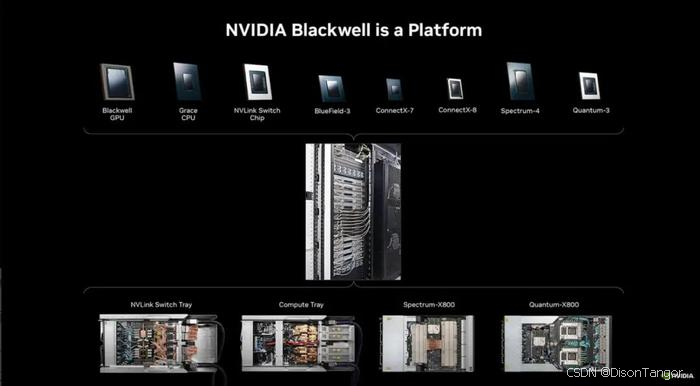

该平台由多个 NVIDIA 组件组成,包括 Blackwell GPU、Grace CPU、BlueField 数据处理单元、ConnectX 网络接口卡、NVLink 交换机、Spectrum 以太网交换机和 Quantum InfiniBand 交换机。

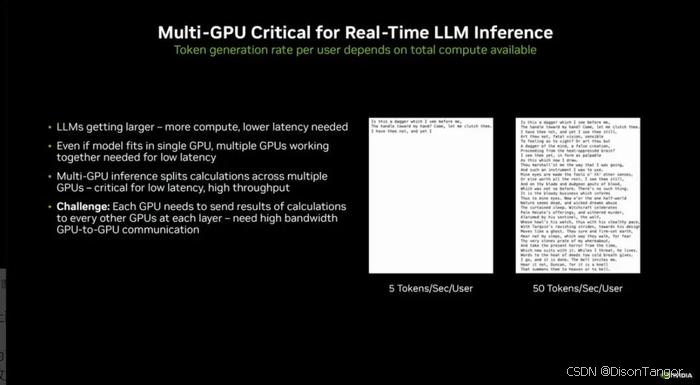

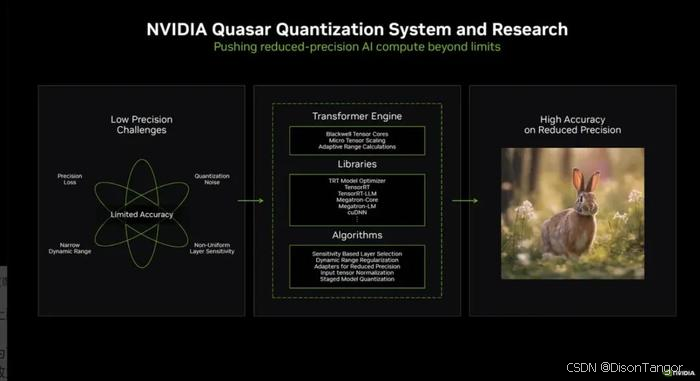

此外,NVIDIA 还将推出 Quasar Quantization System,该系统融合了先进的算法、NVIDIA 软件库和 Blackwell 的第二代 Transformer Engine,可增强 FP4 LLM 操作。这一开发成果有望在保持 FP16 高性能标准的同时大幅节省带宽,实现数据处理效率的重大飞跃。

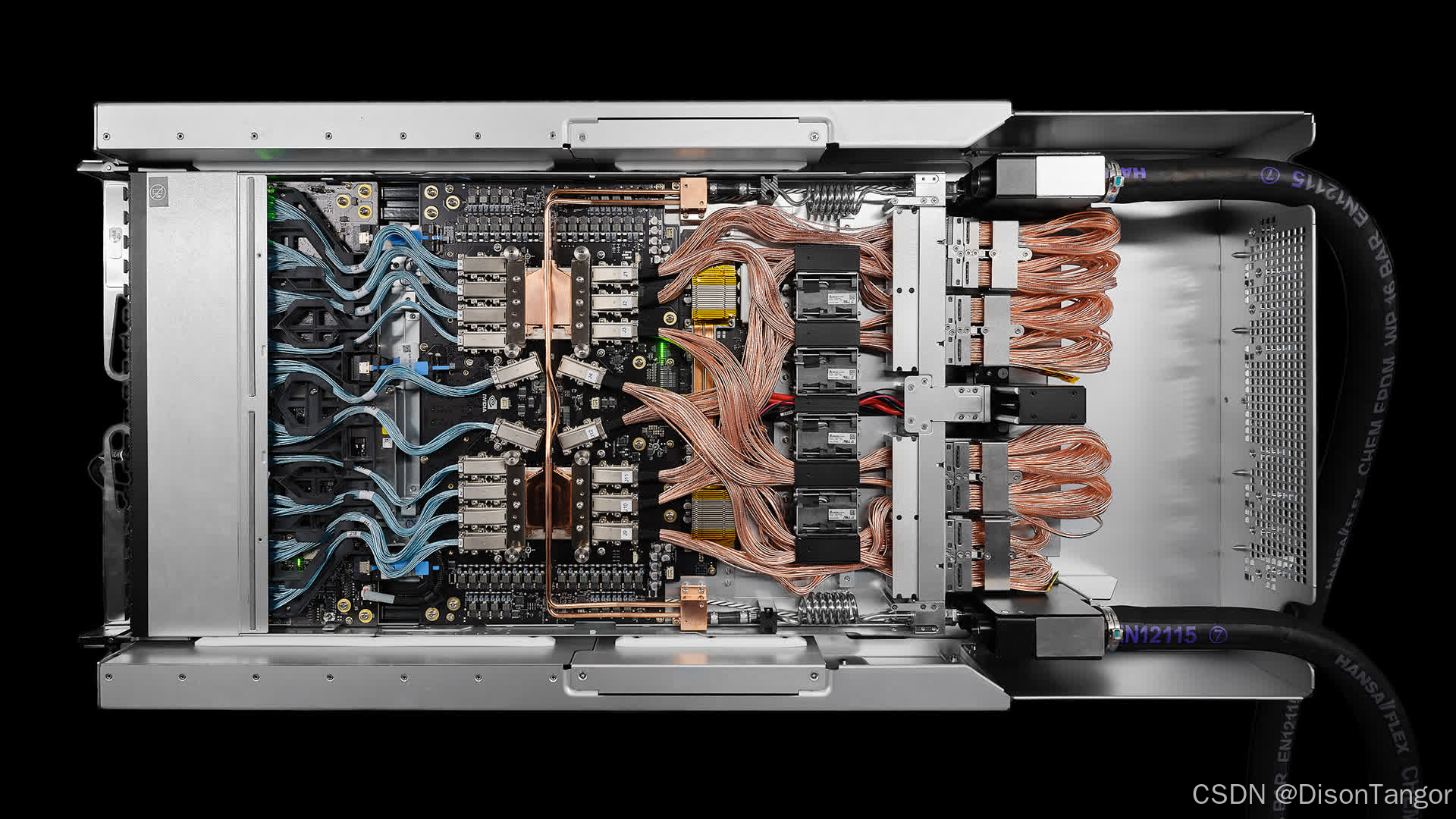

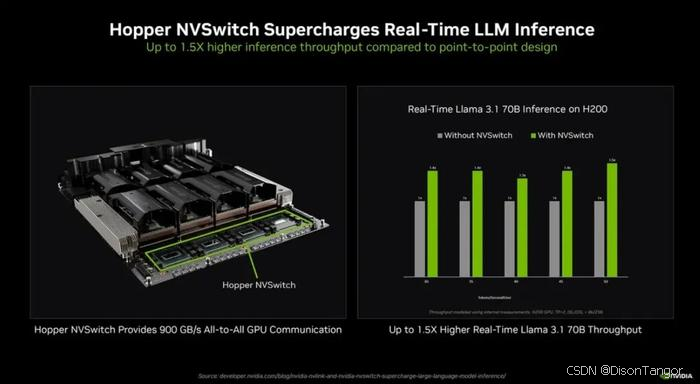

另一个焦点是NVIDIA GB200 NVL72,这是一个多节点液冷系统,配备72个Blackwell GPU和36个Grace CPU。与会者还将探索NVLink互连技术,该技术可促进GPU通信,实现卓越的吞吐量和低延迟推理。

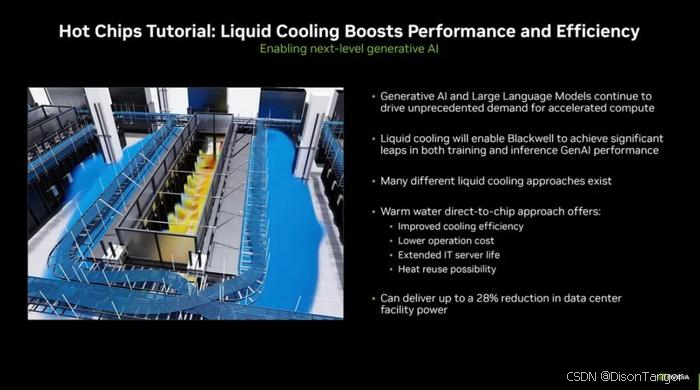

NVIDIA 在数据中心冷却方面的进展也将成为讨论的话题。该公司正在研究使用温水液体冷却,这种方法可以将功耗降低 28%。这种技术不仅能降低能源成本,还无需使用低于环境温度的冷却硬件,NVIDIA 希望借此成为可持续技术解决方案的领跑者。

为了配合这些努力,NVIDIA 将重点介绍其参与 COOLERCHIPS 计划的情况,该计划是美国能源部的一项倡议,旨在推动冷却技术的发展。通过该项目,NVIDIA 正在利用其 Omniverse 平台开发模拟能耗和冷却效率的数字孪生体。

在另一场会议上,NVIDIA 将讨论其使用的基于代理的人工智能系统,该系统能够自主执行芯片设计任务。人工智能代理的应用实例包括时序报告分析、单元集群优化和代码生成。值得注意的是,单元集群优化工作最近在首届电气和电子工程师协会 LLM 辅助设计国际研讨会上被评为最佳论文。

参考链接

https://www.tomshardware.com/tech-industry/artificial-intelligence/nvidia-shows-off-blackwell-server-installations-in-progress-ai-and-data-center-roadmap-has-blackwell-ultra-coming-next-year-with-vera-cpus-and-rubin-gpus-in-2026

感谢大家花时间阅读我的文章,你们的支持是我不断前进的动力。期望未来能为大家带来更多有价值的内容,请多多关注我的动态!