阅读量:0

目录

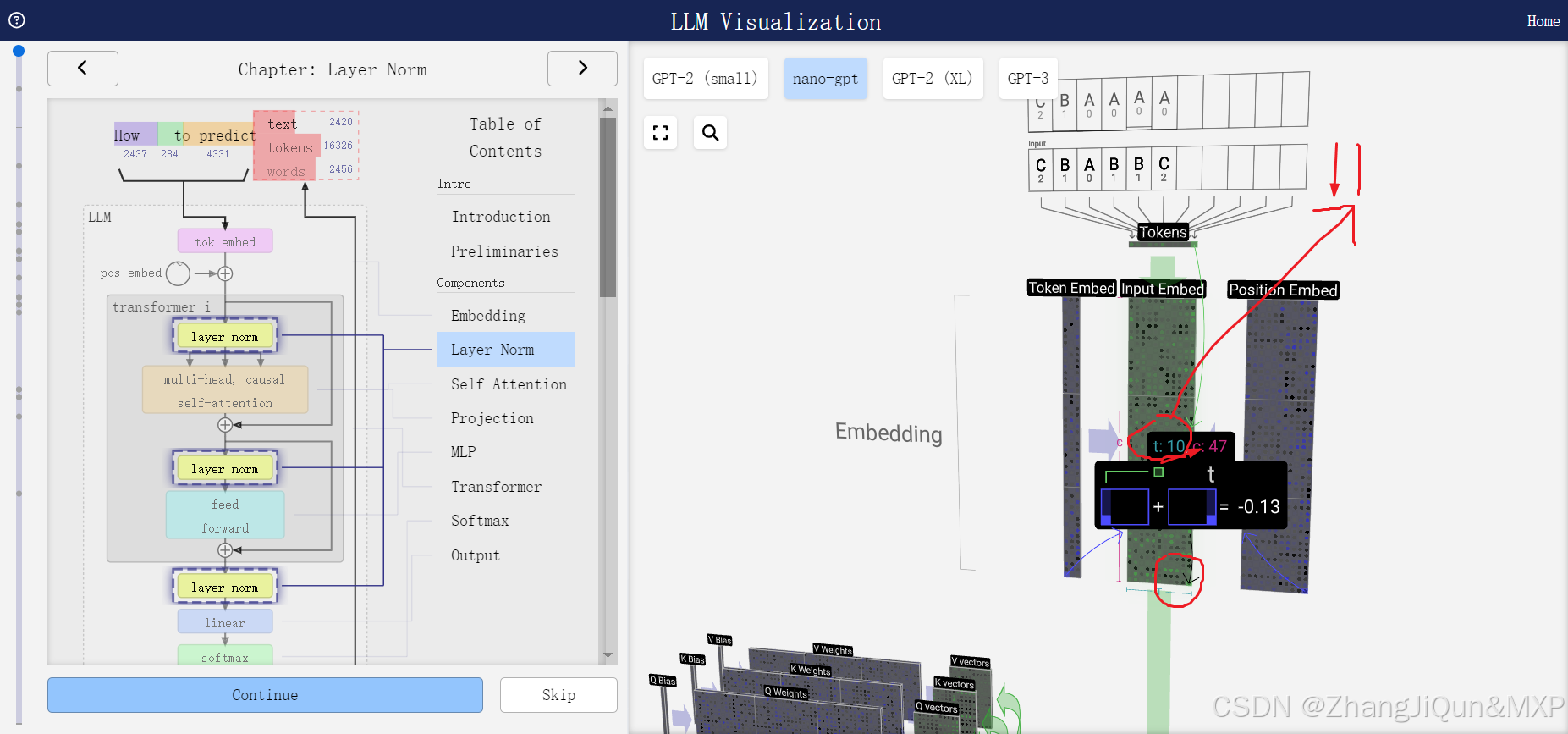

Layer Norm(Layer Normalization)

激活函数的实质作用:是调节结果分布,使结果趋于0或1,明确结果吗

4. MLP Projection Weights(MLP投影权重)

首先,我们需要澄清“LN Agg: μ, o”这一表述可能存在一定的误解或混淆,因为在深度学习和机器学习的上下文中,并没有直接对应的标准术语“LN Agg”。不过,我们可以从字面和可能的理解角度来解释,并结合“Layer Norm”来给出答案。

LN Agg: μ, o

- LN Agg:这个术语并不是深度学习或机器学习领域中的标准术语。如果将其拆解来看,“LN”可能指的是“Layer Normalization”(层归一化),而“Agg”可能是一个缩写或误解,没有直接对应的含义。不过,如果将其视为某种聚合或总结性的描述,我们可以理解为与Layer Normalization相关的某种统计量或结果。

- μ, σ:在Layer Normalization的上下文中,μ(mu)通常代表均值(mean),σ或sigma的平方,即σ²)代表方差