给大家的福利

零基础入门

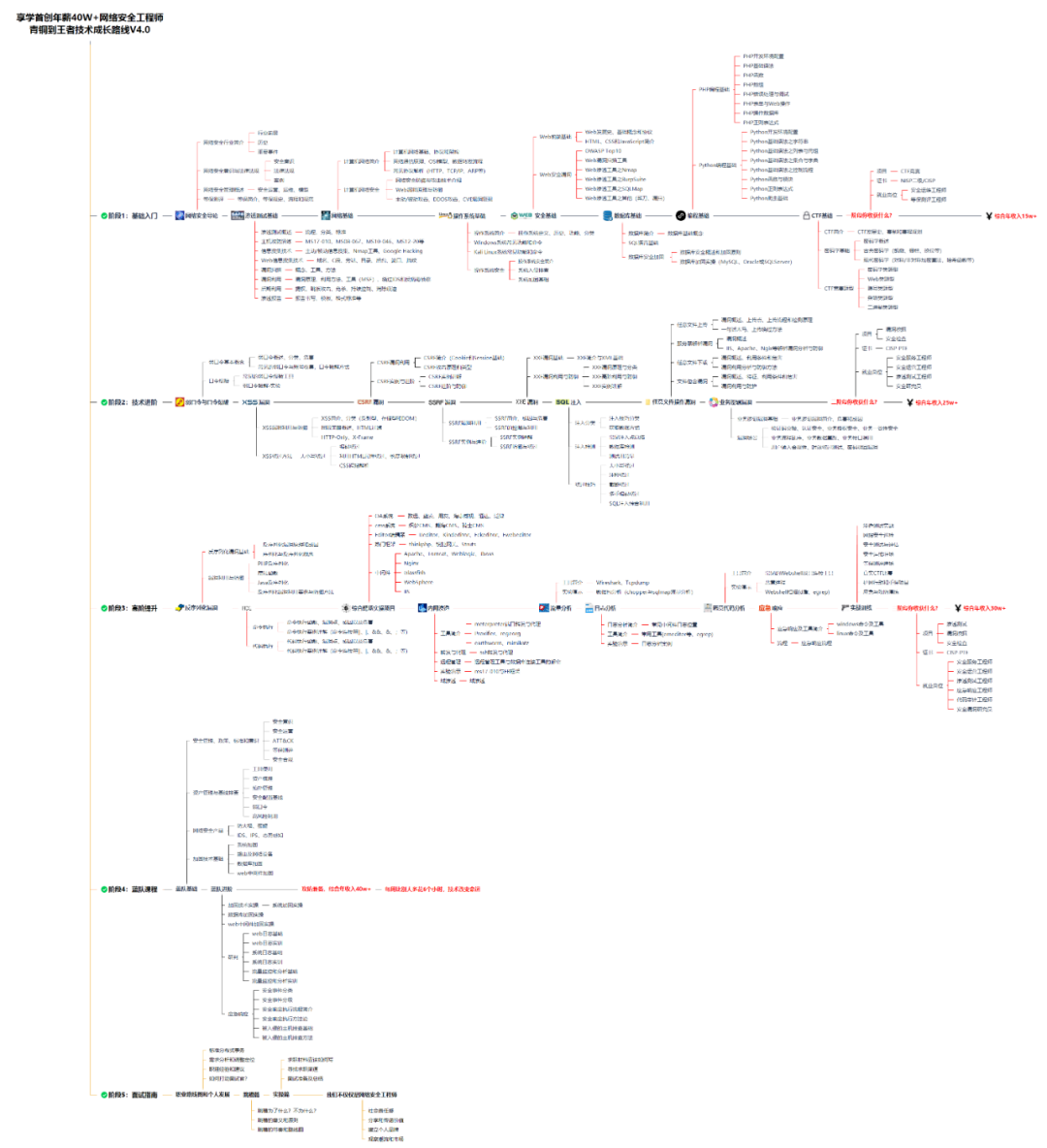

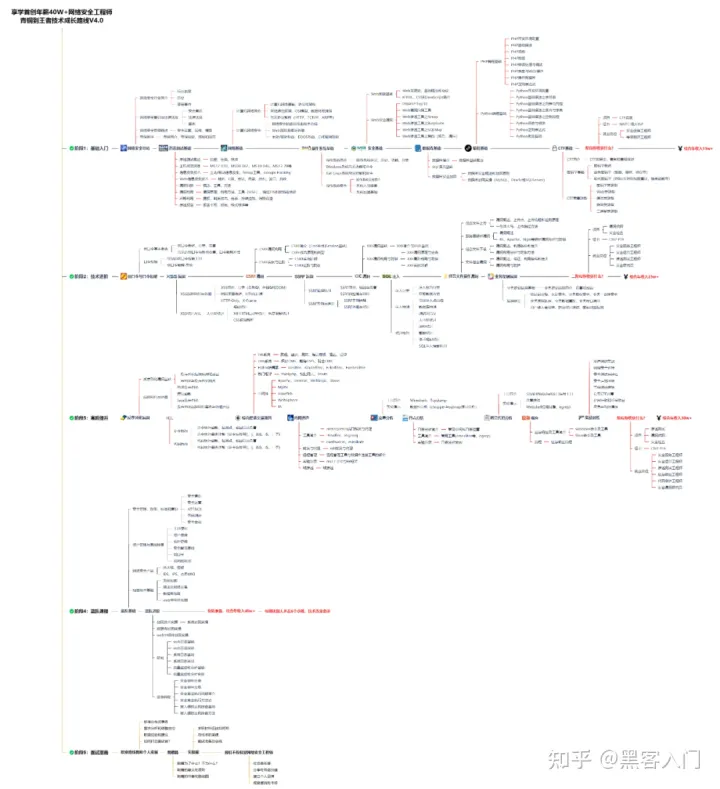

对于从来没有接触过网络安全的同学,我们帮你准备了详细的学习成长路线图。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

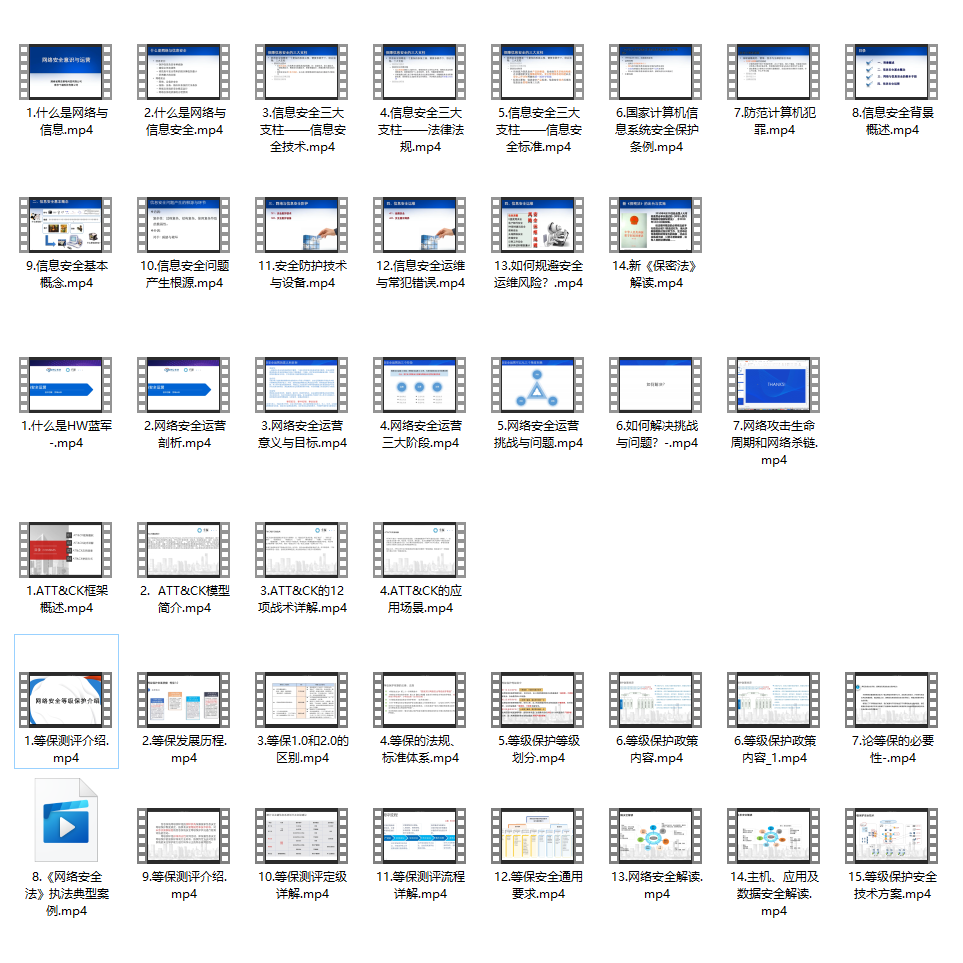

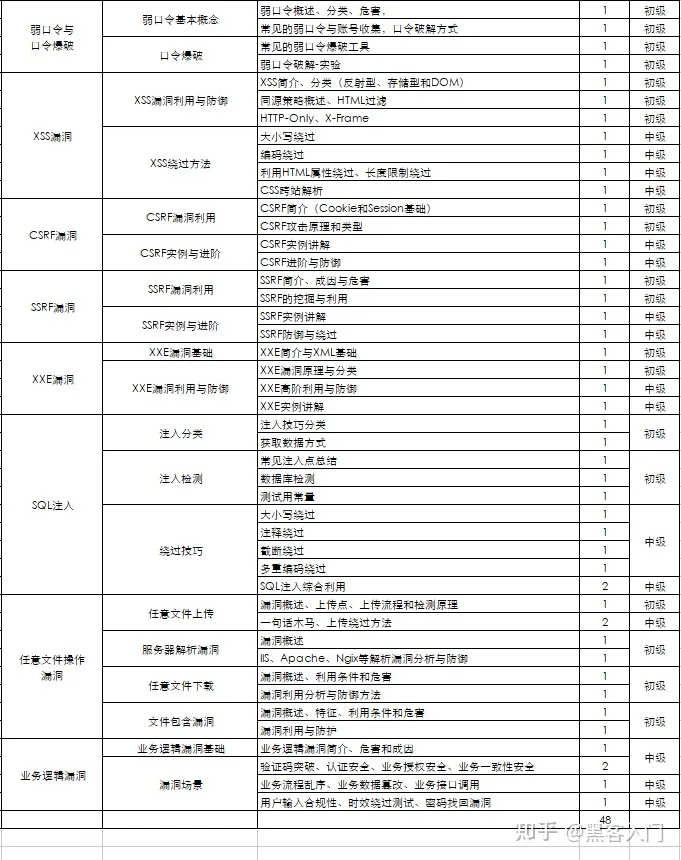

同时每个成长路线对应的板块都有配套的视频提供:

因篇幅有限,仅展示部分资料

需要体系化学习资料的朋友,可以加我V获取:vip204888 (备注网络安全)

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

准备3个kafka,分别是kafka01、kafka02、kafka03,分别到它们的config/kraft/server.properties中做配置:

kafka01的server.properties

process.roles=broker,controller node.id=1 controller.quorum.voters=1@localhost:19093,2@localhost:29093,3@localhost:39093 listeners=SASL_PLAINTEXT://:19092,CONTROLLER://:19093 sasl.enabled.mechanisms=PLAIN sasl.mechanism.inter.broker.protocol=PLAIN inter.broker.listener.name=SASL_PLAINTEXT advertised.listeners=SASL_PLAINTEXT://192.168.8.122:19092 controller.listener.names=CONTROLLER log.dirs=/wlh/kafka01/data kafka02

process.roles=broker,controller node.id=2 controller.quorum.voters=1@localhost:19093,2@localhost:29093,3@localhost:39093 listeners=SASL_PLAINTEXT://:29092,CONTROLLER://:29093 sasl.enabled.mechanisms=PLAIN sasl.mechanism.inter.broker.protocol=PLAIN inter.broker.listener.name=SASL_PLAINTEXT advertised.listeners=SASL_PLAINTEXT://192.168.8.122:29092 controller.listener.names=CONTROLLER log.dirs=/wlh/kafka02/data kafka03

process.roles=broker,controller node.id=3 controller.quorum.voters=1@localhost:19093,2@localhost:29093,3@localhost:39093 listeners=SASL_PLAINTEXT://:39092,CONTROLLER://:39093 sasl.enabled.mechanisms=PLAIN sasl.mechanism.inter.broker.protocol=PLAIN inter.broker.listener.name=SASL_PLAINTEXT advertised.listeners=SASL_PLAINTEXT://192.168.8.122:39092 controller.listener.names=CONTROLLER log.dirs=/wlh/kafka03/data 先确保你的kafka的数据目录是空的,执行下删除(后面初始化时会自动创建目录)

rm -rf /wlh/kafka01/data /wlh/kafka02/data /wlh/kafka03/data 创建一个kafka sasl认证的服务配置

可以在kafka的config目录下新建一个kafka_server_jaas.conf文件,然后认证信息写好:

KafkaServer { org.apache.kafka.common.security.plain.PlainLoginModule required serviceName="kafka" username="admin" password="eystar8888" user_kafka="kafka1234"; }; 上面的配置中声明了管理员为admin,密码是eystar8888,并且声明了一个用户名为kafka,密码是kafka1234的用户,客户端连接时使用用户为kafka可以成功进行认证。

而需要注意的是:上面的配置中的分号;,不能少,否则就掉坑里了。

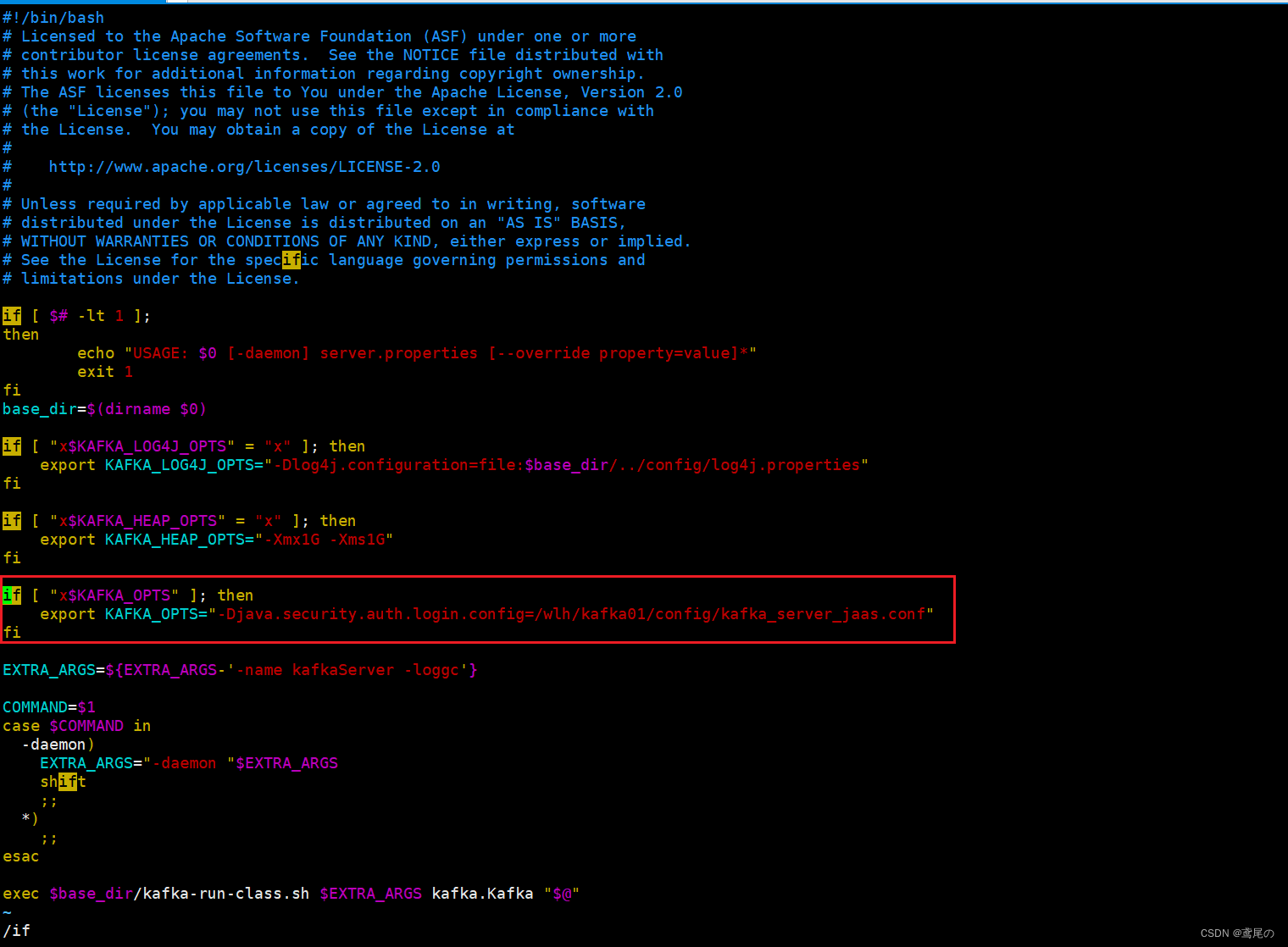

配置kafka服务的启动脚本

上面设置好sasl认证的配置后,我们需要在kafka启动的服务脚本中,将此配置加入进去。

可以直接修改bin/kafka-server-start.sh,亦或者拷贝一份kafka-server-start.sh命名为kafka-server-start-saal.sh(名称自定义即可)

export KAFKA\_OPTS="-Djava.security.auth.login.config=/wlh/kafka01/config/kafka\_server\_jaas.conf" kafka02和kafka03同样这样配置好

export KAFKA\_OPTS="-Djava.security.auth.login.config=/wlh/kafka02/config/kafka\_server\_jaas.conf" export KAFKA\_OPTS="-Djava.security.auth.login.config=/wlh/kafka03/config/kafka\_server\_jaas.conf" 开始执行启动kafka集群

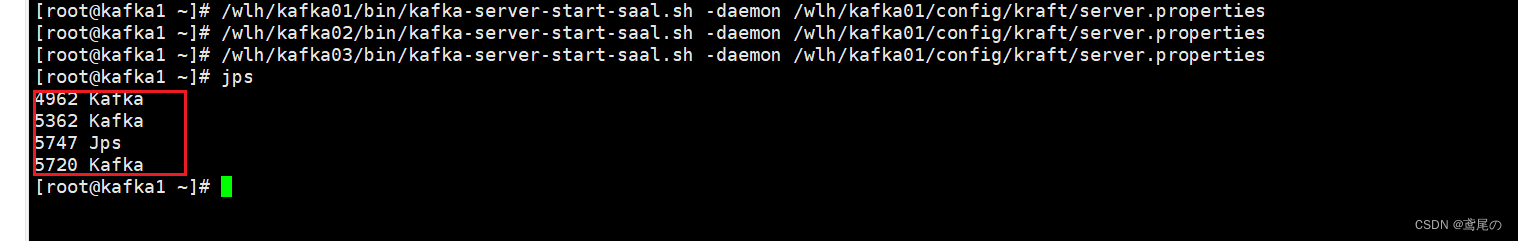

# 生成一个uuid,后面需要用 /wlh/kafka01/bin/kafka-storage.sh random-uuid # 格式化存储 /wlh/kafka01/bin/kafka-storage.sh format -t xtzWWN4bTjitpL3kfd9s5g -c /wlh/kafka01/config/kraft/server.properties /wlh/kafka02/bin/kafka-storage.sh format -t xtzWWN4bTjitpL3kfd9s5g -c /wlh/kafka02/config/kraft/server.properties /wlh/kafka03/bin/kafka-storage.sh format -t xtzWWN4bTjitpL3kfd9s5g -c /wlh/kafka03/config/kraft/server.properties 开始启动kafka(-daemon后台启动)

# 分别启动它们 /wlh/kafka01/bin/kafka-server-start-saal.sh -daemon /wlh/kafka01/config/kraft/server.properties /wlh/kafka02/bin/kafka-server-start-saal.sh -daemon /wlh/kafka02/config/kraft/server.properties /wlh/kafka03/bin/kafka-server-start-saal.sh -daemon /wlh/kafka03/config/kraft/server.properties

服务启动完成。。。

Tip:服务器端口要打开,服务器端口要打开,端口打开!!!或者关了防火墙也行。

使用java进行连接

无论是使用kafka的API还是直接使用spring集成kafka都是可以的。

我这里就采用kafka的API方式了。

导入kafka-clients依赖

<dependency> <groupId>org.apache.kafka</groupId> <artifactId>kafka-clients</artifactId> <version>2.7.2</version> </dependency> 在application.properties中配置相关属性,注意spring.kafka.jaas-config是结尾是有一个分号;的,若不写,是连接不到kafka的。

spring.kafka.bootstrap-servers=192.168.8.122:19092,192.168.8.122:29092,192.168.8.122:39092 spring.kafka.jaas-config=org.apache.kafka.common.security.plain.PlainLoginModule required username="kafka" password="kafka1234"; spring.kafka.topics=test 在java配置类中进行接收并且创建生产者和消费者

package xxx.xxx.xxx; import org.apache.kafka.common.config.SaslConfigs; import org.apache.kafka.common.security.auth.SecurityProtocol; import org.springframework.beans.factory.annotation.Value; import org.springframework.boot.autoconfigure.condition.ConditionalOnProperty; import org.springframework.stereotype.Component; import java.util.Properties; /\*\* \* @author wlh \* @date 2023/8/10 \*/ @ConditionalOnProperty("spring.kafka.bootstrap-servers") @Component public class KafkaProperties { @Value("${spring.kafka.bootstrap-servers}") private String bootstrapServer; @Value("${spring.kafka.jaas-config}") private String jaasConfig; public static String topics; @Value("${spring.kafka.topics}") private void setTopics(String topics) { KafkaProperties.topics = topics; } /\*\* \* 获取生产者配置 \* \* @return 配置信息 \*/ public Properties getProducerProperties() { Properties properties = new Properties(); properties.put("bootstrap.servers", bootstrapServer); String SERIALIZER = "org.apache.kafka.common.serialization.StringSerializer"; properties.put("key.serializer", SERIALIZER); properties.put("value.serializer", SERIALIZER); fillSecurityProperties(properties); return properties; } // 消费者配置 public Properties getConsumerProperties() { Properties properties = new Properties(); properties.put("bootstrap.servers", bootstrapServer); properties.put("group.id", "test"); // group.id可以自定义 String DESERIALIZER = "org.apache.kafka.common.serialization.StringDeserializer"; properties.put("key.deserializer", DESERIALIZER); properties.put("value.deserializer", DESERIALIZER); fillSecurityProperties(properties); return properties; } // 安全认证的配置 private void fillSecurityProperties(Properties properties) { properties.setProperty("security.protocol", SecurityProtocol.SASL\_PLAINTEXT.name); String SASL\_MECHANISM = "PLAIN"; properties.put(SaslConfigs.SASL\_MECHANISM, SASL\_MECHANISM); properties.put(SaslConfigs.SASL\_JAAS\_CONFIG, jaasConfig); } } 创建生产者和消费者

package xxx.xxx.xxx; import lombok.RequiredArgsConstructor; import lombok.extern.slf4j.Slf4j; import org.apache.kafka.clients.consumer.KafkaConsumer; import org.apache.kafka.clients.producer.KafkaProducer; import org.springframework.boot.autoconfigure.condition.ConditionalOnProperty; import org.springframework.context.annotation.Bean; import org.springframework.context.annotation.Configuration; import java.util.Arrays; import java.util.Collections; import java.util.List; /\*\* \* @author wlh \* @date 2023/08/10 \*/ @ConditionalOnProperty("spring.kafka.bootstrap-servers") @Slf4j @RequiredArgsConstructor @Configuration public class KafkaConfig { private final KafkaProperties kafkaProperties; // 创建生产者 @Bean public KafkaProducer<String, String> kafkaProducer() { return new KafkaProducer<>(kafkaProperties.getProducerProperties()); } // 创建消费者 @Bean public KafkaConsumer<String, String> kafkaConsumer() { KafkaConsumer<String, String> kafkaConsumer = new KafkaConsumer<> (kafkaProperties.getConsumerProperties()); List<String> topicList = Collections.singletonList("test"); // 这里写死了,可自行扩展 kafkaConsumer.subscribe(topicList); log.info("消息订阅成功! topic:{}", topicList); log.info("消费者配置:{}", kafkaProperties.getConsumerProperties().toString()); return kafkaConsumer; } } 信息发送的Util工具类

package xxx.xxx.xxx; import com.alibaba.excel.util.StringUtils; import com.alibaba.fastjson.JSON; import lombok.extern.slf4j.Slf4j; import org.apache.kafka.clients.producer.KafkaProducer; import org.apache.kafka.clients.producer.ProducerRecord; import org.springframework.beans.factory.annotation.Autowired; import org.springframework.scheduling.annotation.Async; import org.springframework.stereotype.Component; import java.util.Arrays; import java.util.Collections; import java.util.List; @Component @Slf4j public class KafkaSendUtil { @Autowired KafkaProducer<String, String> kafkaProducer; @Async public void sendMsg(String topic, String msg) { List<String> topics; if (StringUtils.isBlank(topic)) { topics = Arrays.asList(KafkaProperties.topics.split(",")); } else { topics = Collections.singletonList(topic); } for (String sendTopic : topics) { ProducerRecord<String, String> record = new ProducerRecord<>(sendTopic, msg); log.info("正在发送kafka数据,数据=====>{}", msg); kafkaProducer.send(record); } } } 实例

简单做一个实例,调通一下数据。监听方式可以不按照本文的,本文只是做测试。

如何自学黑客&网络安全

黑客零基础入门学习路线&规划

初级黑客

1、网络安全理论知识(2天)

①了解行业相关背景,前景,确定发展方向。

②学习网络安全相关法律法规。

③网络安全运营的概念。

④等保简介、等保规定、流程和规范。(非常重要)

2、渗透测试基础(一周)

①渗透测试的流程、分类、标准

②信息收集技术:主动/被动信息搜集、Nmap工具、Google Hacking

③漏洞扫描、漏洞利用、原理,利用方法、工具(MSF)、绕过IDS和反病毒侦察

④主机攻防演练:MS17-010、MS08-067、MS10-046、MS12-20等

3、操作系统基础(一周)

①Windows系统常见功能和命令

②Kali Linux系统常见功能和命令

③操作系统安全(系统入侵排查/系统加固基础)

4、计算机网络基础(一周)

①计算机网络基础、协议和架构

②网络通信原理、OSI模型、数据转发流程

③常见协议解析(HTTP、TCP/IP、ARP等)

④网络攻击技术与网络安全防御技术

⑤Web漏洞原理与防御:主动/被动攻击、DDOS攻击、CVE漏洞复现

5、数据库基础操作(2天)

①数据库基础

②SQL语言基础

③数据库安全加固

6、Web渗透(1周)

①HTML、CSS和JavaScript简介

②OWASP Top10

③Web漏洞扫描工具

④Web渗透工具:Nmap、BurpSuite、SQLMap、其他(菜刀、漏扫等)

恭喜你,如果学到这里,你基本可以从事一份网络安全相关的工作,比如渗透测试、Web 渗透、安全服务、安全分析等岗位;如果等保模块学的好,还可以从事等保工程师。薪资区间6k-15k

到此为止,大概1个月的时间。你已经成为了一名“脚本小子”。那么你还想往下探索吗?

如果你想要入坑黑客&网络安全,笔者给大家准备了一份:282G全网最全的网络安全资料包评论区留言即可领取!

7、脚本编程(初级/中级/高级)

在网络安全领域。是否具备编程能力是“脚本小子”和真正黑客的本质区别。在实际的渗透测试过程中,面对复杂多变的网络环境,当常用工具不能满足实际需求的时候,往往需要对现有工具进行扩展,或者编写符合我们要求的工具、自动化脚本,这个时候就需要具备一定的编程能力。在分秒必争的CTF竞赛中,想要高效地使用自制的脚本工具来实现各种目的,更是需要拥有编程能力.

如果你零基础入门,笔者建议选择脚本语言Python/PHP/Go/Java中的一种,对常用库进行编程学习;搭建开发环境和选择IDE,PHP环境推荐Wamp和XAMPP, IDE强烈推荐Sublime;·Python编程学习,学习内容包含:语法、正则、文件、 网络、多线程等常用库,推荐《Python核心编程》,不要看完;·用Python编写漏洞的exp,然后写一个简单的网络爬虫;·PHP基本语法学习并书写一个简单的博客系统;熟悉MVC架构,并试着学习一个PHP框架或者Python框架 (可选);·了解Bootstrap的布局或者CSS。

8、超级黑客

这部分内容对零基础的同学来说还比较遥远,就不展开细说了,附上学习路线。

网络安全工程师企业级学习路线

如图片过大被平台压缩导致看不清的话,评论区点赞和评论区留言获取吧。我都会回复的

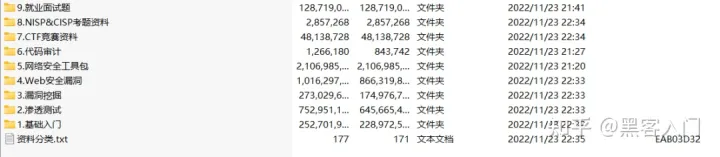

视频配套资料&国内外网安书籍、文档&工具

需要体系化学习资料的朋友,可以加我V获取:vip204888 (备注网络安全)

当然除了有配套的视频,同时也为大家整理了各种文档和书籍资料&工具,并且已经帮大家分好类了。

一些笔者自己买的、其他平台白嫖不到的视频教程。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!