网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

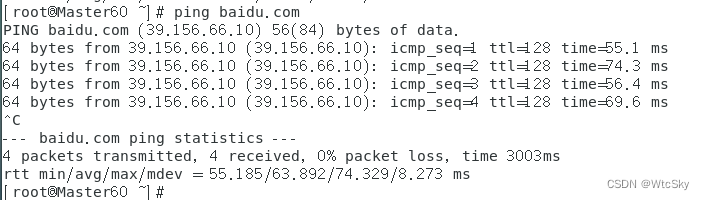

从机也需要验证,如果哪台机器ping不通请查看3.3以及5.3的解决方法或自行百度。

6.2 方法二:通过FireFox访问百度

这种方法需要再安装CentOS的时候选择了GUI界面(参考2.3)

然后输入www.baidu.com,看是否能成功访问,以下是成功界面:

7. 免密安全登录

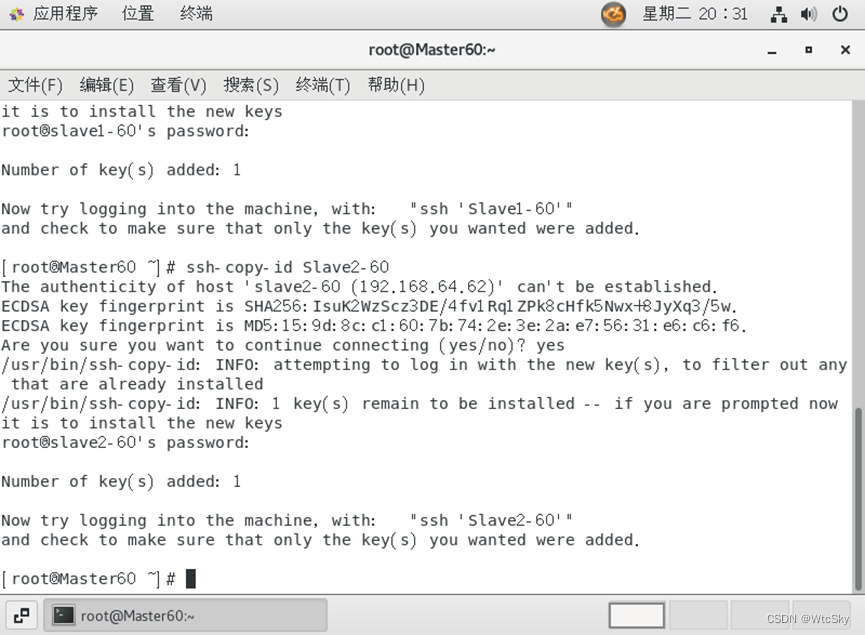

7.1 生成秘钥及分享秘钥

该操作需要重复三次(实验需要一个Master两个Slave……)

以主机为例,在终端依次使用以下指令生成秘钥然后分享给除了自己以外的另外两台机器:

ssh-keygen -t rsa(然后一直回车)ssh-copy-id Slave1-60(Slave1-60修改为你的从机1的主机名或IP)ssh-copy-id Slave2-60(Slave1-60修改为你的从机2的主机名或IP)

步骤2、3需要输入yes,然后再输入密码(123456),密码不会显示(Linux特性)。

两个从机重复以上操作。

之后在**主机(Master)**进行如下操作(这一步从机不需要):

cd .ssh(目前所在路径是~)touch authorized_keyschmod 600 authorized_keyscat id_rsa.pub >> authorized_keys

这一步是为了之后做准备的……

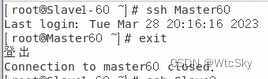

7.2 测试是否成功

以从机1为例,在终端使用指令ssh Master60(改为自己主机的主机名)或者`ssh 192.168.64.610(改为自己主机的IP)。

可以发现此时不需要键入密码就可以登录。

8. Hadoop集群设计与部署

OK,这一步的难度大于前面七步的和,尽量说的详细一点。

该操作需要重复三次(实验需要一个Master两个Slave……)

8.1 下载Hadoop-3.3.1

我用的是Hadoop-3.3.1,下面的操作只要是Hadoop-3.x应该都是适用的,但是Hadoop-2.x可能有细枝末节的地方不太相同,建议看一下PushyTao学长的博客。

建议是在自己的电脑上而不是虚拟机上下载,因为每台虚拟机都需要一份,所以直接下在自己电脑桌面上然后拖到虚拟机里就可以了。

下面给出两个镜像站地址,哪个快下哪个吧(3.3.1可能已经不能用了大概3.x就可以):

以阿里云镜像站为例,要下载的是hadoop-3.3.1.tar.gz。

8.2 创建目录解压Hadoop

首先mkdir /user(现在的路径是~)

然后直接复制以下指令到终端(鼠标中键粘贴)

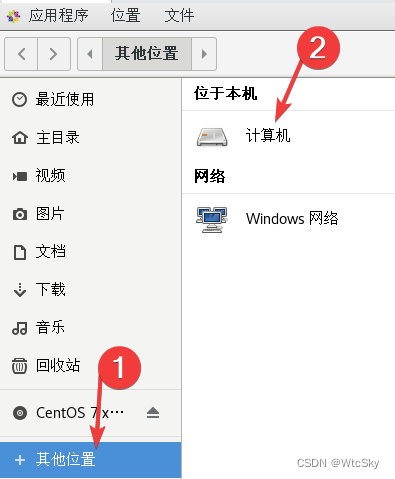

mkdir /user/hadoop mkdir /user/hadoop/tmp mkdir /user/hadoop/var mkdir /user/hadoop/dfs mkdir /user/hadoop/dfs/name mkdir /user/hadoop/dfs/data 方便起见,后面的操作用GUI进行,点击应用程序,选择文件。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-zA2pArY5-1680265800507)(C:\Users\dell\Documents\ShareX\Screenshots\2023-03\vmware_mXMFpi9xHu.png)]](/zb_users/upload/2024/csdn/04e437eb5d7b4f11b1fb8f2e306d4f1b.png)

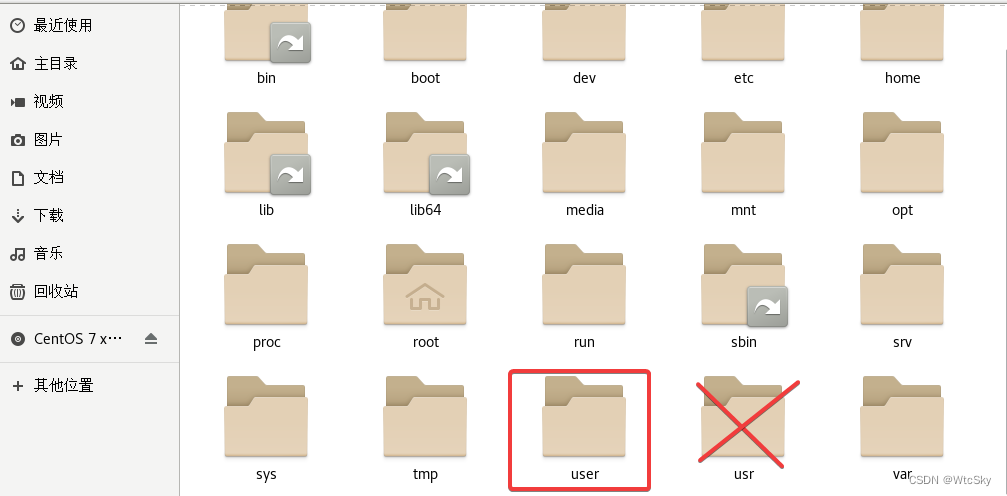

点击其他位置,然后选择计算机。

找到user文件夹点击进入,注意是user不是usr。

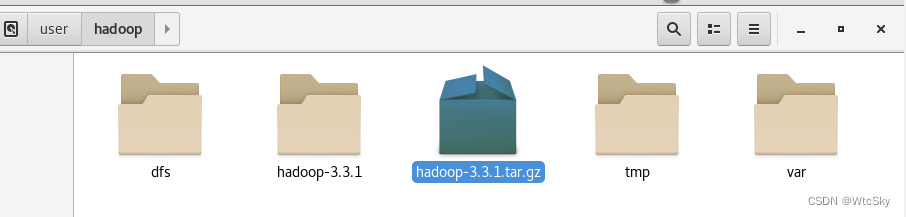

进入里面的hadoop目录,然后把电脑上的压缩包拖进来(下面的图是解压完成的)

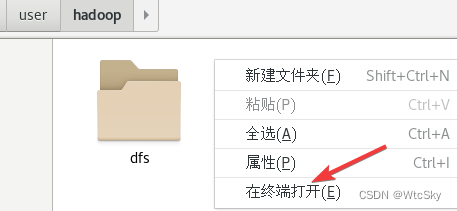

然后在这个界面右键选择在终端打开。

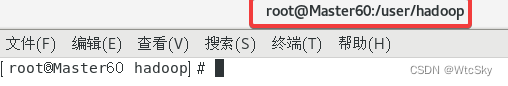

这时候我终端的位置是这个目录:

然后输入指令tar -zxvf hadoop-3.3.1.tar.gz进行解压。

8.3 配置环境变量

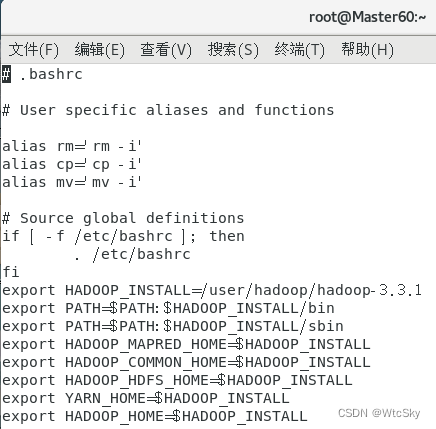

在终端使用指令vi ~/.bashrc。

在最后键入i进行插入,需要修改的只有第一行HADOOP_INSTALL,把它改成自己Hadoop的位置就好了(含有bin、etc、……的目录)。

export HADOOP_INSTALL=/user/hadoop/hadoop-3.3.1 export PATH=$PATH:$HADOOP_INSTALL/bin export PATH=$PATH:$HADOOP_INSTALL/sbin export HADOOP_MAPRED_HOME=$HADOOP_INSTALL export HADOOP_COMMON_HOME=$HADOOP_INSTALL export HADOOP_HDFS_HOME=$HADOOP_INSTALL export YARN_HOME=$HADOOP_INSTALL export HADOOP_HOME=$HADOOP_INSTALL

:wq保存退出。

然后在终端输入指令source ~/.bashrc

8.4 找到JDK位置

其实这个地方是搞错了的这里用的是JRE(运行包),而不是JDK(开发包),其中开发包是包含了运行包。但是后面的操作只需要运行即可,就是说不会影响到后续操作。我会在下一个实验的时候进行修正,或者到这一步时同学们可以自行下载JDK

这个CentOS是自带了一个JDK确实是能用的,所以我也不另外下载了,找到这个JDK就可以了。

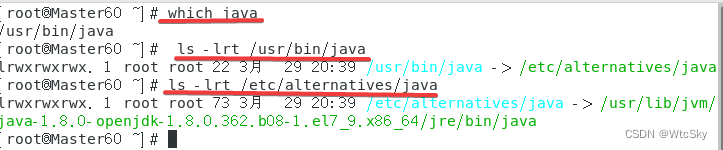

依次使用指令:

which java获得一个地址/usr/bin/javals -lrt /usr/bin/java,根据前面得到的地址修改,会获得另一个地址/etc/alternatives/javals -lrt /etc/alternatives/java,根据前面得到的地址修改,最终得到的就是jdk的位置。

比如我找到的是java-1.8.0-openjdk-1.8.0.242.b08-1.el7.x86_64,但实际上每个人可能有所差别,以自己的为准!

上面显示0.362是因为后面的操作应该是有了一个新的版本但是为了还原,我还是说我的过程吧。

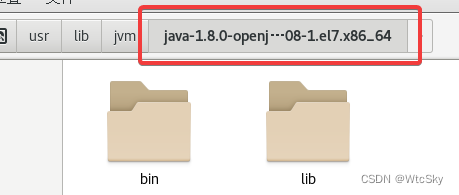

点进去这个这个目录,把里面jre的bin和lib给复制出来。

不搞出来之后会报错,JAVA_HOME需要这俩东西应该是,如果重新下jdk也差不多这么个意思。

8.5 修改主机配置文件

在做这一步之前先确保主机和两台从机都完成了以上操作,然后在主机上完成以下操作。

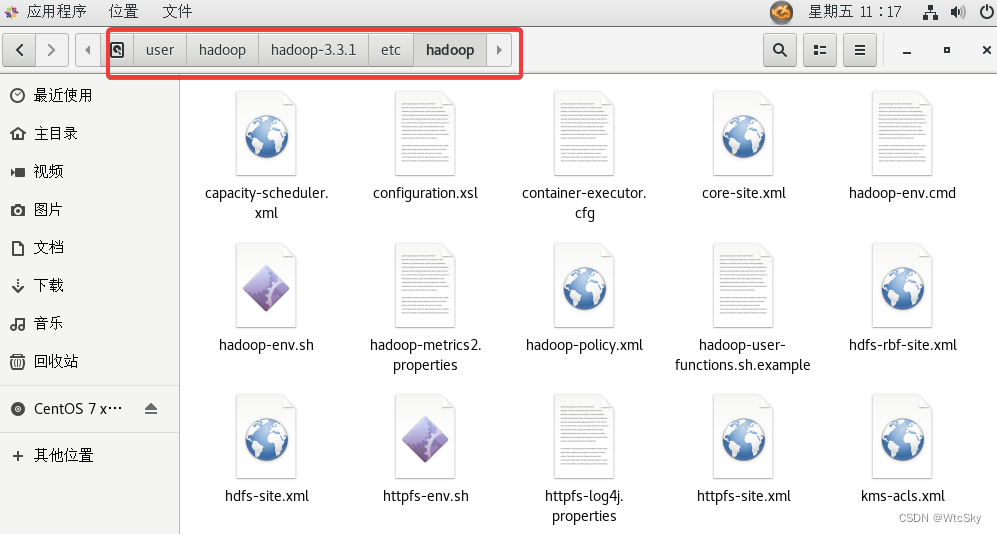

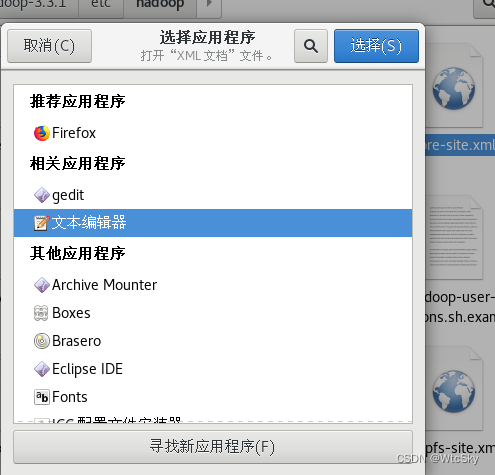

用GUI来完成吧,首先进入 /user/hadoop/hadoop-3.3.1/etc/hadoop/目录

这样的文件修改不同于VI而类似于windows系统的记事本。

复制粘贴都用鼠标就可以了。保存是ctrl+s。

8.5.1 hadoop-env.sh修改

打开hadoop-env.sh

在文件最后添加:

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.242.b08-1.el7.x86_64 export HADOOP_HOME=/user/hadoop/hadoop-3.3.1 export HDFS_NAMENODE_USER="root" export HDFS_DATANODE_USER="root" export HDFS_SECONDARYNAMENODE_USER="root" export YARN_RESOURCEMANAGER_USER="root" export YARN_NODEMANAGER_USER="root" 其中JAVA_HOME和HADOOP_HOME请根据自己情况来写。

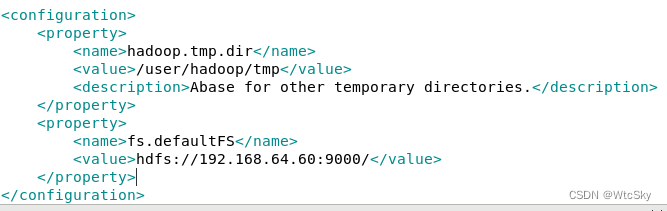

8.5.2 core-site.xml修改

打开core-site.xml

在<configuration></configuration>之间输入下面的内容:

<property> <name>hadoop.tmp.dir</name> <value>/user/hadoop/tmp</value> <description>Abase for other temporary directories.</description> </property> <property> <name>fs.defaultFS</name> <value>hdfs://192.168.64.60:9000/</value> </property>

根据自己情况修改value标签内的内容。

8.5.3 hdfs-site.xml修改

打开hdfs-site.xml

在最后加入以下内容:

<configuration> <property> <name>yarn.resourcemanager.admin.address</name> <value>192.168.64.60:9001</value> </property> <property> <name>dfs.name.dir</name> <value>/user/hadoop/dfs/name</value> <description>Path on the local filesystem where theNameNode stores the namespace and transactions logs persistently.</description> </property> <property> <name>dfs.data.dir</name> <value>/user/hadoop/dfs/data</value> <description>Comma separated list of paths on the localfilesystem of a DataNode where it should store its blocks.</description> </property> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.permissions</name> <value>false</value> <description>need not permissions</description> </property> </configuration> 上面内容提供了<configuration></configuration>,把之前的删了就好了。

还是把value标签自己改了。

8.5.4 yarn-site.xml修改

打开yarn-site.xml

<configuration> <!-- Site specific YARN configuration properties --> <property> <description>The address of the applications manager interface in the RM.</description> <name>yarn.resourcemanager.address</name> <value>192.168.64.60:8032</value> </property> <property> <description>The address of the scheduler interface.</description> <name>yarn.resourcemanager.scheduler.address</name> <value>192.168.64.60:8030</value> </property> <property> <description>The http address of the RM web application.</description> <name>yarn.resourcemanager.webapp.address</name> <value>192.168.64.60:8088</value> </property> <property> <name>yarn.resourcemanager.resource-tracker.address</name> <value>192.168.64.60:8031</value> </property> <property> <description>The address of the RM admin interface.</description> <name>yarn.resourcemanager.admin.address</name> <value>192.168.64.60:8033</value> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.nodemanager.auxservices.mapreduce.shuffle.class</name> <value>org.apache.hadoop.mapred.ShuffleHandler</value> </property> <property> <name>yarn.scheduler.maximum-allocation-mb</name> <value>2048</value> <discription>every node memery size(MB) default is 8182MB</discription> </property> <property> <name>yarn.nodemanager.resource.memory-mb</name> <value>2048</value> </property> <property> <name>yarn.nodemanager.vmem-check-enabled</name> <value>false</value> </property> </configuration> 修改value的IP地址。

8.5.5 mapred-site.xml修改

打开mapred-site.xml

<configuration> <property> <name>mapred.job.tracker</name> <value>192.168.64.60:49001</value> </property> <property> <name>mapred.local.dir</name> <value>/user/hadoop/var</value> </property> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> </configuration> 修改value中的ip及位置。

8.5.6 workers修改

打开workers

Slave1-60 Slave2-60 把两个从节点的主机名或者IP存进去。

最后输入hdfs如果没有ERROR就是成功;如果失败根据提示来看什么变量设置错误了,再改包括.bashrc在内的配置文件。注意hdfs指令可以使用只能代表你的Hadoop路径和JAVA_HOME设置成功,不代表一定能运行Hadoop,还得看配置文件是否正确。

8.6 分享主机配置文件

在/user/hadoop/hadoop-3.3.1/etc/hadoop/目录下打开终端。

之前已经设置了SSH免密登录,现在就派到用场了(当然这不是主要的),我可以直接把主机的文件分享到从机上。

直接复制以下指令到终端(鼠标中键),其中需要修改的是Slave1-60(改为自己的从机主机名或ip),后面的是存放在从机的地址(必须先在从机上完成8.1-8.4保证从机有这个目录)。

scp hadoop-env.sh root@Slave1-60:/user/hadoop/hadoop-3.3.1/etc/hadoop/ scp core-site.xml root@Slave1-60:/user/hadoop/hadoop-3.3.1/etc/hadoop/ scp hdfs-site.xml root@Slave1-60:/user/hadoop/hadoop-3.3.1/etc/hadoop/ scp mapred-site.xml root@Slave1-60:/user/hadoop/hadoop-3.3.1/etc/hadoop/ scp yarn-site.xml root@Slave1-60:/user/hadoop/hadoop-3.3.1/etc/hadoop/ scp workers root@Slave1-60:/user/hadoop/hadoop-3.3.1/etc/hadoop/ 如果配置错误了需要修改,直接重新键入指令就可以了,会自动覆盖。

然后再传递给从机2一份:

scp hadoop-env.sh root@Slave2-60:/user/hadoop/hadoop-3.3.1/etc/hadoop/ scp core-site.xml root@Slave2-60:/user/hadoop/hadoop-3.3.1/etc/hadoop/ scp hdfs-site.xml root@Slave2-60:/user/hadoop/hadoop-3.3.1/etc/hadoop/ scp mapred-site.xml root@Slave2-60:/user/hadoop/hadoop-3.3.1/etc/hadoop/ scp yarn-site.xml root@Slave2-60:/user/hadoop/hadoop-3.3.1/etc/hadoop/ scp workers root@Slave2-60:/user/hadoop/hadoop-3.3.1/etc/hadoop/ 8.7 格式化Hadoop

该操作需要重复三次(实验需要一个Master两个Slave……)

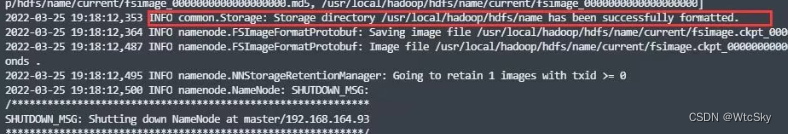

在每台虚拟机上都使用终端输入指令hdfs namenode -format。

如果失败请查看自己的配置文件是否全部修改正确!Hadoop地址、JAVA_HOME之类的请仔细对照自己的实际情况!

如果成功,会出现以下界面:

所有的机器都完成了初始化之后进行下一步。

8.8 启动Hadoop

进入/user/hadoop/hadoop-3.3.1/sbin目录(如果自己能搞明白自己在什么目录完全可以自己掌控,以下的操作完全可以 在~路径下./user/hadoop/hadoop-3.3.1/sbin/start-all.sh)

在sbin目录下右键进入终端,使用指令./start-all.sh启动Hadoop

8.9 验证是否完成

在终端使用输入jps,如果显示bash: jps: command not found...,就使用指令yum install -y java-1.8.0-openjdk-devel。如果仍然不成功,看一下配置文件的IP和路径是不是与自己的匹配。

如果在主机使用jps可以看到如下进程:

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-klChZqkf-1680265800510)(C:\Users\dell\Documents\ShareX\Screenshots\2023-03\PotPlayerMini64_xGY3fjBDpa.png)]](/zb_users/upload/2024/csdn/bc74bd78a4d8490abe165fd95103fffa.png)

并且在两个从机使用jps可以看到如下进程:

就说明完成了任务。

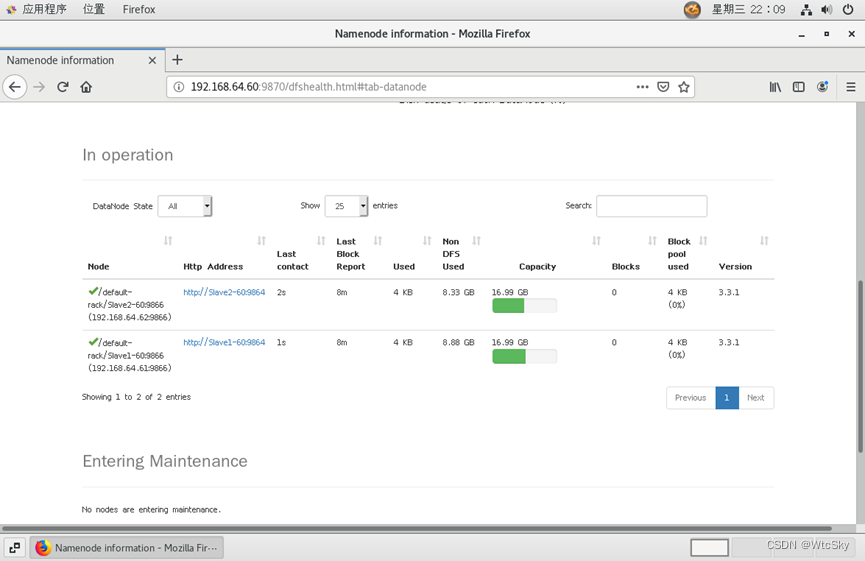

8.10 浏览器查看集群

操作在主机上

此时通过浏览器访问192.168.64.60:9870来查看(主机的主机名或IP:9870)。

8.11 ★解决浏览器无法查看集群

可以尝试使用192.168.64.60:50070,Hadoop2.x使用的是50070端口。

如果还不行,看看防火墙是否关闭。一定是jps都显示上述的进程该网页才会生效。

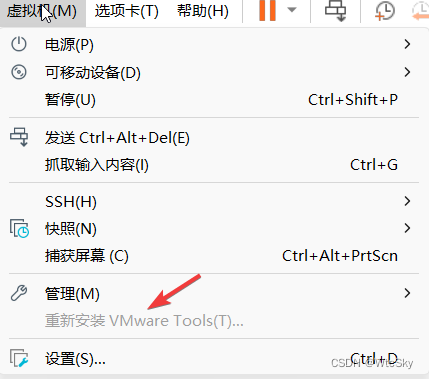

8.12 ★虚拟机拖拽文件

需要安装VMware Tools,具体怎么做不多做说明,安装完成就能直接传输文件了。

往虚拟机中拖文件可能会报错,点一下重试就好了。

8.13 ★解决Hadoop集群部署不成功

一般来说就是没有datanode或者namenode之类的问题,常见于是复制别人的文件、重新装了一遍Hadoop。

有两种情况:

一种是你的配置文件有问题,IP或者自己的Hadoop路径没有写对(认真核查!一个字母错误都可能导致无法成功!),找到错误然后重新分享(参照8.6)

另外一种情况是有旧的信息还在虚拟机上,这种情况按照以下方法来解决:

之前我们创建了下面的几个目录

mkdir /user/hadoop mkdir /user/hadoop/tmp mkdir /user/hadoop/var mkdir /user/hadoop/dfs mkdir /user/hadoop/dfs/name mkdir /user/hadoop/dfs/data 把三台虚拟机上/user/hadoop目录中的 tmp、var、dfs(不包括name和data)、dfs/name、dfs/data里面的内容全部清除,也就是说保持最初的状态,这一步是为了清空之前初始化产生的一些信息数据。

再重新在三台虚拟机上格式化Hadoop(参照8.7)。

9. Eclipse访问Hadoop

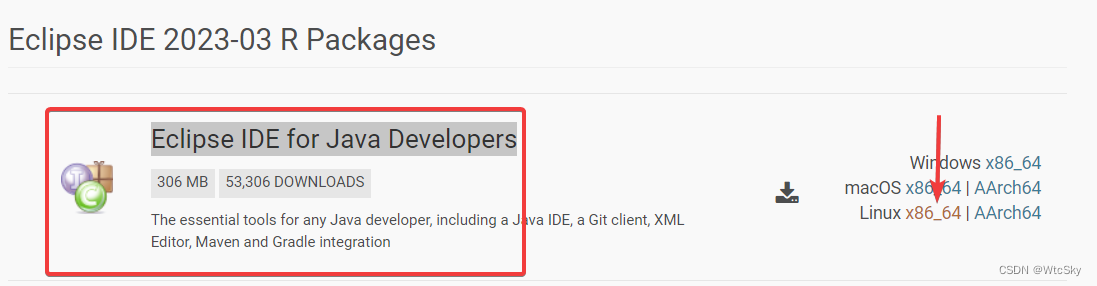

9.1 下载Eclipse

在官网下载:Eclipse IDE for Java Developers,选择Linux x86_64。

这个只需要拖到主机Master上就可以了。

有了上面的经验,把这个压缩包拖到/opt目录下应该不成问题。

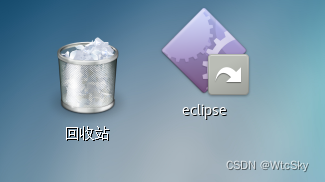

之后在/opt目录下打开终端,使用解压指令tar zxvf eclipse-java-2023-03-R-linux-gtk-x86_64.tar.gz,这时候会有一个eclipse文件被解压到/opt。

点击(或者指令)进入/opt/eclipse,然后在该文件下打开终端,使用指令ln -s /opt/eclipse/eclipse /usr/bin/eclipse,此时再去/usr/bin目录下将eclipse拖到桌面即可。

现在直接点击eclipse就可以使用了,打开使用的时候什么都不要改!默认的工作空间也没有必要改,直接进入。

9.2 配置eclipse

下载hadoop-eclipse-plugin-3.3.1,不需要解压放在/opt/eclipse路径下的dropins和plugins中。

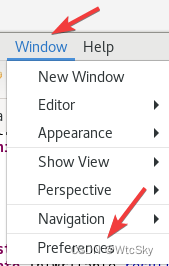

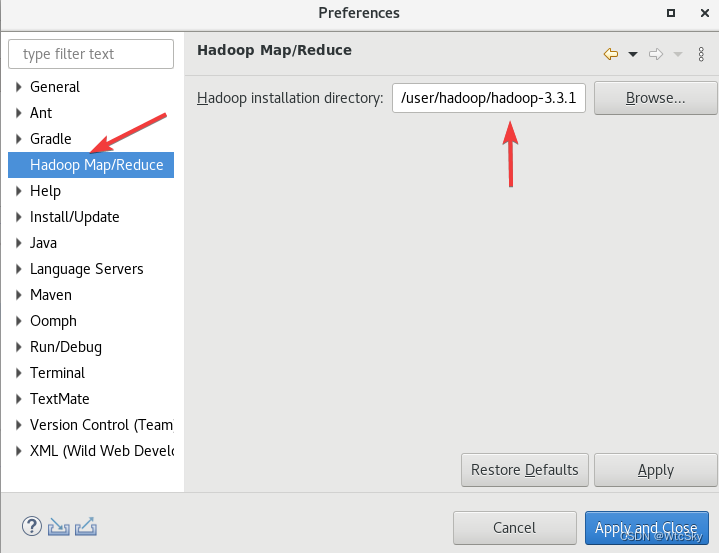

打开eclipse,在菜单栏选择Window->Preferences。

然后在左侧选择Hadoop Map/Reduce,选择Hadoop的安装路径(按照自己的来)

最后Apply and Close。

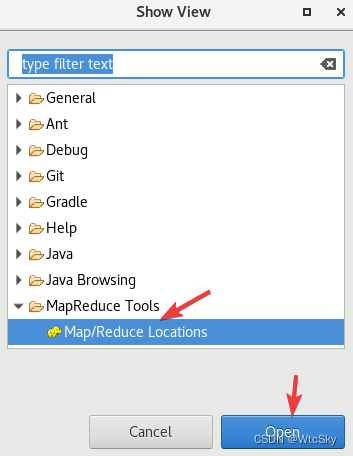

之后在菜单栏选择Window->Show View->Other。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-EJYF1arQ-1680265800512)(C:\Users\dell\AppData\Roaming\Typora\typora-user-images\image-20230331150019504.png)]](/zb_users/upload/2024/csdn/29be9b3d03c04cb488b8d588fa36dc88.png)

选择MapReduce Tools->Map/Reduce Locations,点击Open

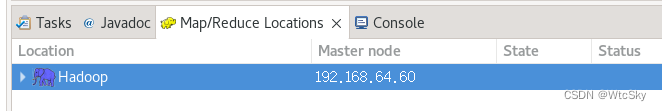

9.3 eclipse连接Hadoop

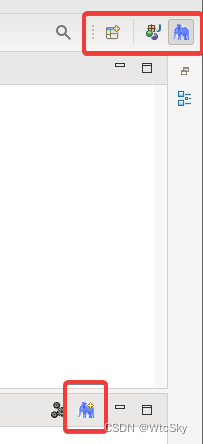

此时,会发现右上角出现大象(如果没有点击左侧第一个摁扭,里面可以打开),点击一下,下面会出现大象和+。

点击下面的大象和+

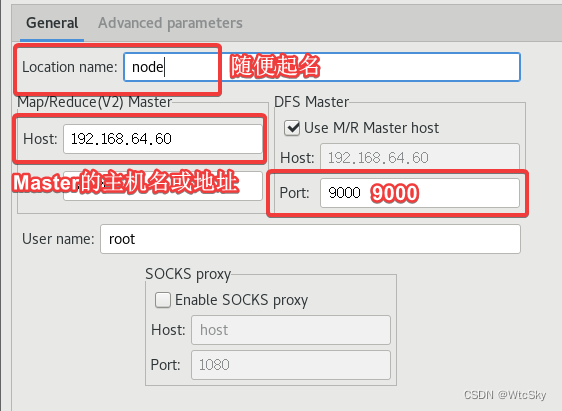

按照上图设置一下,点击Finish,下面会出现一条信息。这个大象双击以后会报错,不影响后面的操作,不需要理会配置好自己的ip即可。

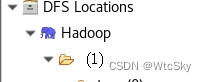

以及左侧项目栏会出一个DFS Locations

如果这里的Hadoop(刚才起的名字),点击可以显示文件夹,就说明连接成功反之会有一段错误代码。

9.4 ★解决eclipse连接Hadoop失败

确认每一台虚拟机都能上网,并且主机启动了start-all.sh。

不能上网请参考之前的内容。

9.5 ★解决没有Hadoop Map/Reduce选项

在9.2出现找不到这个选项的情况下,如果确定自己把hadoop-eclipse-plugin放进了文件中,并且没有解压这个文件,可以用低版本的hadoop-eclipse-plugin试一下,如hadoop-eclipse-plugin-2.xx,之类的。一般问题可以解决。

10. MapReduce模型

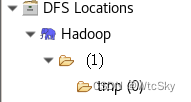

10.1 在Hadoop集群创建文件

直接在主机终端使用指令

hadoop fs -mkdir /tmp hadoop fs -chmod -R 777 /tmp 可以在eclipse中看到多出来的tmp目录。

如果找不到项目栏可以参考10.8解决。

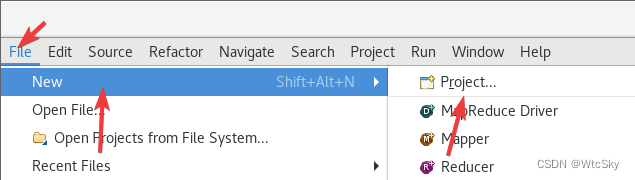

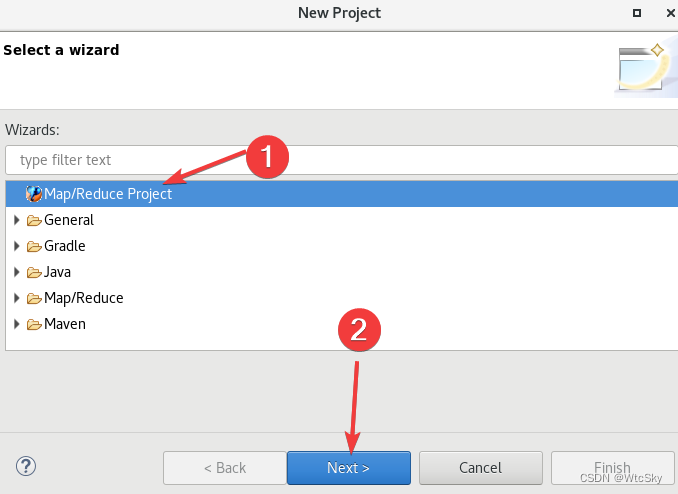

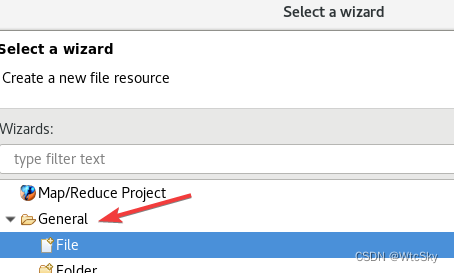

10.2 创建Map/Reduce项目

新建一个项目

然后选择Map/Reduce Project,点击Next。

随便起名比如WORDCOUNT。

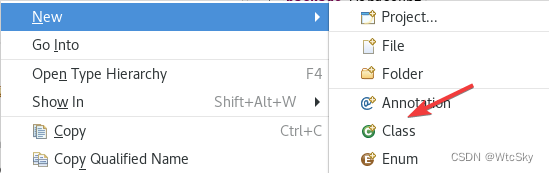

在src目录下直接创建一个Class类,类名是WordCount,弄个包也行无所谓。

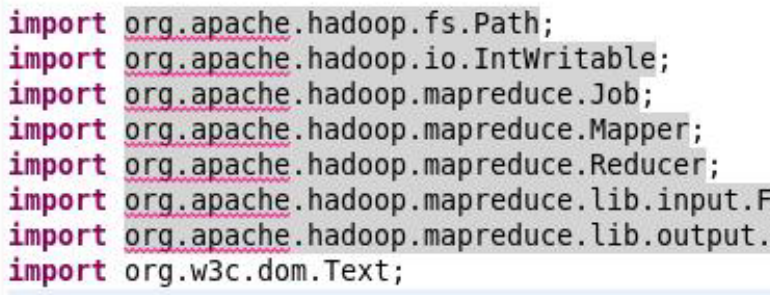

然后把代码复制进去:

package wordcount; import java.io.IOException; import java.util.StringTokenizer; import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.Path; import org.apache.hadoop.io.IntWritable; import org.apache.hadoop.io.Text; import org.apache.hadoop.mapreduce.Job; import org.apache.hadoop.mapreduce.Mapper; import org.apache.hadoop.mapreduce.Reducer; import org.apache.hadoop.mapreduce.lib.input.FileInputFormat; import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; public class WordCount { public static class WordCountMapper extends Mapper<Object, Text, Text, IntWritable> { private final static IntWritable one = new IntWritable(1); private Text word = new Text(); public void map(Object key, Text value, Context context) throws IOException, InterruptedException { StringTokenizer itr = new StringTokenizer(value.toString()); while (itr.hasMoreTokens()) {// word.set(itr.nextToken()); context.write(word, one); } } } public static class WordCountReducer extends Reducer<Text, IntWritable, Text, IntWritable> { private IntWritable result = new IntWritable(); public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException { int sum = 0; for (IntWritable val : values) { sum += val.get(); } result.set(sum); context.write(key, result); } } public static void main(String[] args) throws Exception { Configuration conf = new Configuration(); if (args.length != 2) { System.err.println("Usage: <in> <out>"); System.exit(2); } Job job = Job.getInstance(conf, "word count"); job.setJarByClass(WordCount.class); job.setMapperClass(WordCountMapper.class); job.setCombinerClass(WordCountReducer.class); job.setReducerClass(WordCountReducer.class); job.setOutputKeyClass(Text.class); job.setOutputValueClass(IntWritable.class); FileInputFormat.addInputPath(job, new Path(args[0])); FileOutputFormat.setOutputPath(job, new Path(args[1])); System.exit(job.waitForCompletion(true) ? 0 : 1); } } 如果连接成功了,那么上面的代码不会有错误,如果有错误一定是没有成功连接Hadoop。

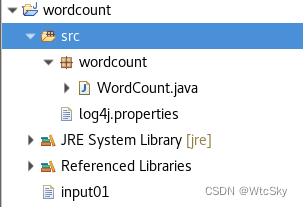

下面是此时的状态

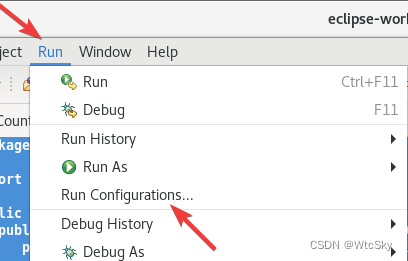

10.3 运行代码

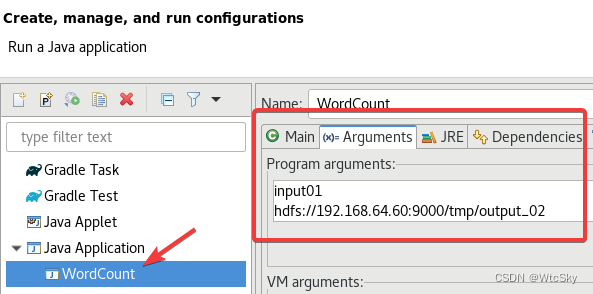

这是一个命令行输入的代码,因此我们的先设置参数。

菜单上选择Run->Run Configurations...。

然后选择程序,在Arguments中输入参数:

第一个是input01,同时在项目下创建一个input01.txt来存输入,与src同级!注意是同级不是在src里。

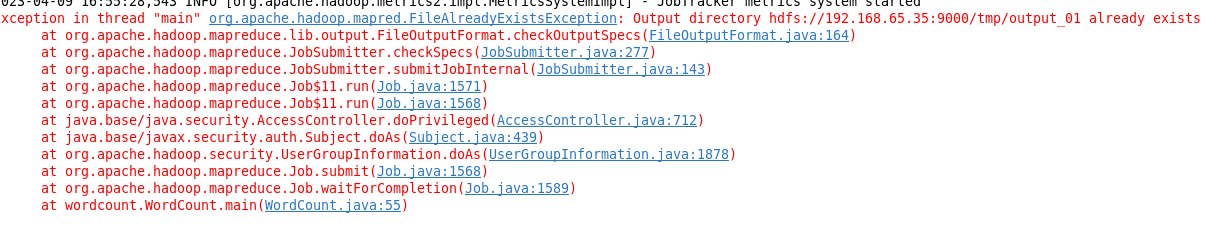

第二个是hdfs://192.168.64.60:9000/tmp/output_01,这个要按照自己的Master的ip来设置,输出在/tmp/output_02文件里,这个文件会自动生成,并且如果已经存在了,就不能成功运行。

10.4 ★解决不能运行(爆红的几种情况)

如果java代码爆红,先确定主机已经启动sbin目录下的start-all.sh了,并且可以在DFS Locations下找到tmp目录。此时如果org.apache.xxx一片红色,删了这个项目重新创建一个试一下。(还不行就把所有虚拟机重开,然后start-all然后再重新创建一个项目)

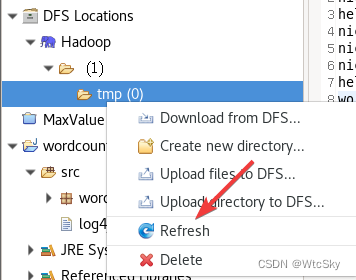

如果说output文件已经存在(already exists),在命令行中换一个名字,或者删掉之前的输出文件。如果在DFS Locations中的tmp下没有文件,就右键刷新(Refresh)一下。

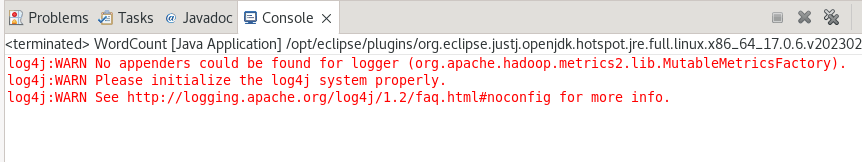

如果是不影响运行的警告:

可以右键src,选择New->Other->General->File。

文件名是:log4j.properties

文件内容是:

log4j.rootLogger=INFO, stdout log4j.appender.stdout=org.apache.log4j.ConsoleAppender log4j.appender.stdout.layout=org.apache.log4j.PatternLayout log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n log4j.appender.logfile=org.apache.log4j.FileAppender log4j.appender.logfile.File=target/spring.log log4j.appender.logfile.layout=org.apache.log4j.PatternLayout log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n 10.5 运行结果

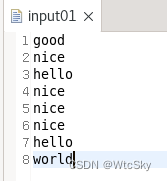

我们的程序是计算单词出现了几次。

在input01文件中写入输入的内容。

然后运行代码,右键刷新一下tmp目录

然后就会神奇的发现结果已经在目录里了。没有问题!

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!