阅读量:0

1. 导数 (Derivatives)

在梯度下降法中使用导数来更新模型参数。

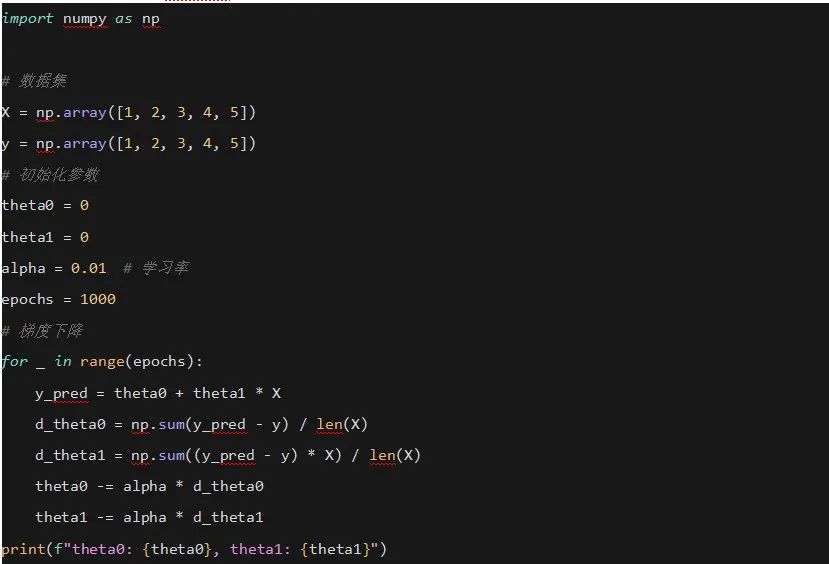

示例

使用Python和NumPy实现简单的线性回归梯度下降:

2. 偏导数 (Partial Derivatives)

在神经网络中使用偏导数来计算每个参数的梯度。

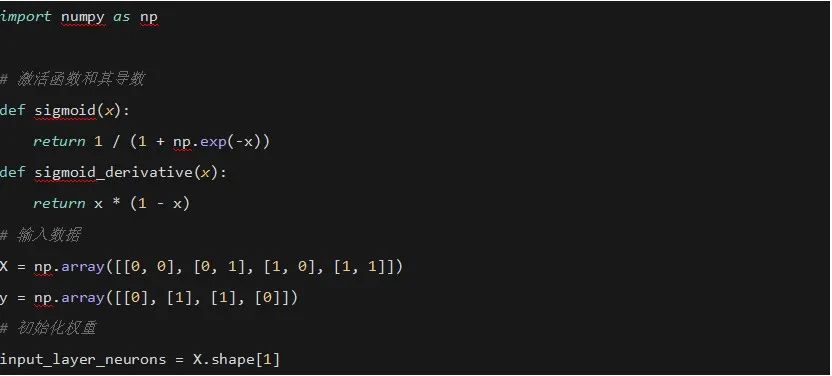

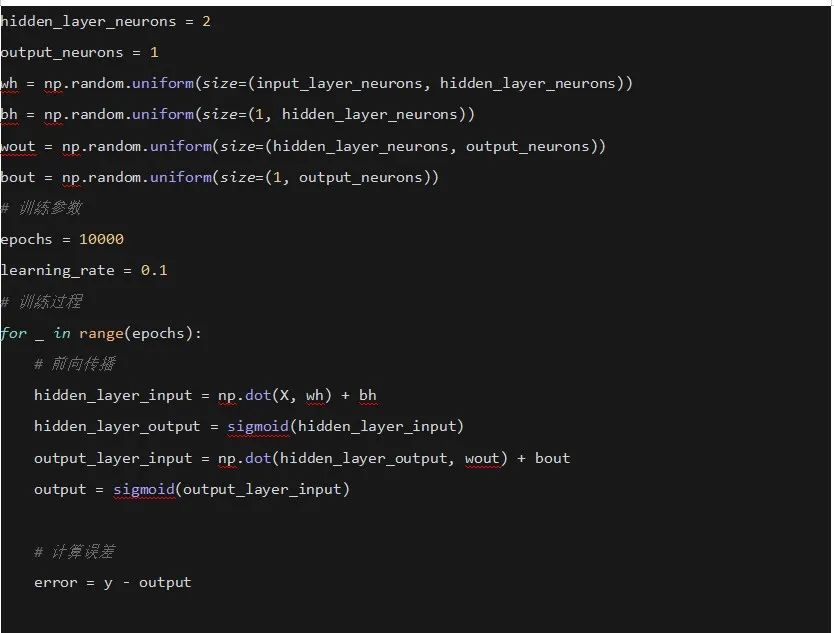

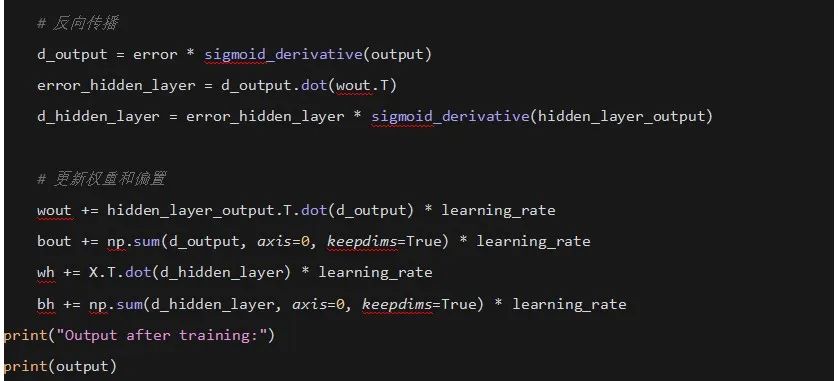

示例

使用Python和NumPy实现简单的神经网络反向传播:

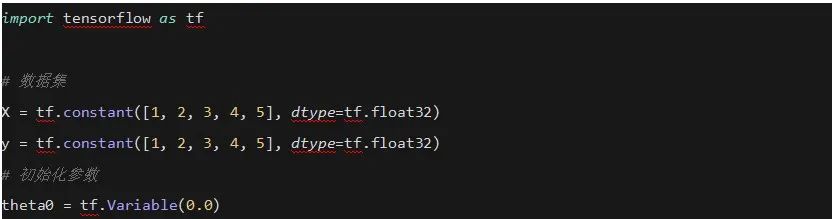

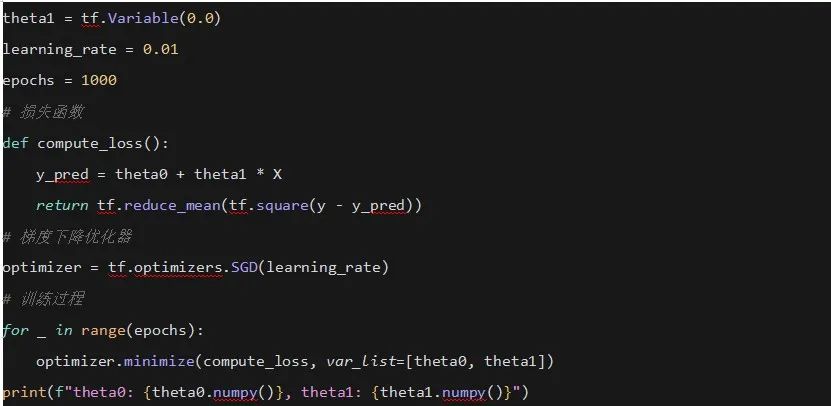

3. 梯度 (Gradient)

在梯度下降法中使用梯度来指示损失函数下降最快的方向。

示例

使用TensorFlow实现线性回归的梯度下降:

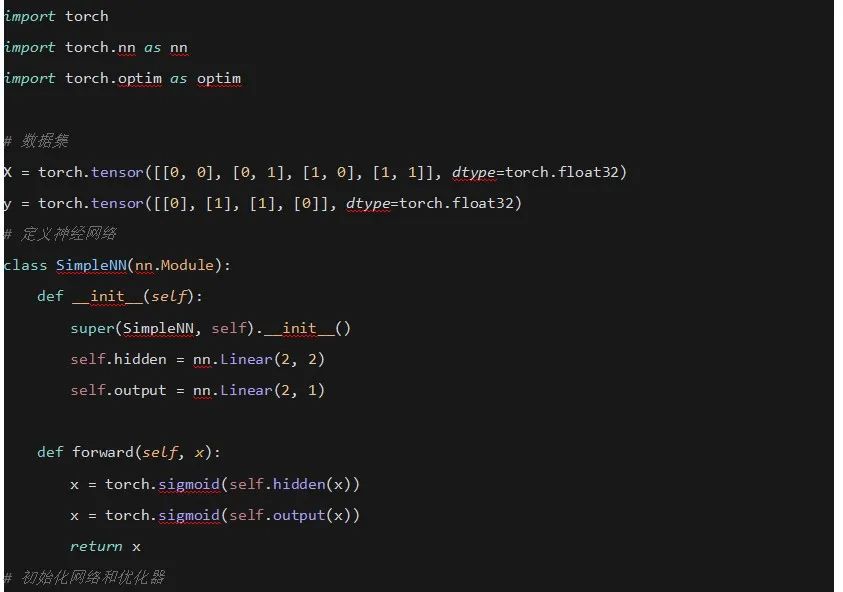

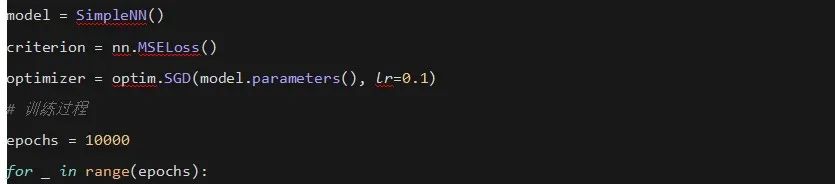

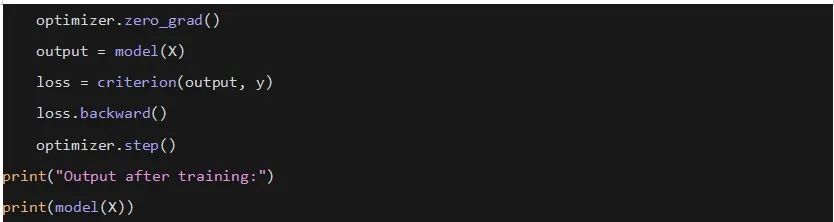

4. 链式法则 (Chain Rule)

在反向传播算法中使用链式法则来计算每一层的梯度。

示例

使用PyTorch实现简单的神经网络反向传播:

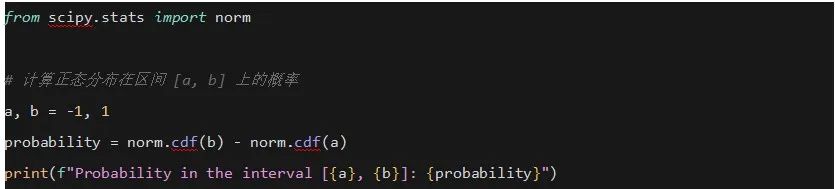

5. 积分 (Integrals)

在概率密度函数中使用积分来计算概率。

示例

使用SciPy计算正态分布的累积分布函数 (CDF):

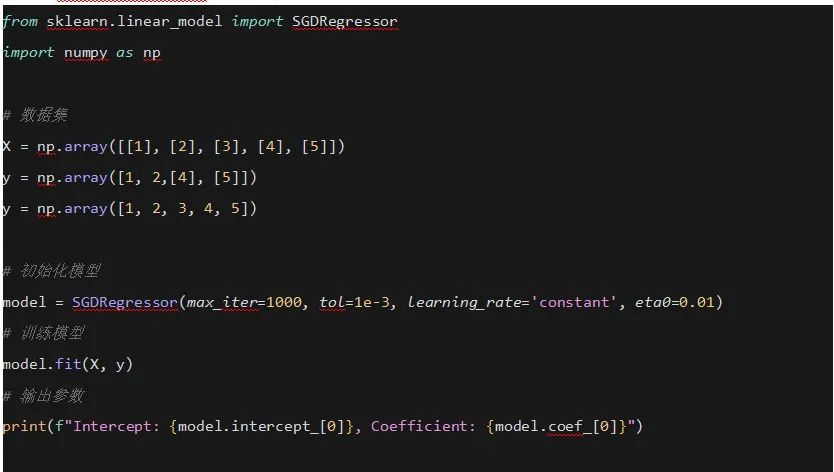

6. 梯度下降法 (Gradient Descent)

使用梯度下降法来最小化损失函数。

示例

使用Scikit-learn实现线性回归的梯度下降:

总结

这些代码示例展示了微积分概念在深度学习和机器学习中的实际应用,包括导数、偏导数、梯度、链式法则、积分和梯度下降法。通过这些示例,可以更好地理解微积分在优化和训练模型中的重要性。