经常是在一台电脑上安装所有的组件 比如安装ollama,安装Openwebui 安装ComfyUI

Openwebui安装在windows 情况下 最好是docker安装比较舒服一点,在Windows下安装docker 一般是用docker desktop 比较好用一点,其他的也可以,如podman,rancher但总感觉没有docker desktop好用,与其折腾还不如安装个docker desktop用,如果物理机的内存比较多,还想使用类似VMware workstation 去安装其他的操作系统,这个时候会出现VMware workstation 和docker 出现冲突的情况,退而求其次,还是安装VMware workstation吧。好了我们的基础架构是这样的

1 宿主机是安装Windows server 2022 安装chipset驱动 安装NVIDIA驱动 安装VMware workstation

安装Ollama 并下载流行的模型

2 在VMware workstation 中分配资源安装Windows server2019 操作系统并安装自己所需要的应用

设置资源创建另外一个虚拟机ubuntu20.4 并安装docker相关组件,直接pull openwebui

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=http://192.168.137.55:11434 -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

其中ip地址这段是宿主机ollama的信息,这样会自动去下载镜像并run起来,通过宿主机可以访问

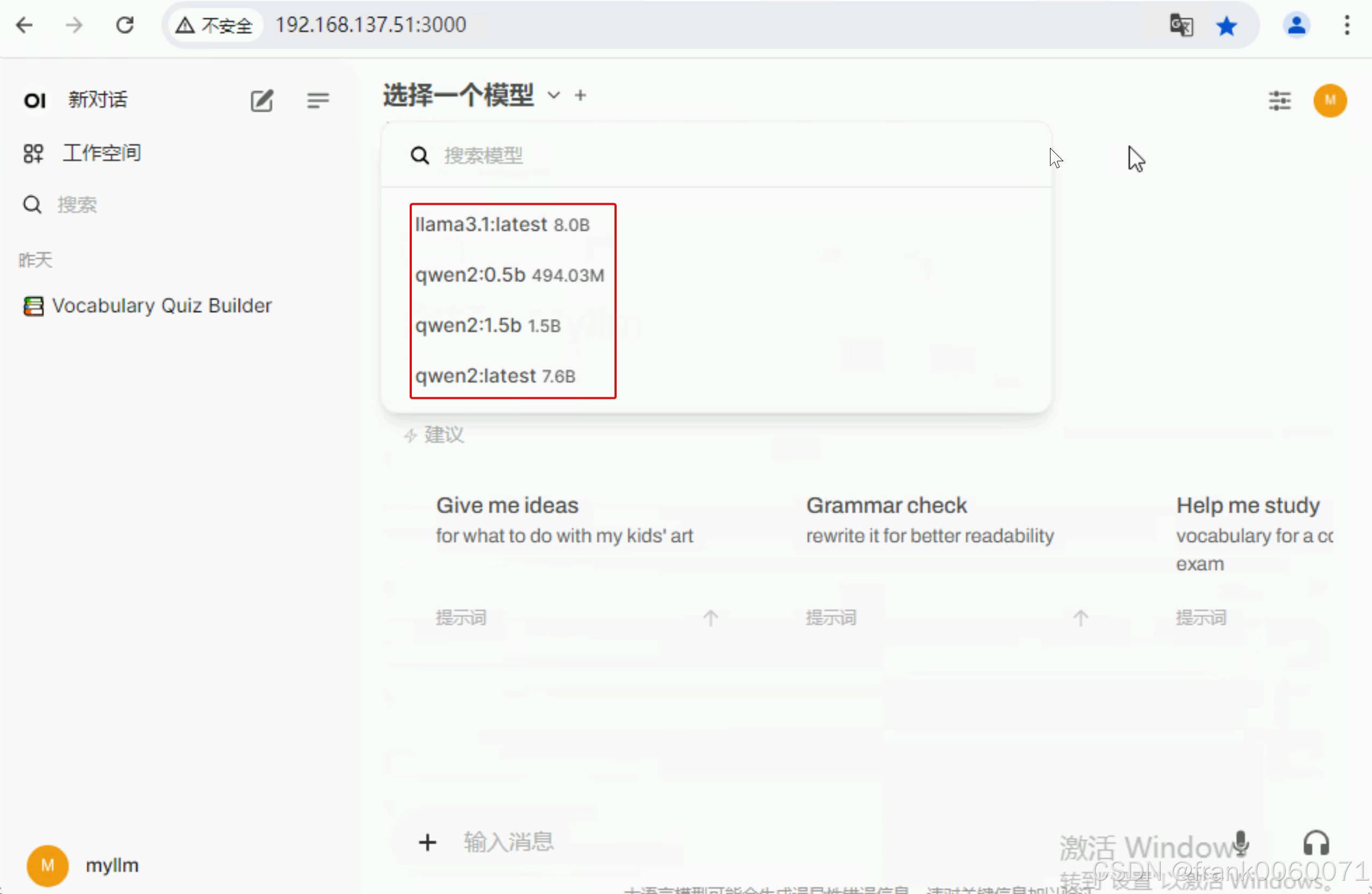

OpenwebUI 可以选择的模型

也可以在设置这里选择相应的模型

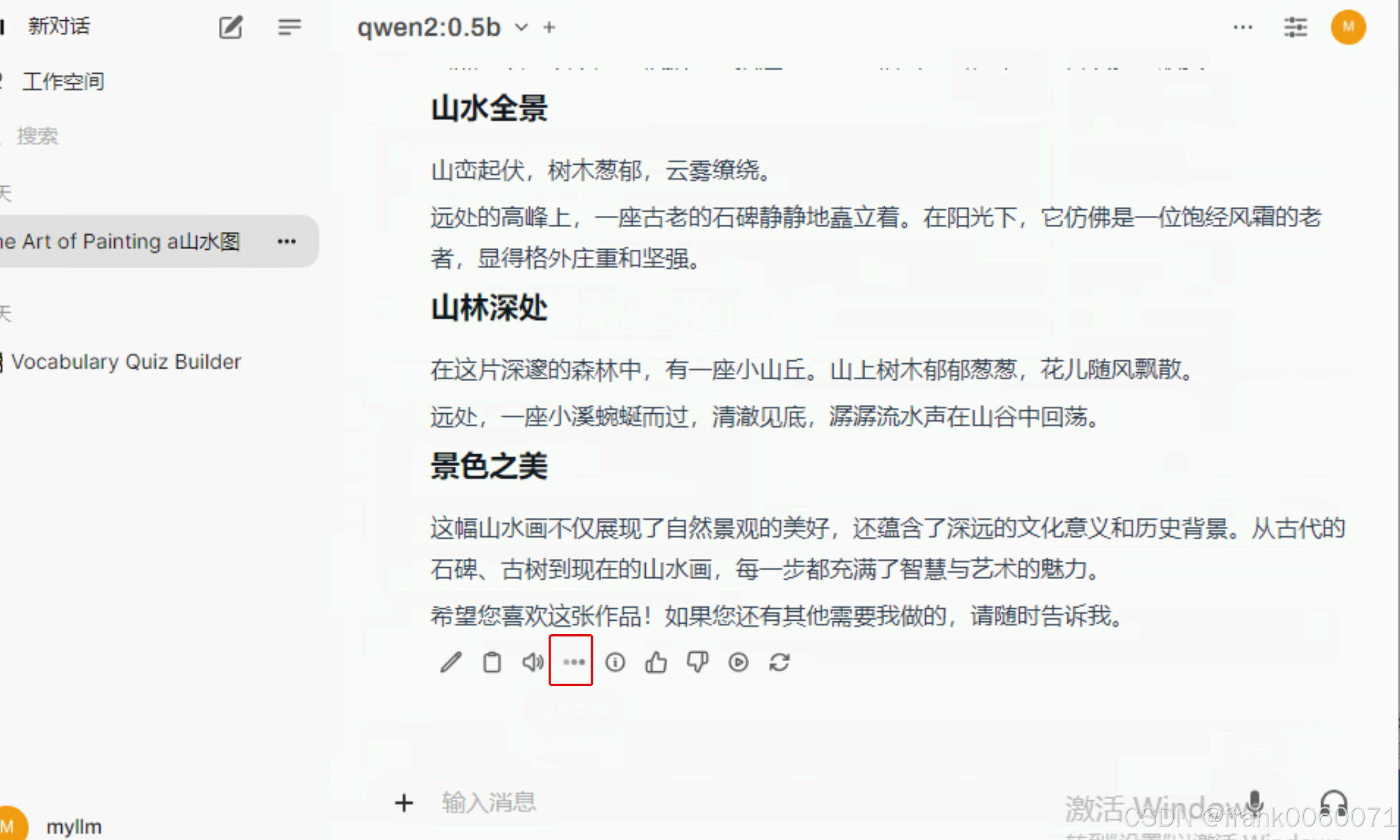

当然 可以也可以选择comfyui 但需要注意的是 结合模型和comfyui 最好是选择小一点的模型

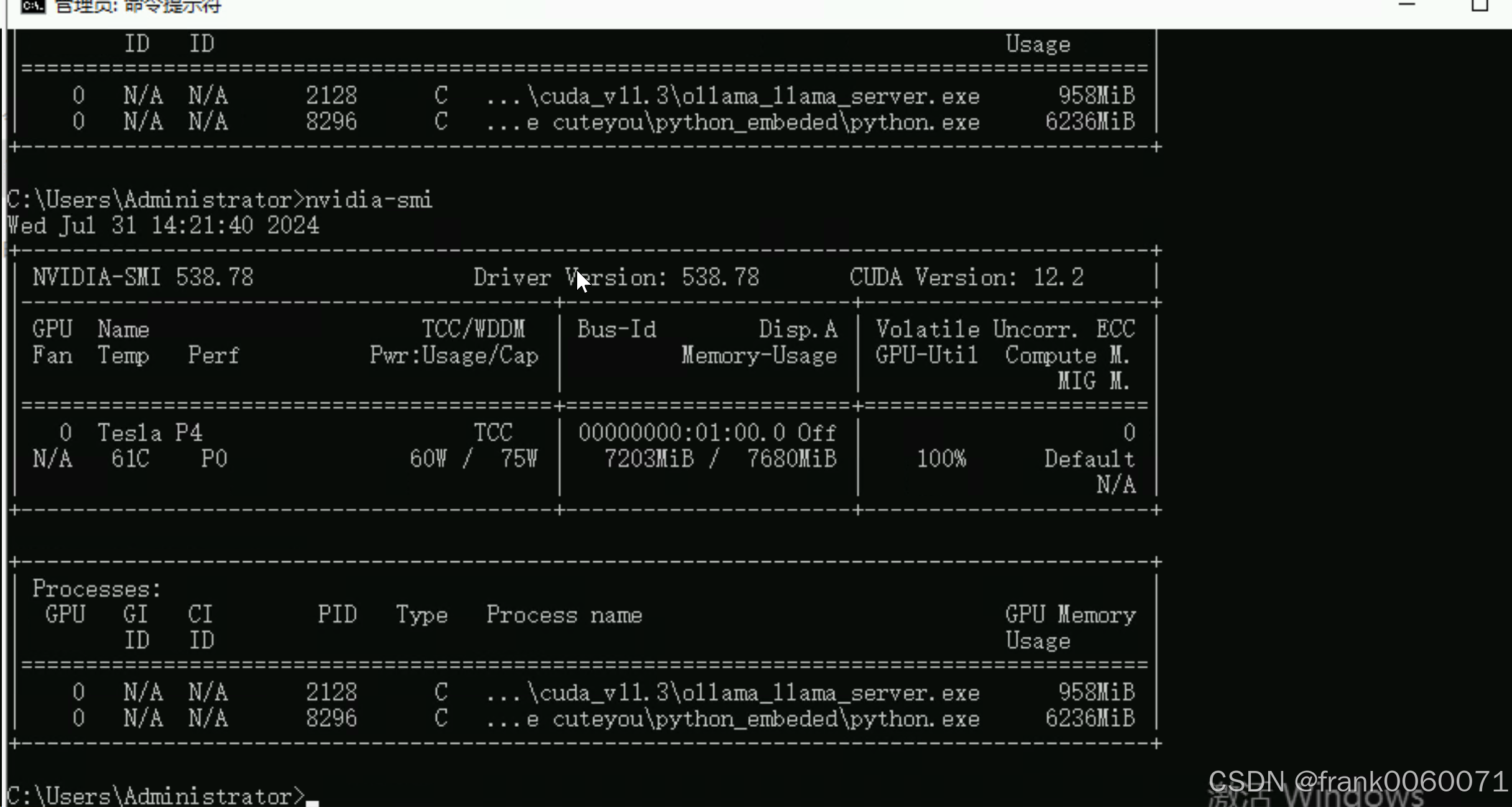

当显存不是足够大的情况下

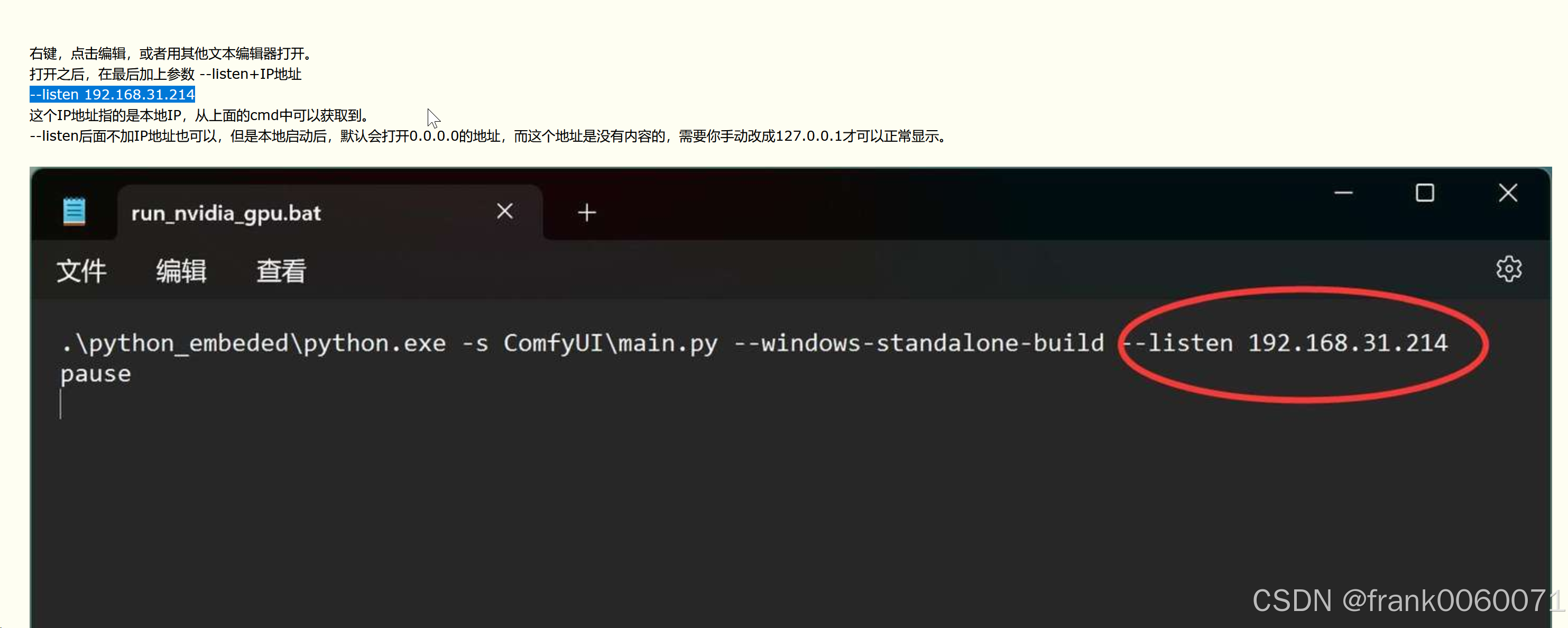

说到重点了 comyUI 这里需要在启动的时候加上一些信息 这样才能进行远程访问,才能将在虚拟机中docker运行的comfyUi 中设置连接

8GB显存几乎占满

画的图真是一般啊 有没可能是步数不够或者模型导致 更换继续测试

继续画一下看看 画的一般 坦白说

好的就到这里了