目录

一、数据管理安全

(一)数据溯源

数据溯源技术对大数据平台中的明细数据、汇总数据使用后中各项数据的产生来源、处理、传播和消亡进行历史追踪。 大数据平台数据溯源的原则:

(1)大数据平台须确保对个人数据操作的可追溯。

(2)要求跟踪并监控对大数据平台资源和持权限人数据的所有访问,记录机制和用户活动跟踪功能对防止、检测和最大程度降低数据威胁很重要。

数据超过存留期时要及时销毁数据,超过存留期个人数据的处理方法:

(1)必须提供删除/匿名化机制或指导来处理超过存留期的用户数据。

(2)提供程序机制,根据个人数据存留期设置删除周期,存留期一到便由程序自动删除。

(3)在产品客户资料中描述删除或是匿名个人数据的方法,指导客户使用。

(4)对于备份系统中超过存留期的个人数据,应在客户资料中告知客户进行定期删除。

(5)对于设备供应者,应根据客户需求,或按照业界惯例,提供机制或指导来删除或匿名超过存留期的用户数据。

(6)对于法律有特殊要求的用户隐私数据可遵照当地法律所要求的规范进行保存和处理。

(二)数字水印

数字水印技术指将特定的标识信息嵌入到宿主数据中(文本文件、图片、视频等),而且不影响宿主数据的可用性。数字水印分为可见水印和不可见水印两种 数字水印的设计原则:

(1)嵌入的水印信息应当难以篡改,难以伪造。

(2)嵌入的水印信息不能影响宿主数据(保护对象)的可用性,或者导致可用性大大降低。

(3)数字水印要求具有不可移除性,即被嵌入的水印信息不容易甚至不可能被黑客移除。

(4)数字水印要求具有一定的鲁棒性,当对嵌入后的数据进行特定操作后,所嵌入的水印信息不能因为特定操作而磨灭。

大数据平台采用数字水印提供对数据的版权保护,也可用于对信息非法泄露者进行追责。一方面,在大数据平台中,通过接口将一些原创的、有价值的宿主数据的所有者信息作为水印信息嵌入到宿主数据中,用于保护宿主数据的版权,以期达到避免或阻止宿主载体未经授权的复制和使用。另一方面,大数据平台在分发数据时,通过接口将数据接收者的信息嵌入到所分发的数据中,以期对信息非法泄露行为进行取证。当接收者将分发数据泄露给非授权第三人时,可以通过提取水印信息对接收者的泄露行为进行追责。

大数据平台通常以文件的形式分发数据,主要有pdf文件、Excel文件和网页文件形式。文件的不可见水印技术根据嵌入方法,可以分为如下几种:

(1)基于文档结构微调的水印技术;

(2)基于文本内容的水印技术;

(3)基于自然语言的水印技术;

(4)基于数值型数据LSB的水印技术;

(5)基于数据集合统计特征的水印技术。

当大数据平台通过网页浏览、打印或导出文件的形式分发文件时,不可见水印技术无法对拍照、截屏和打印等行为进行取证和追责。因此,需要在所分发的文件中嵌入可见水印信息,以期达到对用户通过拍照、截屏和打印等非法泄露信息的行为进行取证和追责。文件的可见水印设计需要满足数字水印的设计原则,如难以伪造、不可移除、鲁棒性,以及不影响宿主文件可用性等。

(三)策略管理

策略管理为隐私处理模块和隐私还原管理模块提供处理策略配置和版本管理,处理过程中所用到密钥的版本管理和存储管理都由其统一管理,保存到特定的安全位置,一般只由去隐私处理模块和还原处理模块调用。

大数据平台中的安全策略管理主要涵盖三个部分, 一是对安全密钥、口令保护进行统一定义与设置;二是对安全规则进行集中管理、集中修订和集中更新,从而实现统一的安全策略实施; 三是安全管理员可以在中央控制端进行全系统的监控。

大数据平台中安全策略管理的特性具体要求如下:

(1)大数据平台应具备对安全规则进行集中管理的功能,并且支持对安全规则的远程配置和修订;

(2)对密钥和口令相关的帐户支持集中化管理,包括帐户的创建、删除、修改、角色划分、权限授予等工作;

(3)对违反安全规则的行为提供告警消息,能够对整个大数据平台中出现的任何涉及安全的事件信息及时通报给指定管理员,并保存相关记录,供日后查询;

(4)提供单次登录服务,允许用户只需要一个用户名和口令就可以访问系统中所有被许可的访问资源;

(5)提供必要的手段能够对外网访问策略进行管理,加强外网接口服务器的访问策略管理工作。

(四)完整性保护

大数据平台的数据完整性要求在数据传输和存储过程中,确保数据不被未授权的用户篡改或在篡改后能够被迅速发现。大数据平台的完整性保护,主要包含数据库关系完整性保护和数据完整性保护。 数据库关系完整性是为保证数据库中数据的正确性和相容性,对关系模型提出的某种约束条件或规则,以期达到防止数据库中存在不符合语义规定的数据和防止因错误信息的输入输出造成无效操作或错误信息。关系完整性通常包括域完整性,实体完整性、引用完整性和用户定义完整性,其中域完整性、实体完整性和引用完整性,是关系模型必须满足的完整性约束条件。

大数据平台要尽可能的利用数据库系统所提供的完整性保护机制来保护数据库中数据的完整性。然而,数据库完整性保护只能防止不满足规则约束的数据篡改,无法防范在满足规则约束以内的数据篡改。

针对数据库字段中满足规则约束内的数据完整性保护,大数据平台需要满足如下安全特性:

(1)要求采用业界标准的哈希认证码算法MAC计算保护对象的哈希认证码。例如HMAC-SHA256标准算法。

(2)相同的字段值每次生成的认证码应该不尽相同。

(3)攻击者不能通过采用表中的一条记录覆盖另一条记录的方式来实施数据篡改。

(五)数据脱敏

数据脱敏用于保护大数据平台中的敏感数据,主要涉及加解密算法的安全、加密密钥的安全、存储安全、传输安全以及数据脱敏后密文数据的搜索安全等。

1、密码算法的安全

用于大数据平台敏感数据的加解密算法应该选择业界标准算法,严禁使用私有的、非标准的加解密算法用于加密和保护敏感数据。其原因是,如果不是具有密码学专业素养的专家设计的密码算法,这些算法难以达到密码学领域的专业性要求;此外,其技术上也未经业界分析验证,有可能存在未知的缺陷;另一方面其违背了加密算法要公开透明的原则。加解密算法在大数据安全平台的特性描述如下。

(1)在大数据平台中的安全策略中定义和设置管理加解密算法。

(2)在离线采集与实时采集中,要求对入库的数据进行统一敏感字段脱敏处理。

(3)对不需要还原的敏感数据采用不可逆加密算法加密,例如,用于身份认证的口令使用PBKDF2做单向不可逆加密存储。

(4)脱敏后的安全强度必须能够应对目前计算能力的破解,目前80比特的强度已经能够被目前

的计算能力破解,而112比特的安全强度则可用到2030年。

(5)对需要还原使用的敏感数据采用可逆加密算法加密,禁止使用不安全的加密算法加密敏感数据。

2、密钥的安全

密钥的安全管理对于整个大数据平台的安全性至关重要。如果使用不恰当的密钥管理方式,强密码算法也无法保证大数据平台的安全。一个密钥在其生命周期中会经历多种不同的状态,包含密钥生成、分发、使用、存储、更新、备份和销毁。密钥在其生命周期的各个阶段,都应满足一些基本的安全要求,以保障自身的安全性。大数据平台中加密密钥的主要安全特性描述如下:

(1)密钥分层管理至少选择两层结构进行管理;

(2)用于产生密钥的随机数发生器必须是安全随机数发生器;

(3)在非信任网络中传输密钥时需提供机密性、完整性保护;

(4)密钥的用途必须单一化,一个密钥只用于一种用途;

(5)密钥不可以硬编码在代码中,需要对密钥提供加密和完整性保护机制;

(6)在一般情况下,密钥必须支持可更新,并明确更新周期;

(7)不再使用的密钥应当立即删除或销毁。

用于加密保护工作密钥的根密钥可采用基于密钥组件的根密钥管理方法进行管理,以确保根密钥的安全性。

在大数据平台中,如果采用统一变更密钥的方法更新数据,首先需要将所有旧密文数据载入内存,然后采用旧密钥对旧密文数据进行解密,最后用新密钥统一对解密后的明文数据重新进行加密。然而,在大数据场景下,由于存储和处理的数据量往往比较庞大,解密和重新加密旧数据会消耗大量的计算时间和内存空间,特别是重新存储新密文时需要耗费大量的1/O操作。另外,该方法在重新加密旧数据时,由于需要先解密旧密文,所以内存中会出现用户的明文号码。一旦内存被攻击者控制,内存中的明文号码也将被攻击者窃取。

另一种密钥更新方法是按周期定期变更加密密钥,同时保持以往周期的旧密文数据和旧密钥不爱该方法考虑到旧密文数据一旦被攻击者窃取,对旧密文数据采用新密钥重新加密的意义不大。四为如果攻击者可以通过密文分析方法获得敏感信息,那么,攻击者拥有所窃取的旧密文数据就足了,此时对已经被窃取的旧密文数据重新加密并不能阻止信息的泄露。为了在降低系统的性能消彩的同时保护新数据,该方法在密钥变更时只需要变更最新周期的密钥即可,无需解密和重新加密日数据。另外,由于该方法在不同周期采用了不同的加密密钥,还可以防止敏感数据的大面积泄露。但是,不同周期的相同明文经加密之后的密文会不一样,这不利于识别跨周期相同的明文目标。为了识别跨周期相同的明文目标,需要对跨周期的密文数据做额外的归一化处理以便将相同的明文归化到相同的密文形态。

3、存储安全

在不同存储或打印场景,对敏感数据(例如,口令、银行账号、身份证号、通信内容、加密算法、金额、IV值或密钥信息等)进行限制或保护处理,避免因为敏感数据泄露而导致大数据平台不安全或用户隐私受到威胁。大数据平台下敏感数据存储安全的特性描述如下:

(1)禁止在任何日志中打印明文的口令、银行账号、身份证号和通信内容;

(2)禁止在告警中包含明文的敏感数据;

(3)禁止在日志和告警信息中包含密文的敏感数据;

(4)禁止在cookie 中以明文的形式存放敏感数据;

(5)禁止在隐藏域中以明文的形式存放敏感数据;

(6)禁止在Web页面缓存中以明文形式存放敏感数据;

(7)采用HTTP-POST方法提交敏感数据;

(8)在BS 应用中,禁止URL存放会话标识。

4、传输安全

对非信任网络之间传输中的敏感数据进行安全保护,防止敏感数据在传输过程中被嗅探或窃取。大数据平台中敏感数据安全传输的主要特性描述如下:

(1)非信任网络间的敏感数据必须采用加密通道传输;

(2)登录过程中的口令和账号需要采用加密通道传输;

(3)禁止使用不安全的传输协议传输敏感数据;

(4)使用安全的传输协议传输敏感数据。

5、密文搜索安全

数据脱敏后的密文数据是以乱码的形式存在的,其失去了可搜索的特性。为了实现对密文的搜索,一般情况下需要先将所有密文数据载入到内存,然后对内存中的密文数据进行解密,最后再采用基于明文的拽索技术对解密后的密文进行搜索。以上提到的方法虽然可以间接地实现对密文的搜素,但是该方法需要花费额外的解密时间和内存空间。特别是在大数据平台中,由于其所存储的数据证通常比较庞大,间接搜索密文的方法将花费更多的解密时间和内存空间。因此,在大数据平台中实现直接对宓文进行快速搜索的方法变得非常重要。基于关键词索引的密文搜索技术是目前流行的一种方法,它可以在不解密的情况下直接对密文进行搜索。

大数据平台密文数据搜索安全的特性描述如下:

(1)采用业界标准的安全密码算法加密目标敏感数据,如AES-CBC 加密算法;

(2)采用业界标准的安全密码算法生成关键词的安全索引,如HMAC-SHA256;

(3)在搜索过程中不需要解密敏感数据,内存中不出现敏感明文;

(4)直接在数据库中通过SQL脚本析取出目标密文,避免内存中出现大量密文数据;

(5)提供支持密文模糊搜索的功能,满足业务需求。

二、安全分析

(一)大数据安全分析架构

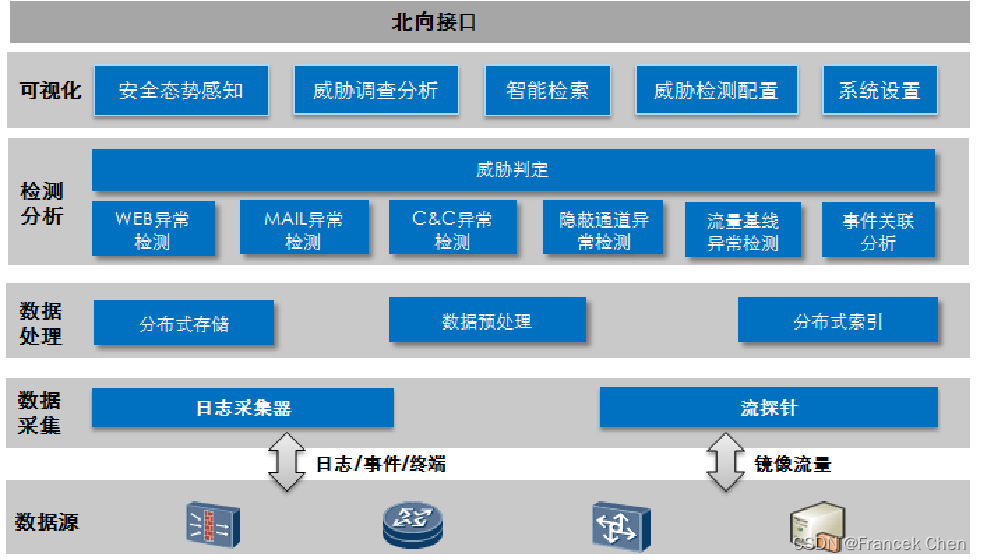

1、数据采集

数据采集包括日志采集和原始流量采集,日志采集器负责日志采集,流探针负责原始流采集。日志采集流程包括日志接收、日志分类、日志归一化和日志转发;流量采集流程包括流量采集、协议解析、文件还原和流量元数据上报。

2、数据预处理

数据预处理负责对采集器上报的归一化日志和流探针上报的流量元数据进行格式化处理,补充相关的上下文信息(包括用户、地理位置和区域),并将格式化后的数据发布到分布式总线。

3、分布式存储

分布式存储负责对格式化后的数据进行存储,针对不同类型的异构数据(归一化日志、流量元数据和PCAP文件)进行分类存储,分布式存储的数据主要用于威肋检测和威胁可视化。考虑到可靠性和高并发性的要求,一般将分布式存储的数据保存在多个检测存储节点,并且可以按需扩展存储节点。

4、分布式索引

分布式索引负责对关键的格式化数据建立索引,为可视化调查分析提供基于关键字的快速检索服务。分布式索引采用了多实例自适应的索引技术和时间片抽取的分层索引结构,索引数据保存在多个检测/存储节点,提供了高可靠性和高并发索引能力,支持按需弹性扩展索引。

5、事件关联分析

关联分析主要通过挖掘事件之间的关联和时序关系,从而发现有效的攻击。关联分析采用了高性能的流计算引擎,关联分析引擎直接从分布式消息总线上获取归一化日志装入内存,并根据系统加载的关联规则进行在线分析。

系统预置了一部分关联分析规则,用户也可以自定义关联分析规则。当多条日志匹配了某一关联规则,则认为它们之间存在对应的关联关系,输出异常事件,同时将匹配用到的原始日志记录到异常事件中。

6、流量基线异常检测

流量基线异常检测主要解决网络内部的主机区域之间(内外区域之间、内网区域与互联网之间、内网主机之间、内网主机与互联网之间、内网主机与区域之间)的异常访问问题。流量基线是指网络内部主机之间、区域之间或者内外网之间的访问规则,包括指定时间段内是否允许访问、访问的频次范围,以及流量大小范围等。

流量基线可以有两种来源:系统自学习和用户自定义配置。流量基线自学习,就是系统自动统计一段时间内(如一个月)网络内部各主机、区域以及内外网之间的访问和流量信息,以此访问和流量信息为基础(对于流量数据,还会自动设置合适的上下浮动范围),自动生成流量基线。用户自定义流量基线:用户手工配置网络内部各主机、区域以及内外网之间的访问和流量规则。

流量基线异常检测将自学习和用户自定义的流量基线加载到内存中,并对流量数据进行在线统计和分析,一旦网络行为与流量基线存在偏差,即输出异常事件。

7、Web异常检测

Web异常检测主要用于检测通过Web 进行的渗透和异常通信,从历史数据中提取HTTP流量元数据,通过分析HTTP协议中的URL、User-Agent、Refer和上传/下载的文件MD5等信息,并结合沙箱文件检测结果,离线挖掘和检测下载恶意文件、访问不常见网站和非刘览器流量等异常。

8、邮件异常检测

邮件异常检测主要从历史数据中提取邮件流量元数据,通过分析SMTP/POP3/IMAP协议中的收件人、发件人、邮件服务器、邮件正文和邮件附件等信息,并结合沙箱文件检测结果,离线挖掘和检测收发件人异常、下载恶意邮件、访问邮件服务器和邮件正文URL异常等。

9、C&C异常检测

C&C异常检测主要通过对DNS/HTTP协议流量的分析检测C&C通信异常。对于基于DNS流量的C&C异常检测采用机器学习方法,利用样本数据进行训练,从而生成分类器模型,并在客户环境利用分类器模型识别访问DGA域名的异常通信,从而发现僵尸主机或者APT攻击在命令控制阶段的异常行为。对基于HTTP流量的C&C异常检测则采用统计分析的方法,记录内网主机访问同一个目的IP+域名的所有流量中每一次连接的时间点,并根据时间点计算每一次连接的时间间隔,定时检查每一次的时间间隔是否有变化,从而发现内网主机周期外联的异常行为。

10、隐蔽通道异常检测

隐蔽通道异常检测主要用于发现被入侵主机通过正常的协议和通道传输非授权数据的异常,检测方法包括Ping Tunnel、HTTP Tunnel、DNS Tunnel和文件防躲避检测。

(1)Ping Tunnel检测是通过对一个时间窗内同组源/目的IP之间的ICMP报文的载荷内容进行分析和比较,从而发现Ping Tunnel异常通信。

(2)HTTP Tunnel 检测是通过对一个时间窗内同组源/目的IP之间的HTTP报文协议字段进行分析和比较,从而发现HTTP Tunnel异常通信。

(3)DNS Tunnel检测通过对一个时间窗内同组源/目的IP之间的DNS报文的域名合法性检测和DNS请求/应答频率进行分析,从而发现DNS Tunnel异常通信。

(4)文件防躲避检测通过对流量元数据中的文件类型进行分析和比较,从而发现文件类型与实际扩展名不一致的异常。

11、威胁判定

威胁判定根据多个异常进行关联、评估和判定产生高级威胁,为威胁监控和攻击链路可视化提供数据。威胁判定按照攻击链的阶段标识/分类各种异常,并以异常发生的时间为准,通过主机IP、文件MD5和URL建立异常的时序和关联关系,根据预定义的行为判定模式判定是否高级威胁,同时根据相关联的异常的严重程度、影响范围、可信度进行打分和评估,从而产生威胁事件。

(二)大数据防DDoS攻击

DDoS攻击DDoS全称分布式拒绝服务。攻击者以瘫痪网络服务为直接目的,以耗尽网络设施(服务器,防火墙,IPS,路由器接口)性能为手段,利用网络中分布的傀儡主机向目标设施发送恶意攻击流量。

1、DDoS攻击概述

(1)攻击目的

从直接动机上来看,攻击者使用 DDoS 攻击的主要目标有三种:

a. 耗尽服务器性能(包括内存,CPU,缓存等资源),导致服务中断

b. 阻塞网络带宽,导致大量丢包,影响正常业务

c. 攻击防火墙,IPS设备等网络设施,占用其会话和处理性能,使正常转发受阻

(2)攻击手段

a. 传输层攻击;

b. 应用层攻击;

c. 攻击辅助行为

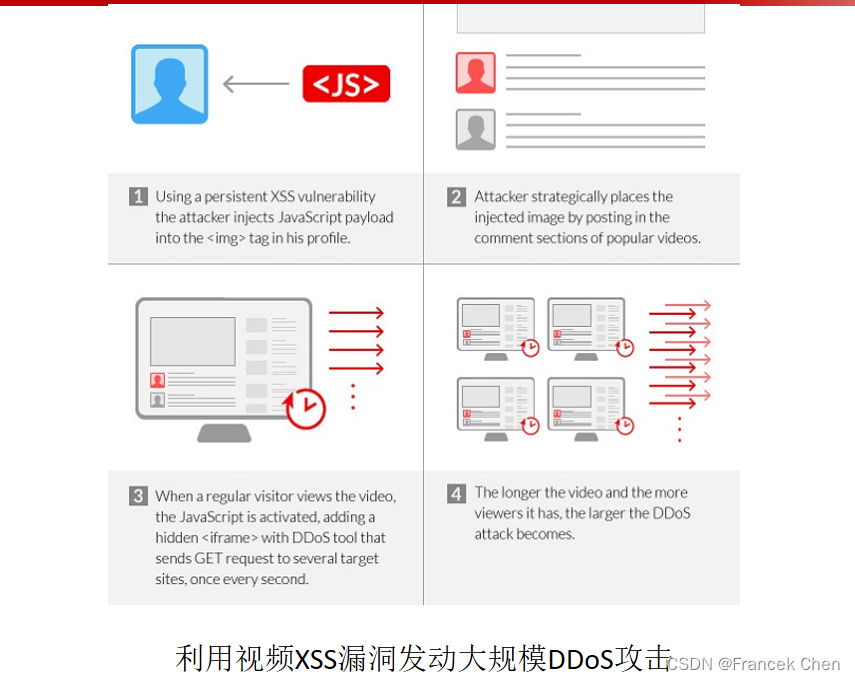

2、利用大数据平台实现DDoS攻击检测

(1)利用XSS漏洞在头像中注入JavaScript负载;

(2)对在热门视频进行评论,并在评论中也包含恶意代码;

(3)户观看视频时,会触发JavaScript,并以每秒一次的频率对指定目标发送GET请求;

(4)观看的用户量越大,攻击规模就越大。

特点:攻击成本很小;易于隐藏,无需部署。

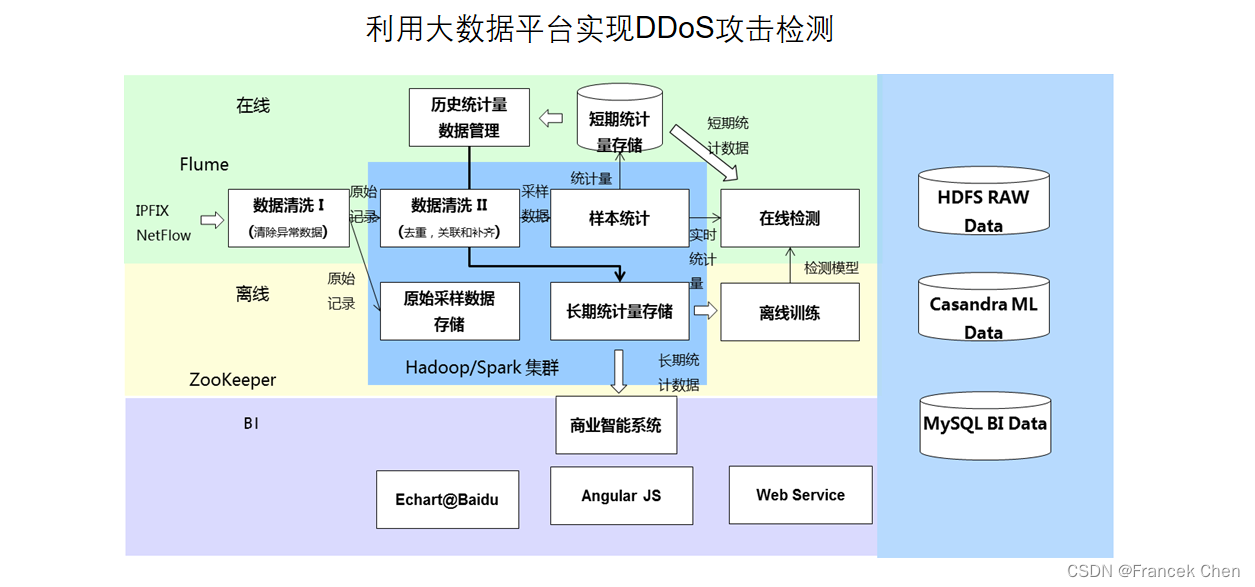

华为大数据平台采用业界主流的 Hadoop\Spark 技术,系统集群进行海量数据的并行处理,随着数据处理的规模的扩大,只需增加服务器,就可以实现处理能力的线性扩容。

攻击检测大数据平台支持的功能如下。

(1)现网数据样本清洗和管理;

(2)样本数据的信息关联和扩展;

(3)样本流数据统计;

(4)流统计时序数据的存储和检索;

(5)实际流量估计;

(6)在线异常流检测基于机器学习的异常流检测模型训练。

3、利用机器学习实现智能的DDoS攻击识别与检测

机器学习输入的Feature数据,是用IPFIX/NetStream信息会进行聚合后生成,并可以根据多Feature生成新的Feature,每个分析对象的总Feature数可以达到数万。 聚合维度如下:

(1)源网段聚合统计

(2)源地区聚合统计

(3)目的地区聚合统计

(4)目的网站(云、数据中心)聚合统计

(5)源网站(云、数据中心)聚合统计

(6)网站(云、数据中心)同源网段聚合统计

(7)网站(云、数据中心)同源地区聚合统计

(8)自治域至自治域聚合统计

(9)地域间聚合统计

(10)云、数据中心到网站聚合统计

(11)网站所属IP同源网段聚合统计

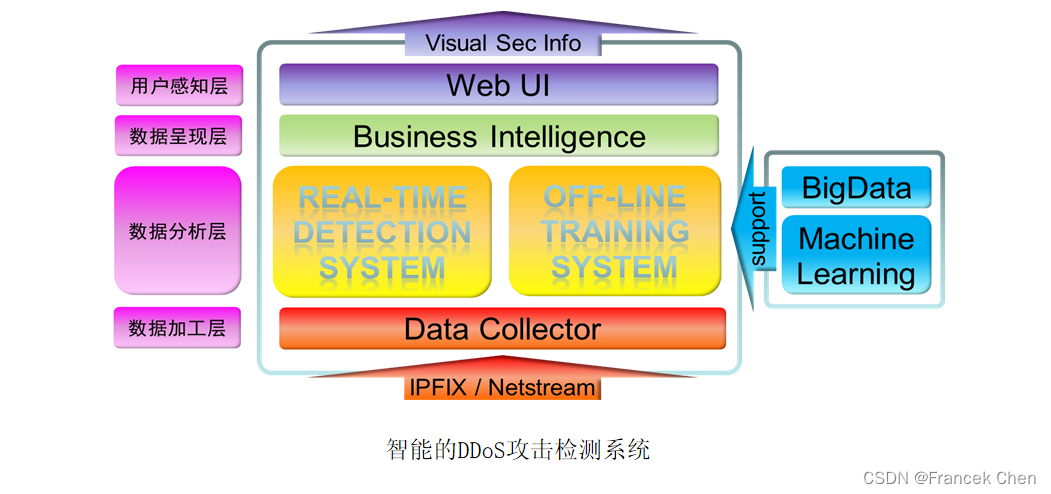

(三)攻击可视化与安全业务定制

华为攻击检测大数据平台采用分层解耦的架构,智能系统接收来自在线检测系统与离线训练系统两部分的统计结果,根据业务需求完成相关数据的筛选、合并、排序等操作,保存数据全集,Web UI界面可以根据用户定制,进行数据呈现。 系统具备的能力包括监控、检测和展示:

(1)安全监控功能:站点监控和疑似对象监控;

(2)检测功能:攻击检测和攻击溯源,被监控对象安全状况评估;

(3)攻击状况展示:攻击地理分布展示、TOP-N 攻击统计展示、攻击流量展示和运营商间攻击流量展示;

(4)流量历史回溯:区域间流量历史回溯、站点访问历史状态回溯和区域出流量历史状态回溯;

(5)流量展示:站点访站点访问流量展示、运营商间流量展示和特定区域出流量展示。

三、隐私保护

(一)隐私保护面临的挑战

大数据技术面临的隐私问题与挑战:

(1)消费者知情权;

(2)个人数据的控制能力;

(3)数据转移给第三方进行二次使用问题;

(4)匹配政府的法律法规及各行业标准的要求并快速响应大数据的商业诉求。

(二)内容关联密钥

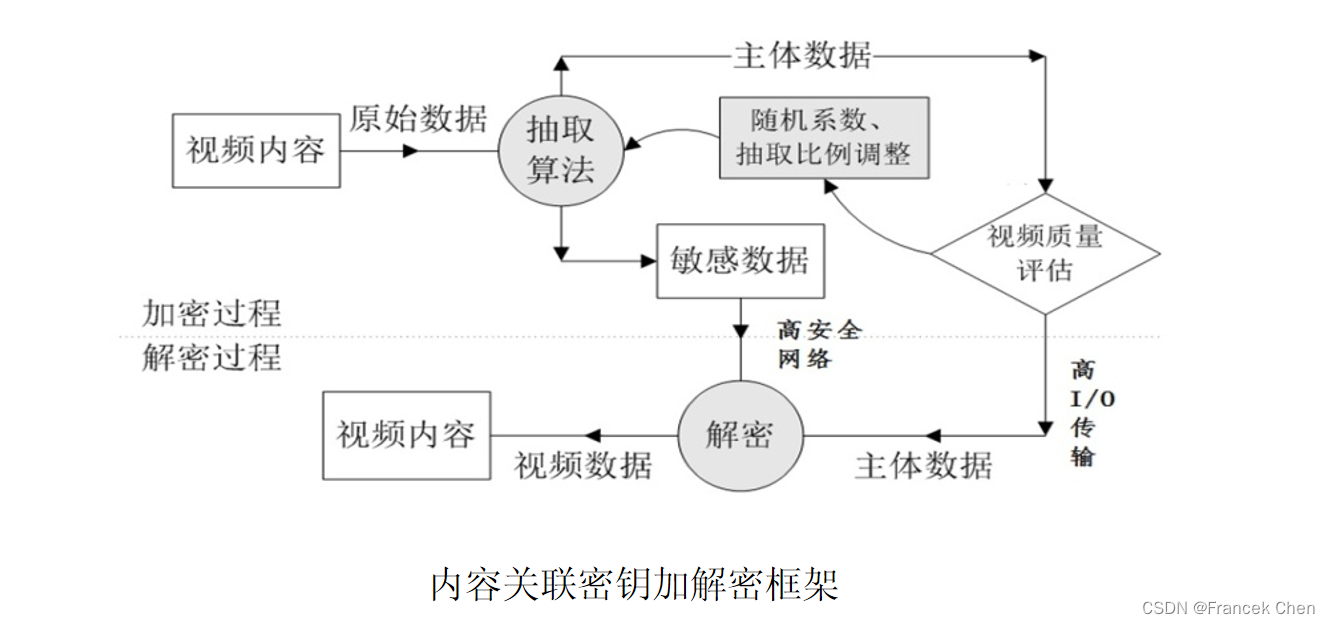

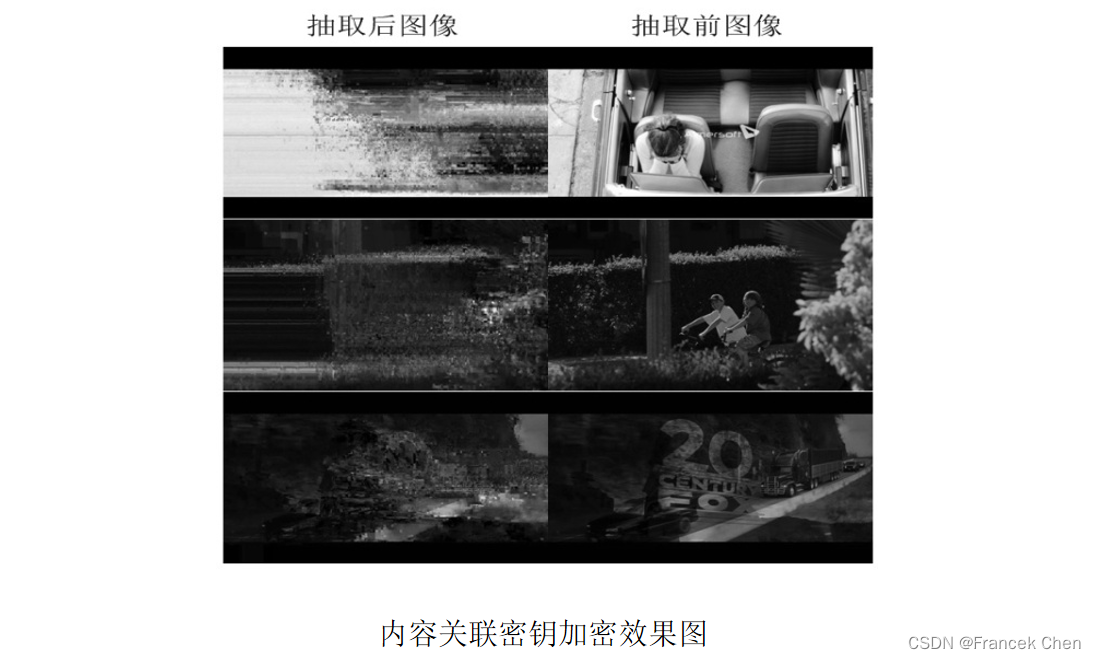

1、内容关联密钥技术

区别于常见加密算法密钥多由随机数或其他与待加密明文本质上毫无关联的数据经过一定的算法所产生,内容关联密钥技术的密钥本身即为待加密明文的一部分。 该加密算法按照原始待加密明文中数据的重要性(针对文件应用的重要性),将数据中数据量小但重要性或信息含量较高的那一部分数据抽取出来,作为原始待加密明文的密钥;而将待加密明文中剩余的那些数据量较大但重要性较低的部分,经过一定处理(如数据填充以保证文件的完整性)后作为算法的密文。

2、内容关联密钥技术的特点

(1)这种新机理的密钥的数据量不是由计算复杂度决定的,而是由其对数据文件应用的重要性决定的。在可控性价比下(终端资源和加密性能),可以采用很长的密钥(数十KB 或 数十MB),所以抗暴力破解能力很强。

(2)由于文件数据的离散性,不同数据文件的密钥没有任何关联性。

(3)在隐私保护方面,这种新的安全机理不会增加大数据存储系统负载。

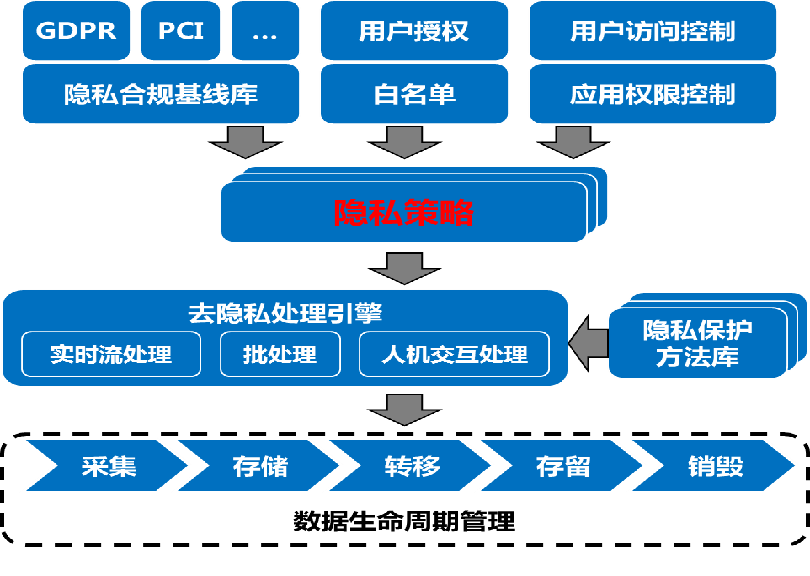

(三)华为大数据隐私保护方案

华为大数据隐私保护方案采用合适的技术措施(例如授权、加密、访问控制、匿名化、假名化及隐私策略管理),使得个人数据和用户隐私能够得到充分保护。

(1)用户授权管理

(2)隐私策略管理

(3)隐私风险管理

完毕!