目录

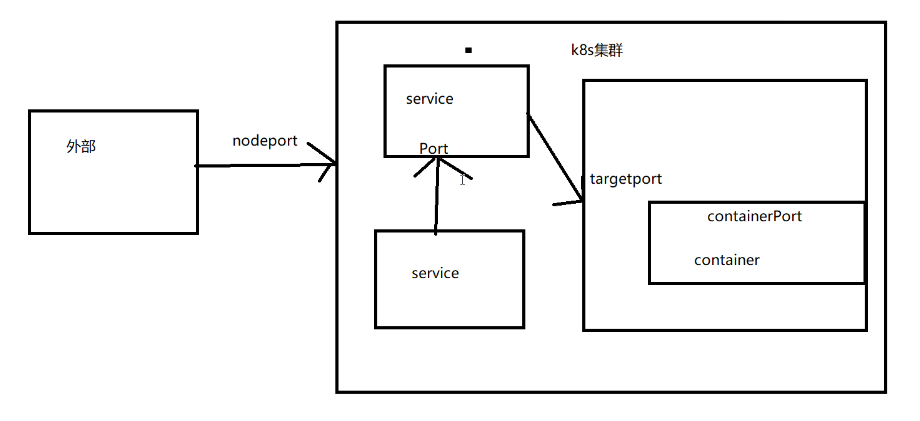

K8S集群外部:客户端——nodeIP:nodeport——通过target port——podIP:containerport编辑2.语法格式

一.Yaml文件详解

1.Yaml文件格式

(1)Kubernetes 支持 YAML 和 JSON 格式管理资源对象

(2)JSON 格式:主要用于 api 接口之间消息的传递

(3)YAML 格式:用于配置和管理,YAML 是一种简洁的非标记性语言,内容格式人性化,较易读

2.YAML 语法格式

(1)大小写敏感

(2)使用缩进表示层级关系

(3)不支持Tab键制表符缩进,只使用空格缩进

(4)缩进的空格数目不重要,只要相同层级的元素左侧对齐即可,通常开头缩进两个空格

(5)符号字符后缩进一个空格,如冒号,逗号,短横杆(-)等

(6)“—”表示YAML格式,一个文件的开始,用于分隔文件间

(7)“#”表示注释

二.Yaml文件编写及相关概念

1.查看 api 资源版本标签

[root@master01 ~]# kubectl api-versions admissionregistration.k8s.io/v1 admissionregistration.k8s.io/v1beta1 apiextensions.k8s.io/v1 apiextensions.k8s.io/v1beta1 apiregistration.k8s.io/v1 apiregistration.k8s.io/v1beta1 apps/v1 #如果是业务场景一般首选使用 apps/v1 authentication.k8s.io/v1 authentication.k8s.io/v1beta1 #带有beta字样的代表的是测试版本,不用在生产环境中 authorization.k8s.io/v1 authorization.k8s.io/v1beta1 autoscaling/v1 autoscaling/v2beta1 autoscaling/v2beta2 batch/v1 batch/v1beta1 certificates.k8s.io/v1 certificates.k8s.io/v1beta1 coordination.k8s.io/v1 coordination.k8s.io/v1beta1 discovery.k8s.io/v1beta1 events.k8s.io/v1 events.k8s.io/v1beta1 extensions/v1beta1 flowcontrol.apiserver.k8s.io/v1beta1 networking.k8s.io/v1 networking.k8s.io/v1beta1 node.k8s.io/v1 node.k8s.io/v1beta1 policy/v1beta1 rbac.authorization.k8s.io/v1 rbac.authorization.k8s.io/v1beta1 scheduling.k8s.io/v1 scheduling.k8s.io/v1beta1 storage.k8s.io/v1 storage.k8s.io/v1beta1 v1 2.yaml编写案例

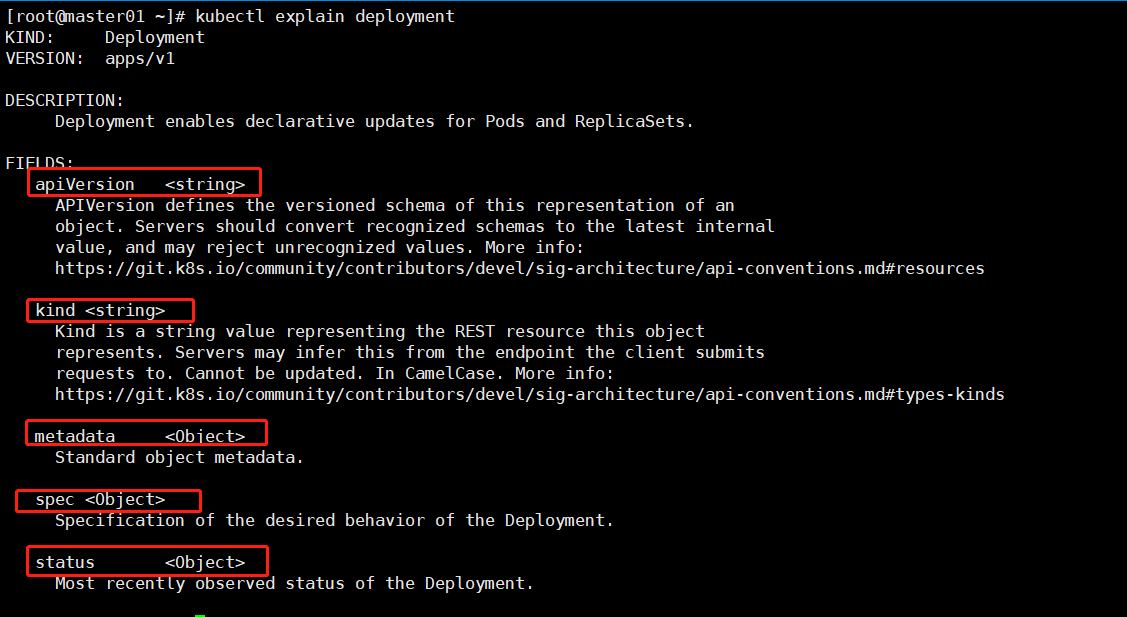

#查看deployment的版本定义 kubectl explain deployment

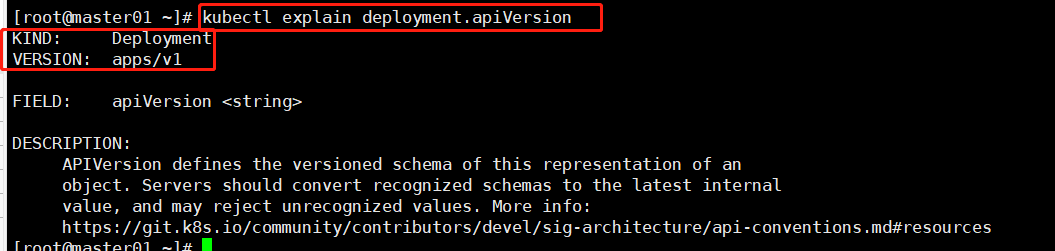

#查看api的版本 kubectl explain deployment.apiVersion

#查看元数据信息 kubectl explain deployment.apiVersion #定义标签介绍 kubectl explain deployment.spec.selector #对matchLabels标签介绍 kubectl explain deployment.spec.selector.matchLabels (2)Deployment类型编写nginx服务

- 创建pod

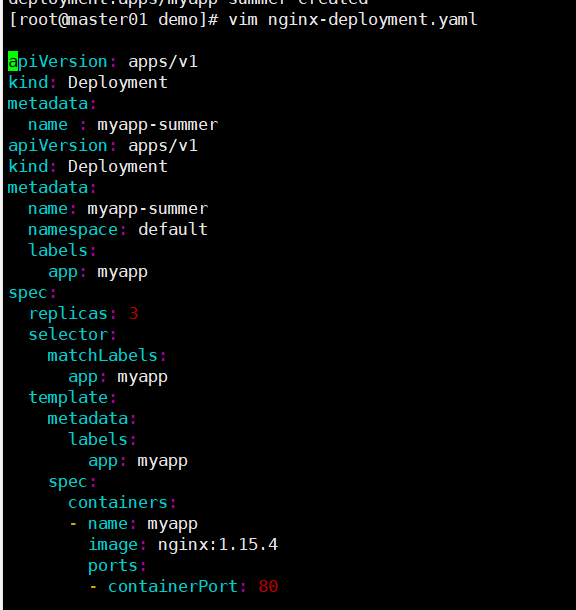

#写一个yaml文件demo mkdir /opt/demo cd demo/

vim nginx-deployment.yaml apiVersion: apps/v1 #指定api版本标签 kind: Deployment #定义资源的类型/角色,deployment为副本控制器,此处资源类型可以是Deployment、Job、Ingress、Service等 metadata: #定义资源的元数据信息,比如资源的名称、namespace、标签等信息 name: nginx-deployment #定义资源的名称,在同一个namespace空间中必须是唯一的 namespace: default #默认就是default,可以不用写 labels: #定义Deployment资源标签 app: nginx spec: #定义deployment资源需要的参数属性,诸如是否在容器失败时重新启动容器的属性 replicas: 3 #定义副本数量 selector: #定义标签选择器 matchLabels: #定义匹配标签 app: nginx #需与 .spec.template.metadata.labels 定义的标签保持一致 template: #定义业务模板,如果有多个副本,所有副本的属性会按照模板的相关配置进行匹配 metadata: labels: #定义Pod副本将使用的标签,需与 .spec.selector.matchLabels 定义的标签保持一致 app: nginx spec: containers: #定义容器属性 - name: nginx #定义一个容器名,一个 - name: 定义一个容器 image: nginx:1.15.4 #定义容器使用的镜像以及版本 ports: - containerPort: 80 #定义容器的对外的端口

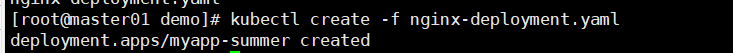

#创建资源对象 kubectl create -f nginx-deployment.yaml 或 kubectl apply -f nginx-deployment.yaml #查看创建的资源对象,创建需等待running kubectl get pod

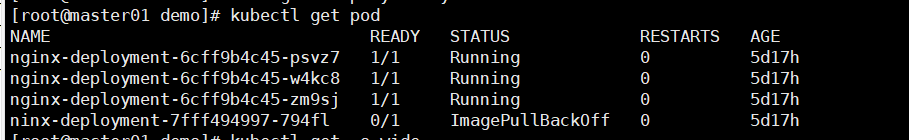

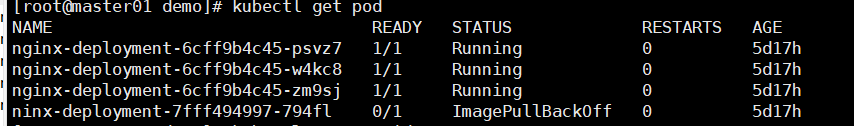

[root@master01 demo]# kubectl get pod NAME READY STATUS RESTARTS AGE nginx-deployment-6cff9b4c45-psvz7 1/1 Running 0 5d17h nginx-deployment-6cff9b4c45-w4kc8 1/1 Running 0 5d17h nginx-deployment-6cff9b4c45-zm9sj 1/1 Running 0 5d17h ninx-deployment-7fff494997-794fl 0/1 ImagePullBackOff 0 5d17h

- 容器如果想对外提供访问,需创建service 发布

#创建service服务对外提供访问并测试 vim nginx-service.yaml apiVersion: v1 kind: Service metadata: name: nginx-service labels: app: nginx spec: type: NodePort ports: - port: 80 targetPort: 80 selector: app: nginx

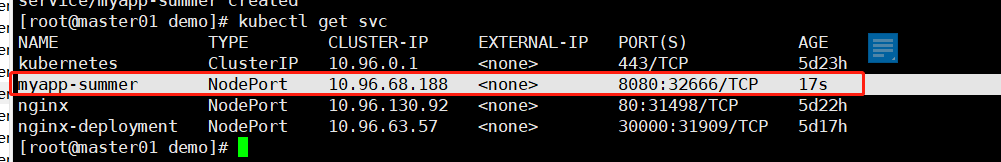

#创建资源对象 kubectl create -f nginx-service.yaml 或 kubectl apply -f nginx-service.yaml #查看创建的service [root@master01 demo]# kubectl get svc NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 5d19h myapp-summer NodePort 10.96.30.130 <none> 8080:32666/TCP 119s

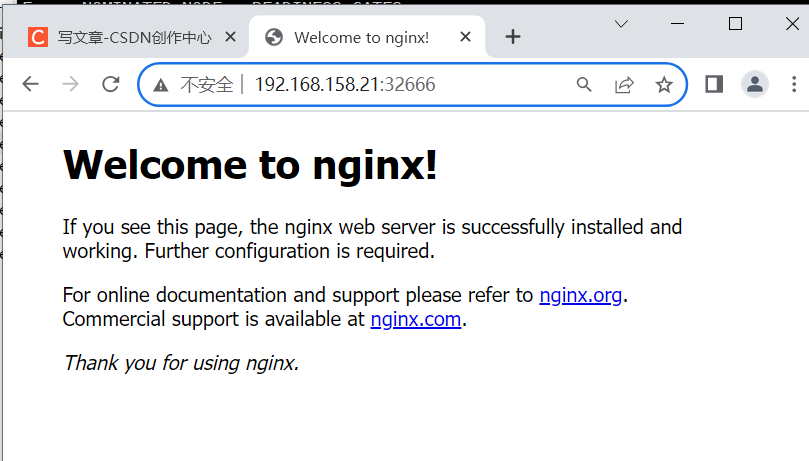

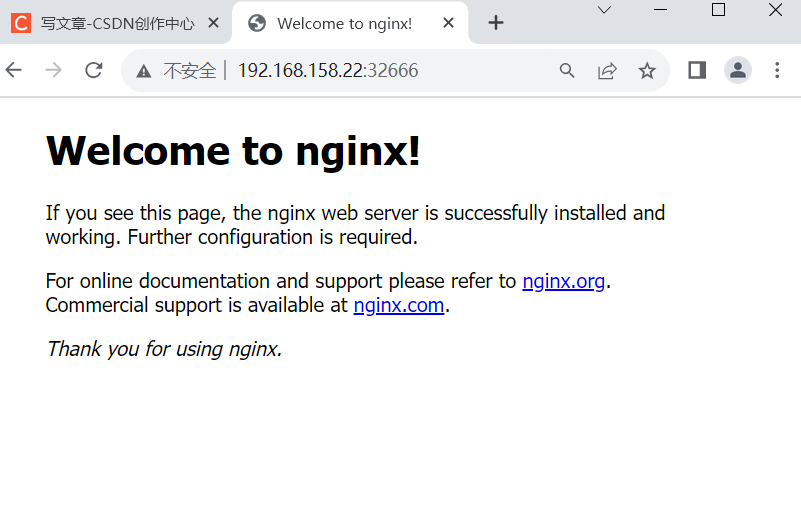

#在浏览器输入 nodeIP:nodePort 即可访问 http://192.168.158.21:32666 http://192.168.158.22:32666

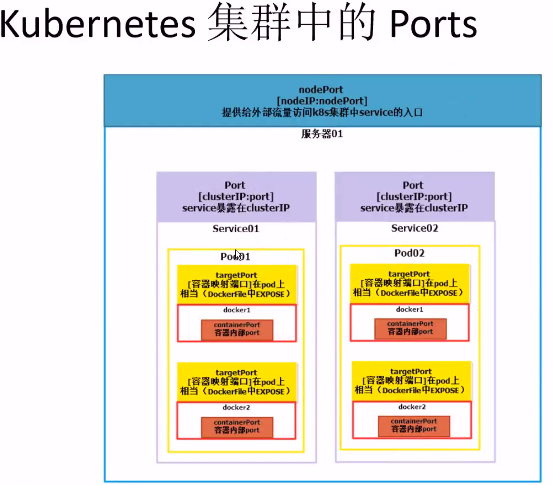

(3)k8s集群中的port介绍

详解k8s中的port:

●port

port 是 k8s 集群内部访问service的端口,即通过 clusterIP: port 可以从 Pod 所在的 Node 上访问到 service

●nodePort

nodePort 是外部访问 k8s 集群中 service 的端口,通过 nodeIP: nodePort 可以从外部访问到某个 service。

●targetPort

targetPort 是 Pod 的端口,从 port 或 nodePort 来的流量经过 kube-proxy 反向代理负载均衡转发到后端 Pod 的 targetPort 上,最后进入容器。

●containerPort

containerPort 是 Pod 内部容器的端口,targetPort 映射到 containerPort。

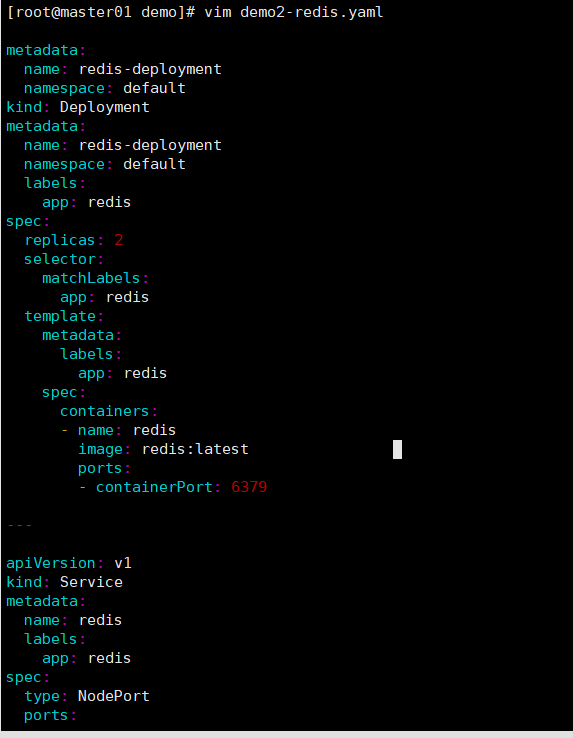

vim demo02-redis.yaml apiVersion: apps/v1 kind: Deployment metadata: name: redis-deployment namespace: default labels: app: redis spec: replicas: 2 selector: matchLabels: app: redis template: metadata: labels: app: redis spec: containers: - name: redis image: redis:latest ports: - containerPort: 6379 --- apiVersion: v1 kind: Service metadata: name: redis labels: app: redis spec: type: NodePort ports: - port: 6379 targetPort: 6379 nodePort: 32555 selector: app: redis

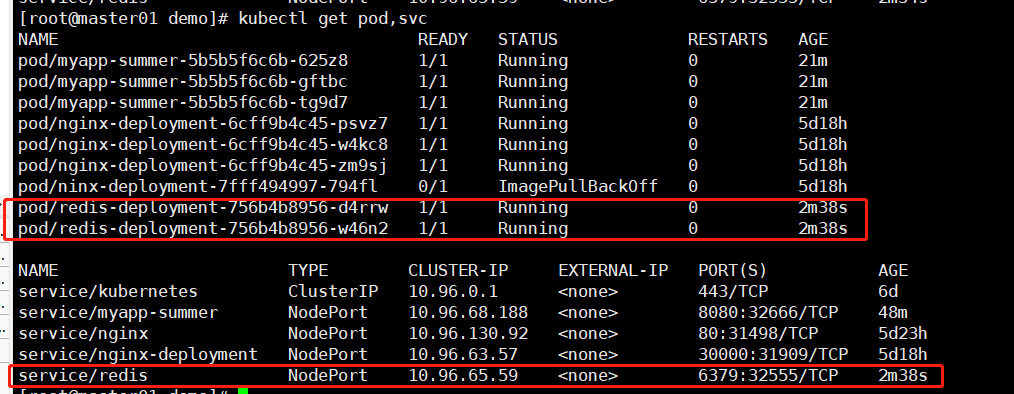

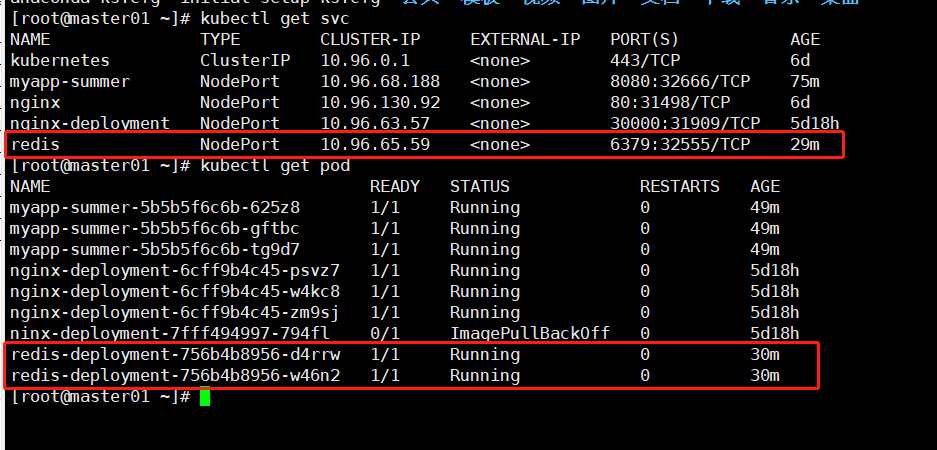

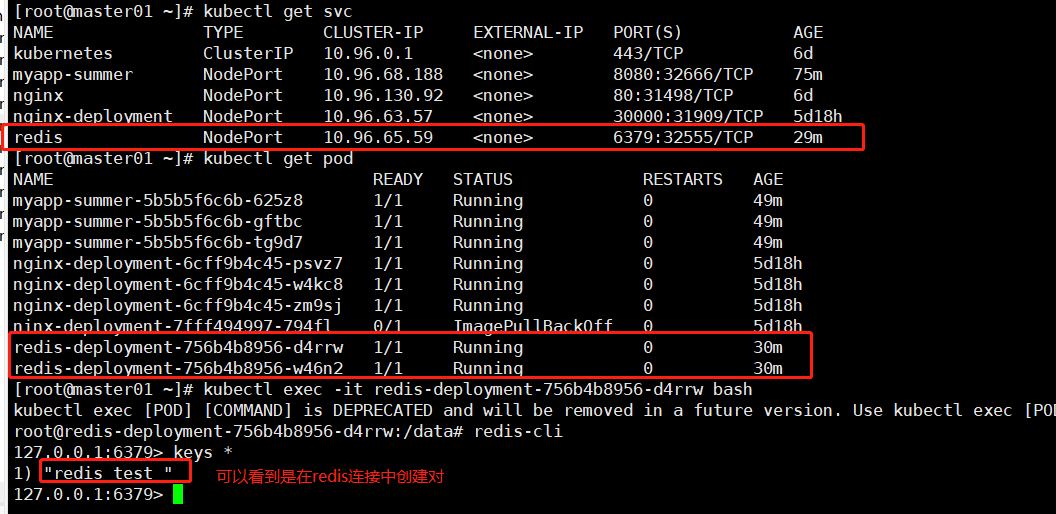

#创建资源 kubectl apply -f demo02-redis.yaml #查看创建的资源 kubectl get pod,svc

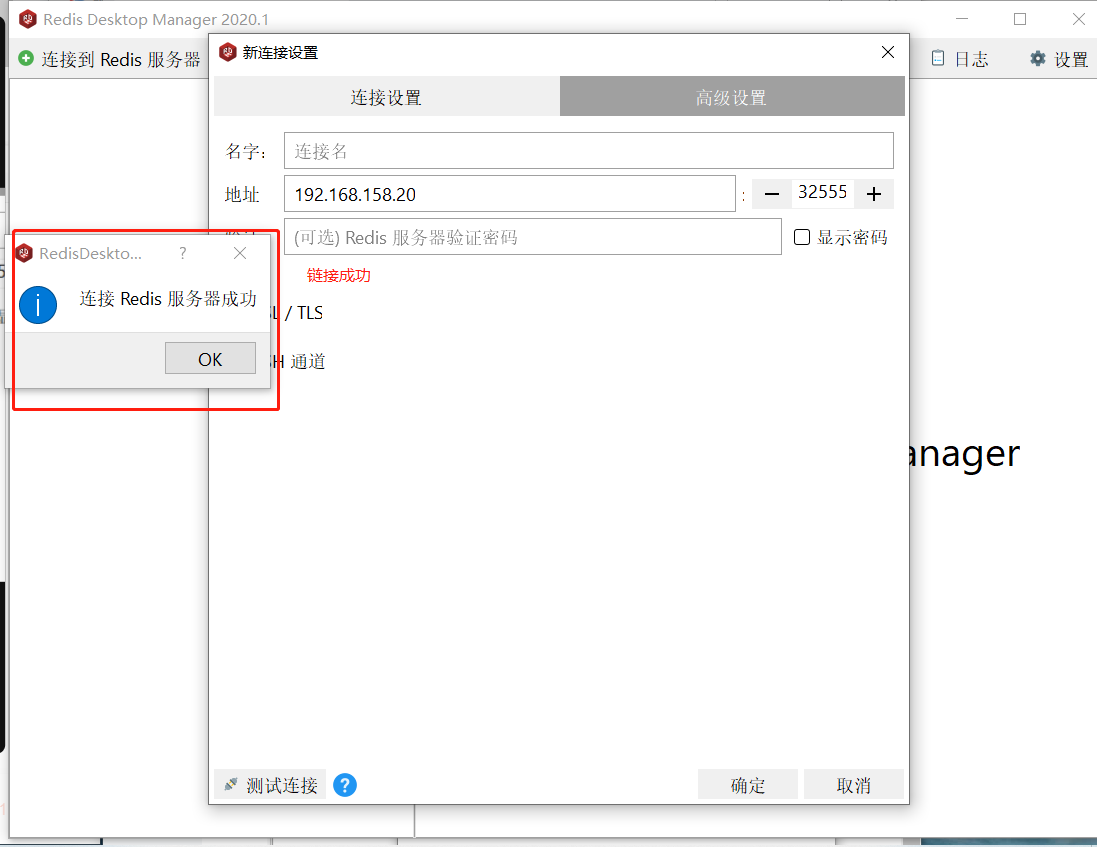

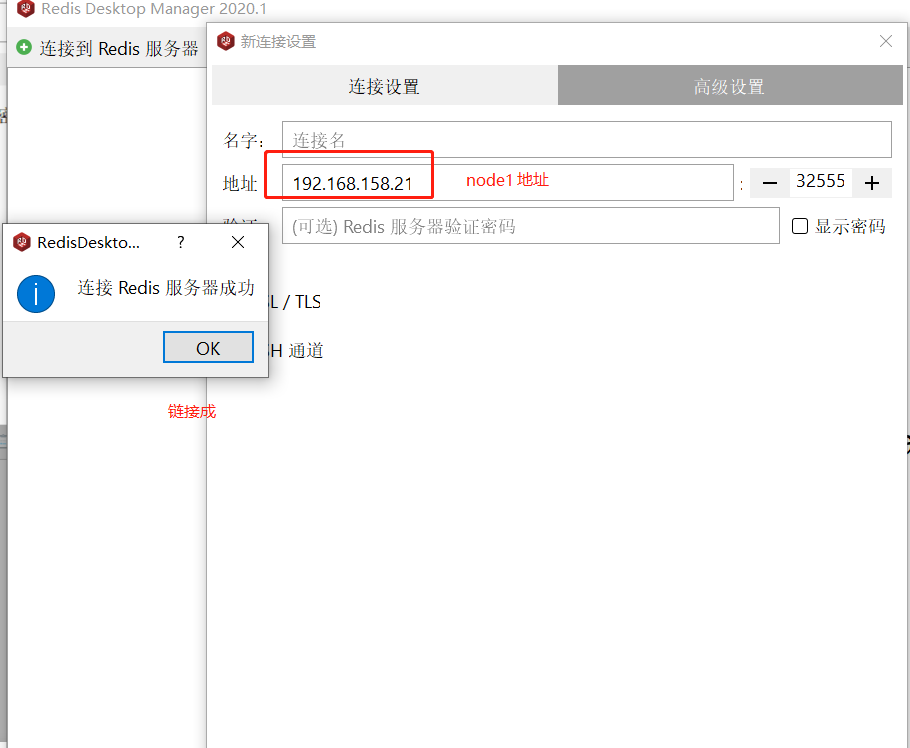

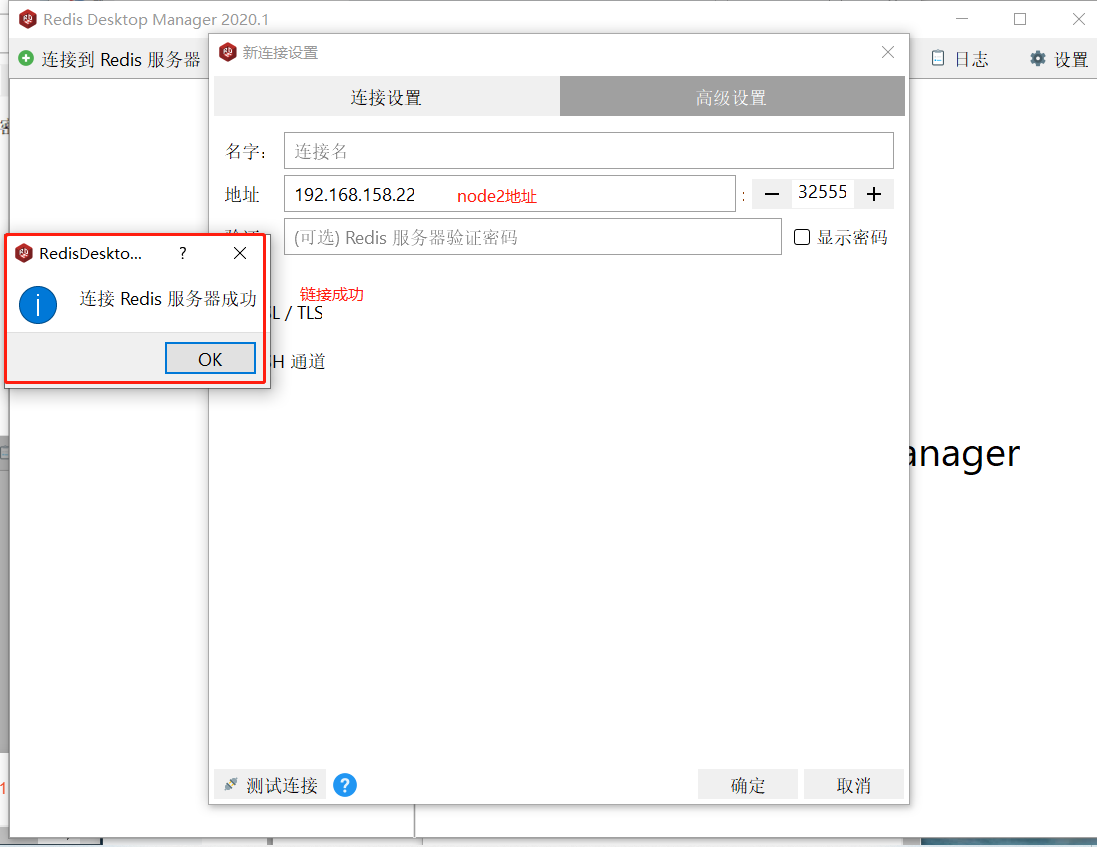

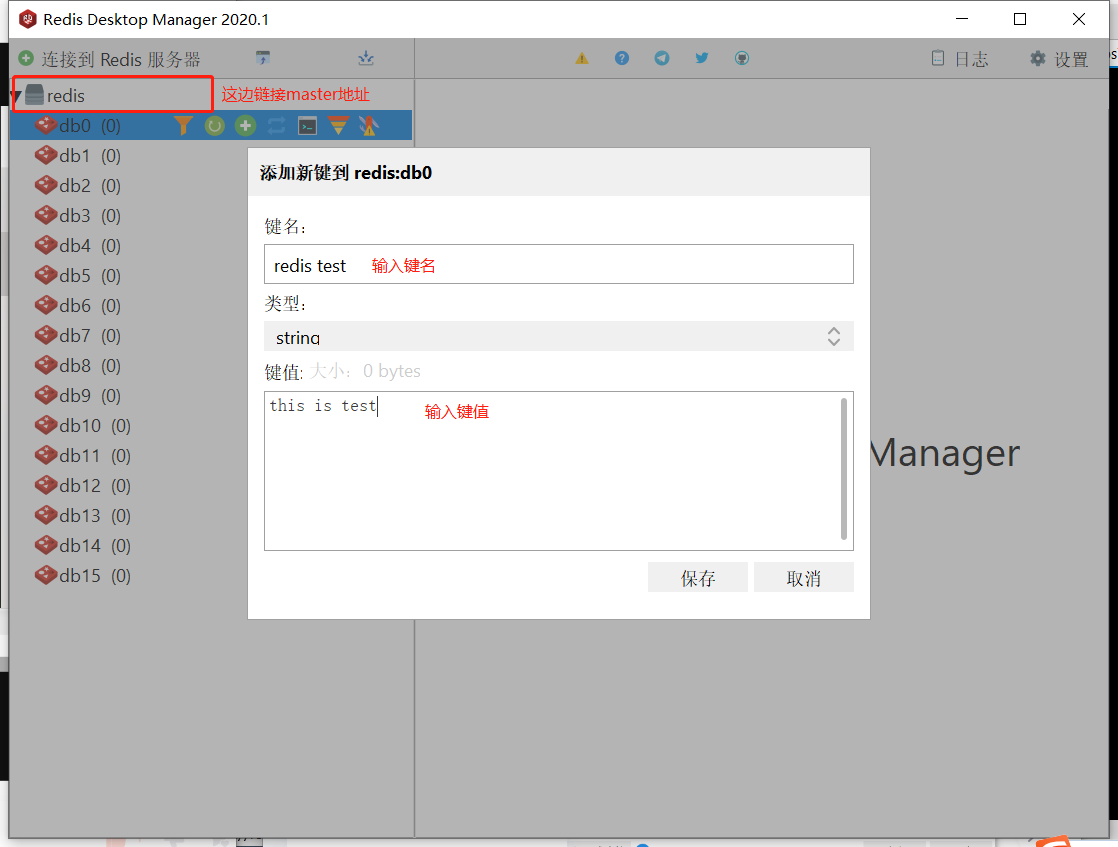

使用Redis Desktop Manager测试redis,安装包在主页资源中

#登入查看创建的键值对 kubectl exec -it redis-deployment-756b4b8956-khw2m bash redis-cli keys * (5)快速编写yaml文件

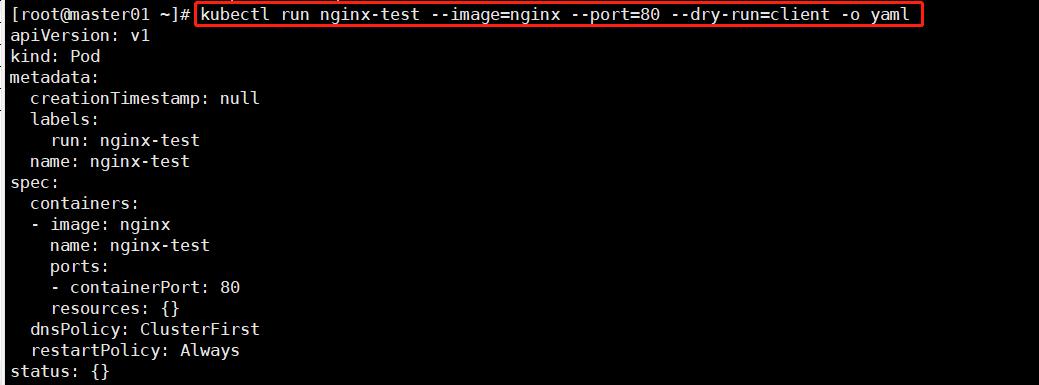

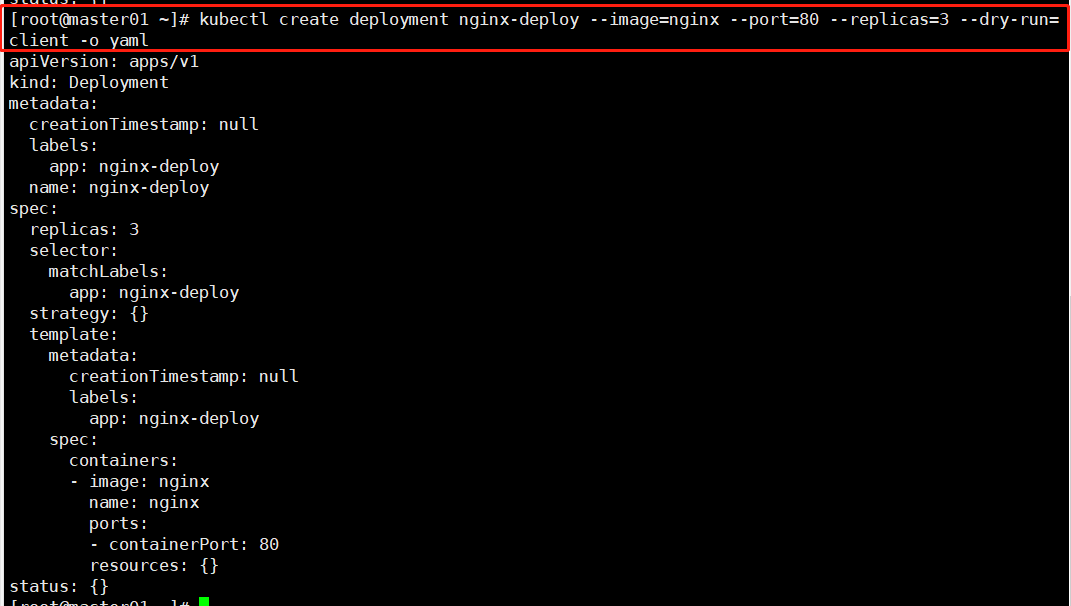

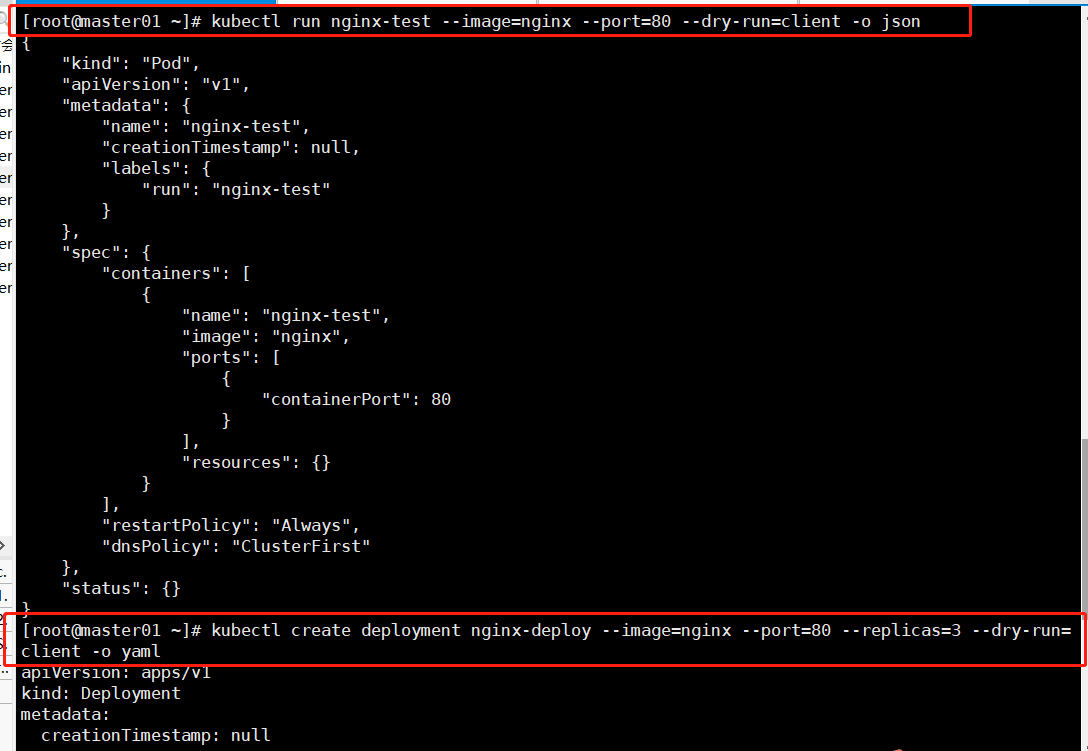

#kubectl run --dry-run=client 打印相应的 API 对象而不执行创建(空跑) kubectl run nginx-test --image=nginx --port=80 --dry-run=client kubectl create deployment nginx-deploy --image=nginx --port=80 --replicas=3 --dry-run=client #查看生成yaml格式 kubectl run nginx-test --image=nginx --port=80 --dry-run=client -o yaml kubectl create deployment nginx-deploy --image=nginx --port=80 --replicas=3 --dry-run=client -o yaml

#查看生成json格式 kubectl run nginx-test --image=nginx --port=80 --dry-run=client -o json kubectl create deployment nginx-deploy --image=nginx --port=80 --replicas=3 --dry-run=client -o json

#使用yaml格式导出生成模板,并进行修改以及删除一些不必要的参数 kubectl run nginx-test --image=nginx --port=80 --dry-run=client -o yaml > nginx-test.yaml kubectl create deployment nginx-deploy --image=nginx --port=80 --replicas=3 --dry-run=client -o yaml > nginx-deploy.yaml

vim nginx-test.yaml apiVersion: v1 kind: Pod metadata: creationTimestamp: null #删除 labels: run: nginx-test name: nginx-test spec: containers: - image: nginx name: nginx-test ports: - containerPort: 80 resources: {} #删除 dnsPolicy: ClusterFirst restartPolicy: Always status: {} #删除

#将现有的资源生成模板导出 kubectl get svc nginx-service -o yaml #保存到文件中 kubectl get svc nginx-service -o yaml > my-svc.yaml #查看字段帮助信息,可一层层的查看相关资源对象的帮助信息 kubectl explain deployments.spec.template.spec.containers 或 kubectl explain pods.spec.containers #快速查看相关模板 kubectl edit (6)案例:自主式创建service并关联上面的pod

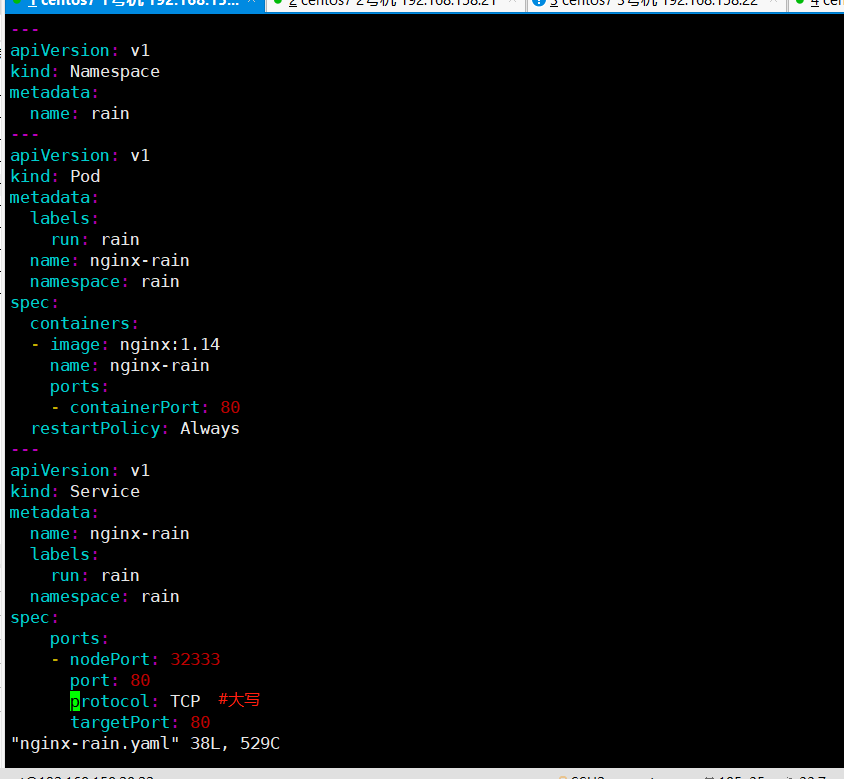

资源类型:pod 自主式

资源名称:nginx-ky29

命名空间:ky29

容器镜像要求:nginx 1.14

容器端口:80

标签:app-ky29

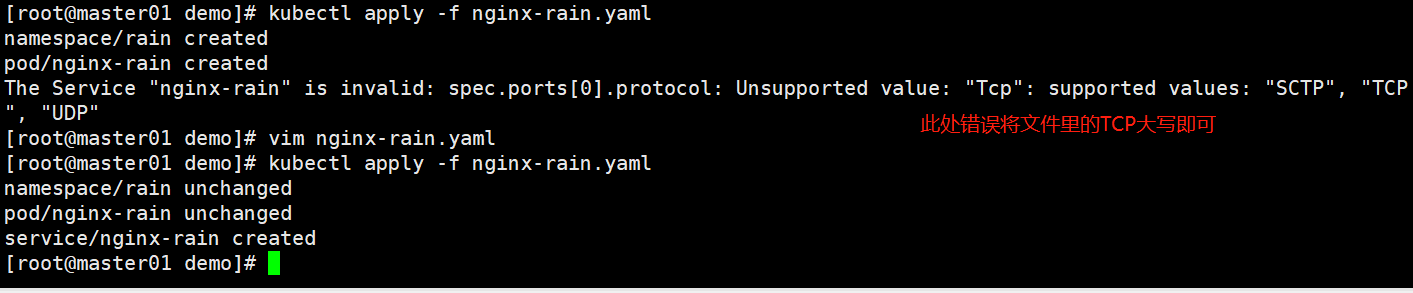

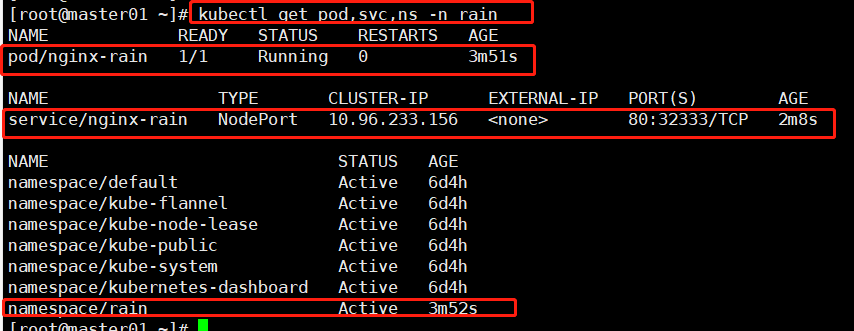

#空跑 kubectl run nginx-rain --image=nginx:1.14 --port=80 --dry-run=client -oyaml > nginx-rain。yaml #复制出来的模板 kubectl create ns rain --dry-run -oyaml

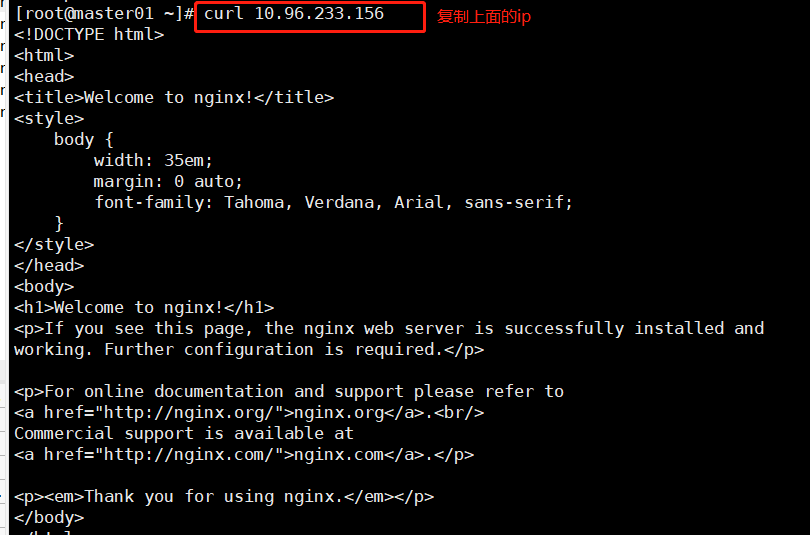

#访问测试 curl 10.96.233.156 http://192.168.158.20:32333/

#写yaml简洁方法 ●用 --dry-run 命令生成 kubectl run my-deploy --image=nginx --dry-run=client -o yaml > my-deploy.yaml ●用get命令导出 kubectl get svc nginx-service -o yaml > my-svc.yaml 或 kubectl edit svc nginx-service #复制配置,再粘贴到新文件 (7)Pod yaml文件详解

apiVersion: v1 #必选,版本号,例如v1 kind: Pod #必选,Pod metadata: #必选,元数据 name: string #必选,Pod名称 namespace: string #必选,Pod所属的命名空间 labels: #自定义标签 - name: string #自定义标签名字 annotations: #自定义注释列表 - name: string spec: #必选,Pod中容器的详细定义 containers: #必选,Pod中容器列表 - name: string #必选,容器名称 image: string #必选,容器的镜像名称 imagePullPolicy: [Always | Never | IfNotPresent] #获取镜像的策略:Alawys表示总是下载镜像,IfnotPresent表示优先使用本地镜像,否则下载镜像,Nerver表示仅使用本地镜像 command: [string] #容器的启动命令列表,如不指定,使用打包时使用的启动命令 args: [string] #容器的启动命令参数列表 workingDir: string #容器的工作目录 volumeMounts: #挂载到容器内部的存储卷配置 - name: string #引用pod定义的共享存储卷的名称,需用volumes[]部分定义的的卷名 mountPath: string #存储卷在容器内mount的绝对路径,应少于512字符 readOnly: boolean #是否为只读模式 ports: #需要暴露的端口库号列表 - name: string #端口号名称 containerPort: int #容器需要监听的端口号 hostPort: int #容器所在主机需要监听的端口号,默认与Container相同 protocol: string #端口协议,支持TCP和UDP,默认TCP env: #容器运行前需设置的环境变量列表 - name: string #环境变量名称 value: string #环境变量的值 resources: #资源限制和请求的设置 limits: #资源限制的设置 cpu: string #Cpu的限制,单位为core数,将用于docker run --cpu-shares参数 memory: string #内存限制,单位可以为Mib/Gib,将用于docker run --memory参数 requests: #资源请求的设置 cpu: string #Cpu请求,容器启动的初始可用数量 memory: string #内存清楚,容器启动的初始可用数量 livenessProbe: #对Pod内个容器健康检查的设置,当探测无响应几次后将自动重启该容器,检查方法有exec、httpGet和tcpSocket,对一个容器只需设置其中一种方法即可 exec: #对Pod容器内检查方式设置为exec方式 command: [string] #exec方式需要制定的命令或脚本 httpGet: #对Pod内个容器健康检查方法设置为HttpGet,需要制定Path、port path: string port: number host: string scheme: string HttpHeaders: - name: string value: string tcpSocket: #对Pod内个容器健康检查方式设置为tcpSocket方式 port: number initialDelaySeconds: 0 #容器启动完成后首次探测的时间,单位为秒 timeoutSeconds: 0 #对容器健康检查探测等待响应的超时时间,单位秒,默认1秒 periodSeconds: 0 #对容器监控检查的定期探测时间设置,单位秒,默认10秒一次 successThreshold: 0 failureThreshold: 0 securityContext: privileged:false restartPolicy: [Always | Never | OnFailure] #Pod的重启策略,Always表示一旦不管以何种方式终止运行,kubelet都将重启,OnFailure表示只有Pod以非0退出码退出才重启,Nerver表示不再重启该Pod nodeSelector: obeject #设置NodeSelector表示将该Pod调度到包含这个label的node上,以key:value的格式指定 imagePullSecrets: #Pull镜像时使用的secret名称,以key:secretkey格式指定 - name: string hostNetwork:false #是否使用主机网络模式,默认为false,如果设置为true,表示使用宿主机网络 volumes: #在该pod上定义共享存储卷列表 - name: string #共享存储卷名称 (volumes类型有很多种) emptyDir: {} #类型为emtyDir的存储卷,与Pod同生命周期的一个临时目录。为空值 hostPath: string #类型为hostPath的存储卷,表示挂载Pod所在宿主机的目录 path: string #Pod所在宿主机的目录,将被用于同期中mount的目录 secret: #类型为secret的存储卷,挂载集群与定义的secre对象到容器内部 scretname: string items: - key: string path: string configMap: #类型为configMap的存储卷,挂载预定义的configMap对象到容器内部 name: string items: - key: string (8)deployment.yaml文件详解

apiVersion: extensions/v1beta1 #接口版本 kind: Deployment #接口类型 metadata: name: cango-demo #Deployment名称 namespace: cango-prd #命名空间 labels: app: cango-demo #标签 spec: replicas: 3 strategy: rollingUpdate: ##由于replicas为3,则整个升级,pod个数在2-4个之间 maxSurge: 1 #滚动升级时会先启动1个pod maxUnavailable: 1 #滚动升级时允许的最大Unavailable的pod个数 template: metadata: labels: app: cango-demo #模板名称必填 sepc: #定义容器模板,该模板可以包含多个容器 containers: - name: cango-demo #镜像名称 image: swr.cn-east-2.myhuaweicloud.com/cango-prd/cango-demo:0.0.1-SNAPSHOT #镜像地址 command: [ "/bin/sh","-c","cat /etc/config/path/to/special-key" ] #启动命令 args: #启动参数 - '-storage.local.retention=$(STORAGE_RETENTION)' - '-storage.local.memory-chunks=$(STORAGE_MEMORY_CHUNKS)' - '-config.file=/etc/prometheus/prometheus.yml' - '-alertmanager.url=http://alertmanager:9093/alertmanager' - '-web.external-url=$(EXTERNAL_URL)' #如果command和args均没有写,那么用Docker默认的配置。 #如果command写了,但args没有写,那么Docker默认的配置会被忽略而且仅仅执行.yaml文件的command(不带任何参数的)。 #如果command没写,但args写了,那么Docker默认配置的ENTRYPOINT的命令行会被执行,但是调用的参数是.yaml中的args。 #如果如果command和args都写了,那么Docker默认的配置被忽略,使用.yaml的配置。 imagePullPolicy: IfNotPresent #如果不存在则拉取 livenessProbe: #表示container是否处于live状态。如果LivenessProbe失败,LivenessProbe将会通知kubelet对应的container不健康了。随后kubelet将kill掉container,并根据RestarPolicy进行进一步的操作。默认情况下LivenessProbe在第一次检测之前初始化值为Success,如果container没有提供LivenessProbe,则也认为是Success; httpGet: path: /health #如果没有心跳检测接口就为/ port: 8080 scheme: HTTP initialDelaySeconds: 60 ##启动后延时多久开始运行检测 timeoutSeconds: 5 successThreshold: 1 failureThreshold: 5 readinessProbe: httpGet: path: /health #如果没有心跳检测接口就为/ port: 8080 scheme: HTTP initialDelaySeconds: 30 ##启动后延时多久开始运行检测 timeoutSeconds: 5 successThreshold: 1 failureThreshold: 5 resources: ##CPU内存限制 requests: cpu: 2 memory: 2048Mi limits: cpu: 2 memory: 2048Mi env: ##通过环境变量的方式,直接传递pod=自定义Linux OS环境变量 - name: LOCAL_KEY #本地Key value: value - name: CONFIG_MAP_KEY #局策略可使用configMap的配置Key, valueFrom: configMapKeyRef: name: special-config #configmap中找到name为special-config key: special.type #找到name为special-config里data下的key ports: - name: http containerPort: 8080 #对service暴露端口 volumeMounts: #挂载volumes中定义的磁盘 - name: log-cache mount: /tmp/log - name: sdb #普通用法,该卷跟随容器销毁,挂载一个目录 mountPath: /data/media - name: nfs-client-root #直接挂载硬盘方法,如挂载下面的nfs目录到/mnt/nfs mountPath: /mnt/nfs - name: example-volume-config #高级用法第1种,将ConfigMap的log-script,backup-script分别挂载到/etc/config目录下的一个相对路径path/to/...下,如果存在同名文件,直接覆盖。 mountPath: /etc/config - name: rbd-pvc #高级用法第2中,挂载PVC(PresistentVolumeClaim) #使用volume将ConfigMap作为文件或目录直接挂载,其中每一个key-value键值对都会生成一个文件,key为文件名,value为内容, volumes: # 定义磁盘给上面volumeMounts挂载 - name: log-cache emptyDir: {} - name: sdb #挂载宿主机上面的目录 hostPath: path: /any/path/it/will/be/replaced - name: example-volume-config # 供ConfigMap文件内容到指定路径使用 configMap: name: example-volume-config #ConfigMap中名称 items: - key: log-script #ConfigMap中的Key path: path/to/log-script #指定目录下的一个相对路径path/to/log-script - key: backup-script #ConfigMap中的Key path: path/to/backup-script #指定目录下的一个相对路径path/to/backup-script - name: nfs-client-root #供挂载NFS存储类型 nfs: server: 10.42.0.55 #NFS服务器地址 path: /opt/public #showmount -e 看一下路径 - name: rbd-pvc #挂载PVC磁盘 persistentVolumeClaim: claimName: rbd-pvc1 #挂载已经申请的pvc磁盘 (9)Service yaml文件详解

apiVersion: v1 kind: Service matadata: #元数据 name: string #service的名称 namespace: string #命名空间 labels: #自定义标签属性列表 - name: string annotations: #自定义注解属性列表 - name: string spec: #详细描述 selector: [] #label selector配置,将选择具有label标签的Pod作为管理 #范围 type: string #service的类型,指定service的访问方式,默认为 #clusterIp clusterIP: string #虚拟服务地址 sessionAffinity: string #是否支持session ports: #service需要暴露的端口列表 - name: string #端口名称 protocol: string #端口协议,支持TCP和UDP,默认TCP port: int #服务监听的端口号 targetPort: int #需要转发到后端Pod的端口号 nodePort: int #当type = NodePort时,指定映射到物理机的端口号 status: #当spce.type=LoadBalancer时,设置外部负载均衡器的地址 loadBalancer: #外部负载均衡器 ingress: #外部负载均衡器 ip: string #外部负载均衡器的Ip地址值 hostname: string #外部负载均衡器的主机名 (10)k8s部署tomcat的yaml文件

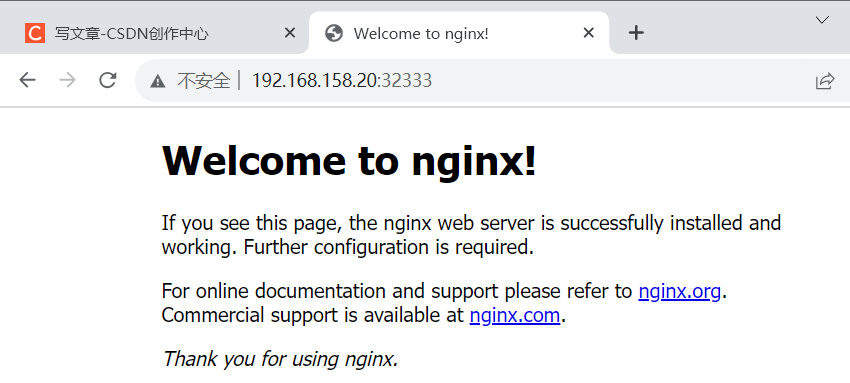

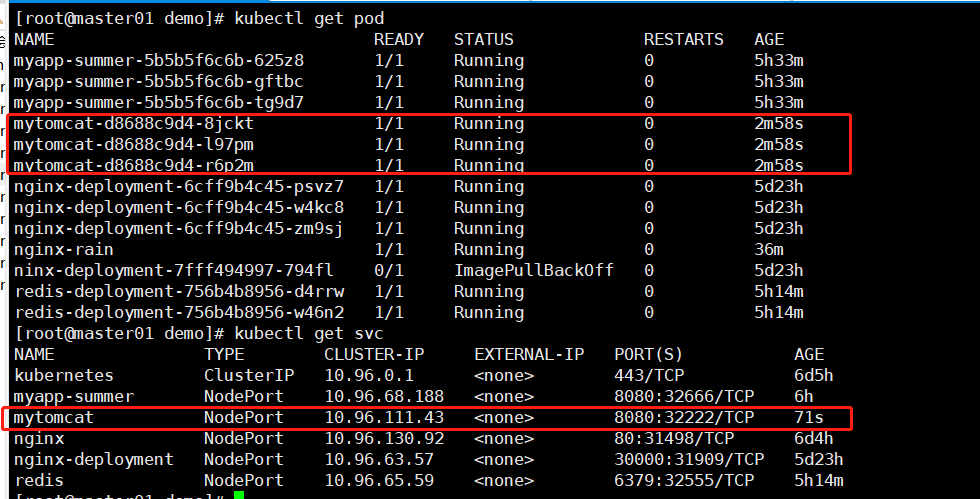

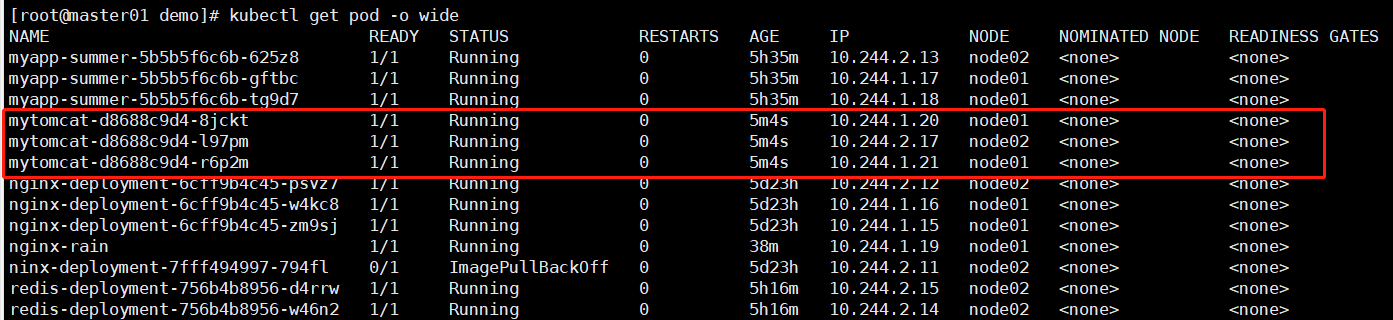

vim tomcat-pod.yaml apiVersion: apps/v1 kind: Deployment metadata: #定义了 Deployment 的元数据信息,包括名称和标签 name: mytomcat spec: #定义了 Deployment 的规范信息,包括副本数、Selector、升级策略 replicas: 3 #指定了 Deployment 所需的 Pod 副本数 selector: #定义了匹配标签的 Selector,以选择要控制的 Pod matchLabels: app: mytomcat minReadySeconds: 1 #指定了 Deployment 进行滚动升级时,新 Pod 可以被认为已准备好的最小时间 progressDeadlineSeconds: 60 #指定了 Deployment 升级的最长时间,超过此时间将标记为失败 revisionHistoryLimit: 5 #定义了 Deployment 可以保留的版本历史数量的最大值 strategy: #定义了 Deployment 进行滚动升级的策略 type: RollingUpdate #指定了滚动升级的类型,此处设置为 RollingUpdate。另一个选项是 Recreate rollingUpdate: #定义了 RollingUpdate 策略的参数 maxSurge: 1 #定义了在进行滚动更新时,最大可以超出指定副本数的 Pod 数量 maxUnavailable: 1 #定义了在进行滚动更新时,最大可以不可用的 Pod 数量 template: #定义了要创建的 Pod 的规范信息,包括容器、端口和卷 metadata: name: mytomcat labels: app: mytomcat spec: containers: #定义了 Pod 中的容器信息 - name: mytomcat #定义了容器的名称,此处设置为 mytomcat image: tomcat:8 #定义了容器要使用的镜像,此处设置为 Tomcat 8 ports: #定义了容器要监听的端口,此处设置为 8080 端口 - containerPort: 8080 volumeMounts: #定义了容器要挂载的卷 - name: zjf-config mountPath: /etc/localtime volumes: #定义了卷的信息,包括名称和挂载路径 - name: zjf-config hostPath: #定义了要挂载的本地主机路径 path: /usr/share/zoneinfo/Asia/Shanghai kubectl apply -f tomcat-pod.yaml vim tomcat-service.yaml apiVersion: v1 kind: Service metadata: name: mytomcat spec: type: NodePort ports: - port: 8080 nodePort: 32222 selector: app: mytomcat #查看创建的pod及svc kubectl get pod kubectl get svc

#查看tomcat的分布node节点 kubectl get pods -o wide

总结:

1.K8S集群中访问流向

port:为service在clusterIP上暴露的端口

targetport:对应容器映射在pod上的端口

nodeport:可以通过在K8S集群外部使用nodeIP+nodePort来去访问service

containerport:容器内部使用的端口

K8S集群内部:客户端——clusterIP:port——通过target port——podIP:containerport

K8S集群外部:客户端——nodeIP:nodeport——通过target port——podIP:containerport

2.语法格式

2.语法格式

通过缩进表示层级关系

不能使用tab进行缩进,只能使用空格,一般开头缩进2个空格

字符后缩进一个空格,比如冒号,逗号等

使用—表示新的yaml文件的开始

使用#表示注释

3.yaml文件组成部署

(1)控制器定义

deployment:定义metadaea、spec、selector

通过yaml完成副本的定义,自主式的

(2)被控制对象

由哪一个控制器(自主式、deployment、statusfulset等)

4.常用字段的含义

如何快速编写yaml

(1)第一种使用kubectl create 命令生成yaml文件

(2)第二种使用kubectl get 命令导出yaml文件