PS:这是我对注意力机制的一些理解不一定保真,为防止日后遗忘,也为了互相学习,故写下此篇文章,如果有误欢迎在评论区中指出,咱们互相进步。

什么是注意力机制

注意力机制是指模型不会同时关注输入特征的所有细节,而是有选择性地聚焦于输入特征的某些特定的部分,而忽略其他不那么重要的信息这有助于更有效地处理信息。

注意力机制的原理

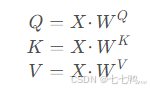

注意力机制中先分别初始化QKV的权重矩阵Wq,Wk,Wv,然后将输入X分别与这三个权重矩阵点乘从而获得三个向量:查询(Query,Q)、键(Key,K)和值(Value,V)

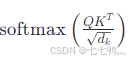

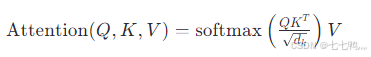

然后,计算Q和K的点积来计算查询向量和键向量之间的相似度得分,但是为了防止这个值太大,还需要除于根号键K的维度,然后对得到的得分应用softmax函数,将其转化为概率分布,即注意力权重

最后我们将得到的注意力权重和值V相乘得到最终的注意力输出

什么是自注意力机制

自注意力是注意力机制中的一种,它是特点是注意力机制中的QKV全部来自同一个输入,这允许每个序列元素都能够参考序列中所有其他元素的信息,让模型能够注意到整个输入中不同部分之间的相关性,并将相关部分的权重提高,从而保留相关的部分(这在自然语言处理中叫上下文理解,在图像处理中能解决意外引进的噪音)。

自注意力机制的作用

在自然语言处理中能够帮助实现上下文理解,在图像处理中可以帮助模型识别图像中不同区域之间的关系,从而更有效地聚合全局和局部特征。

自注意力机制的缺点

自注意力机制的原理是筛选重要信息,过滤不重要信息,这就导致其有效信息的抓取能力会比CNN小一些。这是因为自注意力机制相比CNN,无法利用图像本身具有的尺度,平移不变性,以及图像的特征局部性(图片上相邻的区域有相似的特征,即同一物体的信息往往都集中在局部)这些先验知识,只能通过大量数据进行学习。这就导致自注意力机制只有在大数据的基础上才能有效地建立准确的全局关系,而在小数据的情况下,其效果不如CNN

什么是交叉注意力机制

交叉注意力是注意力机制中的一种,它是特点是注意力机制中的Q是查询的条件,KV是被查询的对象,这允许网络融合多模态的输入,或者根据外部输入的条件去指导网络的输出。