文章目录

1. 背景介绍

在深度学习的目标检测任务中,类别不平衡问题一直是提升模型性能的拦路虎。Focal Loss损失函数应运而生,专为解决这一难题设计。本文将深入探讨Focal Loss的背景、计算方法、应用场景以及如何在实际项目中应用。

目标检测是计算机视觉领域的一个核心问题,而深度学习的发展极大地推动了目标检测技术的进步。然而,类别不平衡——即不同类别的样本数量差异巨大——却严重影响了模型的泛化能力。Focal Loss由何凯明等人于2017年提出,旨在解决分类问题中的类别不平衡和难易样本不均衡问题。

2. Loss计算公式

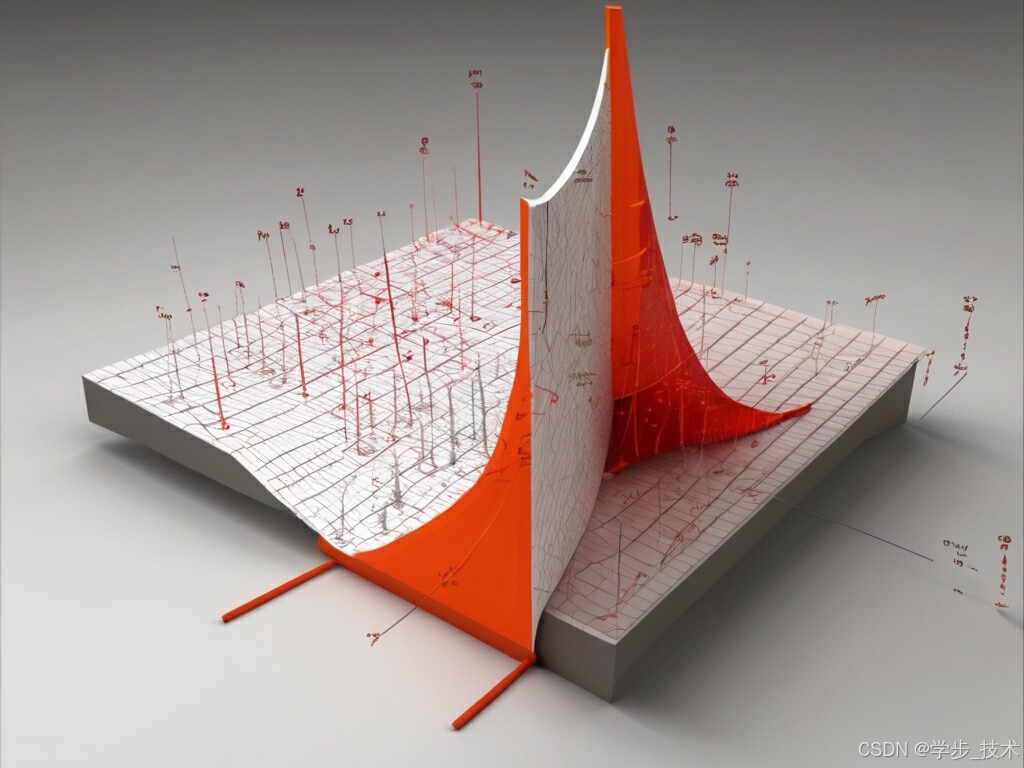

Focal Loss是对传统交叉熵损失函数的一种改进,其计算公式如下:

Focal Loss = − α t ( 1 − p t ) γ log ( p t ) \text{Focal Loss} = -\alpha_t (1 - p_t)^\gamma \log(p_t) Focal Loss=−αt(1−pt)γlog(pt)

其中:

- p t p_t pt是模型对于实际类别的预测概率。

- α t \alpha_t αt是平衡正负样本的权重系数。

- γ \gamma γ是调节易难样本权重的聚焦参数。

Focal Loss的核心思想是减少易分类样本的权重,同时增加难分类样本的权重,从而使得模型更加关注那些难以正确分类的样本。

3. 使用场景

Focal Loss作为一种先进的损失函数,自提出以来已在多个深度学习领域展现出其独特的优势和广泛的应用潜力。以下是对Focal Loss使用场景的扩展描述:

- 目标检测:在目标检测任务中,如Faster R-CNN、SSD等模型,Focal Loss专门用于解决类别不平衡问题,特别是当背景类别远多于目标类别时。通过降低易分类样本的权重并增加难分类样本的权重,Focal Loss有助于模型专注于难以识别的目标,从而提高检测精度。

- 多标签分类:在多标签分类问题中,单个样本可能同时属于多个类别。Focal Loss通过动态调整每个类别的损失权重,使得模型能够更加平衡地学习所有相关的标签,即便某些类别的样本数量相对较少。

- 小样本学习:在小样本学习场景中,由于可用的数据量有限,模型容易过拟合。Focal Loss通过减少对常见或易分类样本的关注,使得模型能够更加关注那些稀有或难分类的样本,从而在有限数据的情况下也能学习到有效的特征表示。

- 医学图像分析:在医学图像领域,Focal Loss可用于改善模型对罕见疾病或异常情况的识别能力。由于医学图像数据往往类别不平衡,Focal Loss有助于提升模型对关键但较少出现的病理特征的敏感度。

- 异常检测:在异常检测中,正常情况的数据量通常远大于异常情况的数据量。Focal Loss能够有效地优化模型,使其更加关注异常样本,从而提高异常检测的准确性。

- 细粒度分类:在细粒度分类任务中,不同类别之间的差异可能非常微小,但类别内部的样本差异可能很大。Focal Loss可以帮助模型更好地区分这些细微的差别,提高分类精度。

- 实时系统:在需要实时反馈的系统中,如自动驾驶或视频监控,Focal Loss可以加速模型的训练过程,同时保持或提高模型性能,因为它减少了对简单样本的处理时间。

- 资源受限的环境:在计算资源受限的环境中,Focal Loss有助于提高模型训练的效率,因为它允许模型集中资源处理更难的样本,而不是在易分类样本上浪费时间。

通过这些应用场景,我们可以看到Focal Loss在处理类别不平衡、难易样本不均等的问题上具有显著的优势。随着深度学习技术的不断发展,Focal Loss预计将在未来的应用中发挥更大的作用。

4. 代码样例

以下是使用Python和PyTorch库实现Focal Loss的示例代码:

import torch import torch.nn as nn import torch.nn.functional as F class FocalLoss(nn.Module): def __init__(self, alpha=1, gamma=2, reduction='mean'): super(FocalLoss, self).__init__() self.alpha = alpha self.gamma = gamma self.reduction = reduction def forward(self, inputs, targets): bce_loss = F.binary_cross_entropy_with_logits(inputs, targets, reduction='none') pt = torch.exp(-bce_loss) F_loss = self.alpha * (1 - pt) ** self.gamma * bce_loss if self.reduction == 'mean': return torch.mean(F_loss) elif self.reduction == 'sum': return torch.sum(F_loss) else: return F_loss # 假设有一些预测和目标 predictions = torch.randn(10, requires_grad=True) # 模型预测 targets = torch.empty(10).random_(2) # 真实标签 # 实例化FocalLoss并计算损失 focal_loss = FocalLoss(alpha=0.25, gamma=2) loss = focal_loss(predictions, targets) print("Focal Loss:", loss.item()) # 反向传播 loss.backward() 5. 总结

Focal Loss通过聚焦于难分类样本,有效解决了深度学习中类别不平衡和难易样本不均衡的问题,尤其在目标检测等领域表现出色。然而,Focal Loss的超参数调整需要仔细考虑,以确保模型能够平衡好易分类和难分类样本。希望本文能够帮助读者深入理解Focal Loss,并在实际项目中有效应用。