引言:种下一棵树最好的时间是十年前,其次是现在

书接上回:将对话式人工智能引入您的本地设备成为可能CSDN![]() https://mp.csdn.net/mp_blog/creation/editor/140865426

https://mp.csdn.net/mp_blog/creation/editor/140865426

目的:在这个大模型横行的时候,我们常用电脑如何开展大模型的工作,上篇文章已经提到,那么这篇文章我教大家怎么去实践。

1、首先官方合作的Github地址供你们参考下载:DocQAGitHub - afaqueumer/DocQA: Question Answering with Custom FIles using LLMsQuestion Answering with Custom FIles using LLMs. Contribute to afaqueumer/DocQA development by creating an account on GitHub.![]() https://github.com/afaqueumer/DocQA?tab=readme-ov-file

https://github.com/afaqueumer/DocQA?tab=readme-ov-file

2、本文引入的大模型地址下载:llama-7b.ggmlv3.q3_K_S.bin

https://huggingface.co/TheBloke/LLaMa-7B-GGML/tree/main

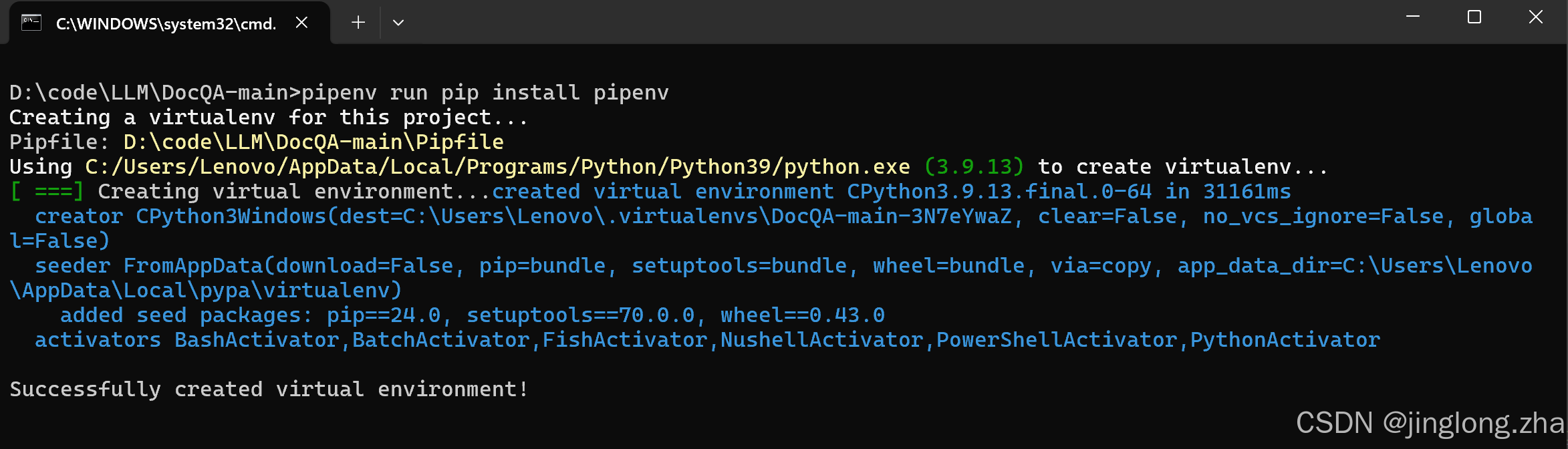

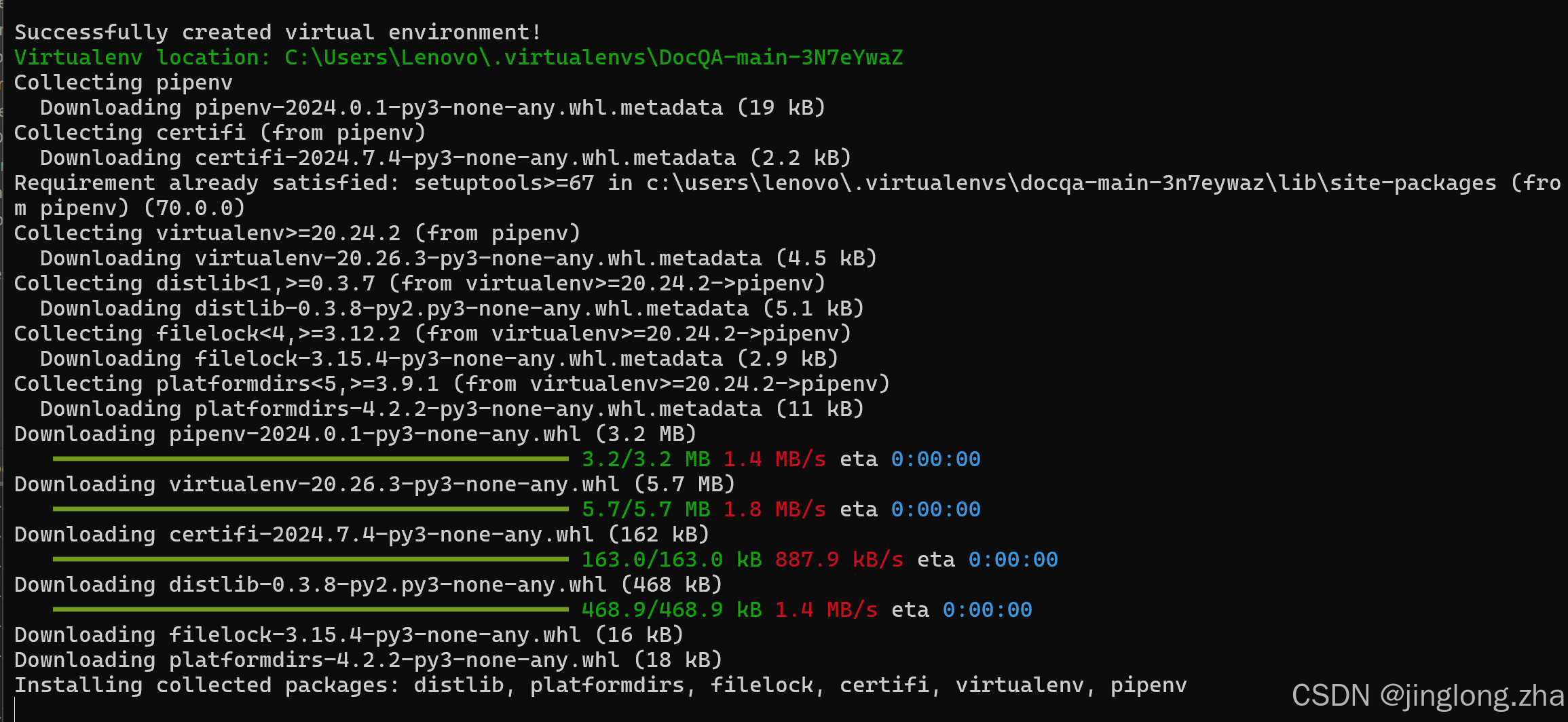

3、运行setup_env.bat

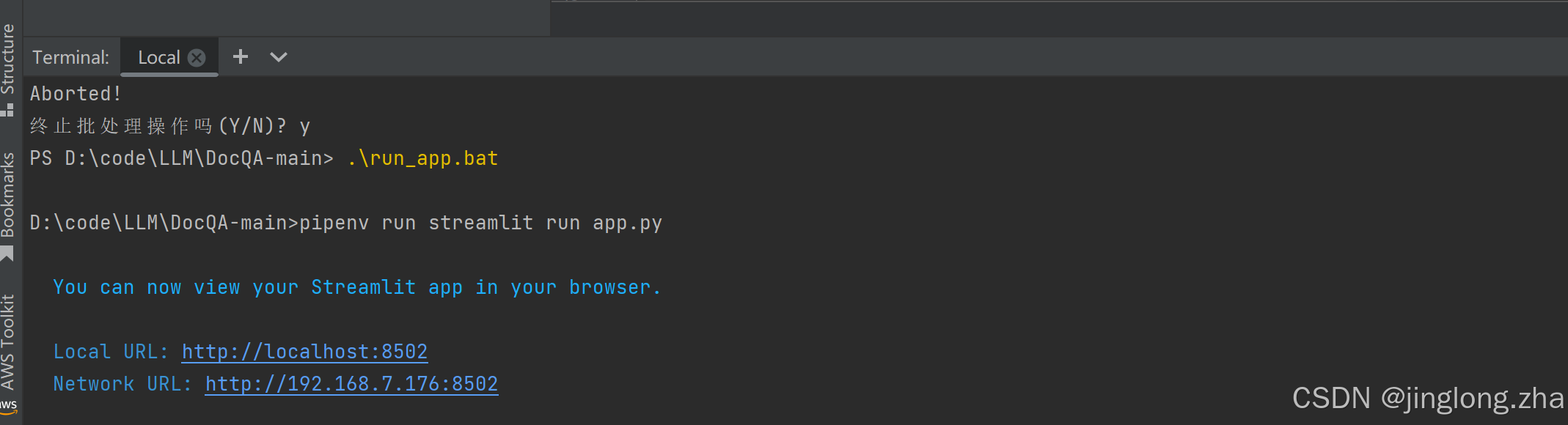

4、运行run_app.bat

5、结果展示,运行成功

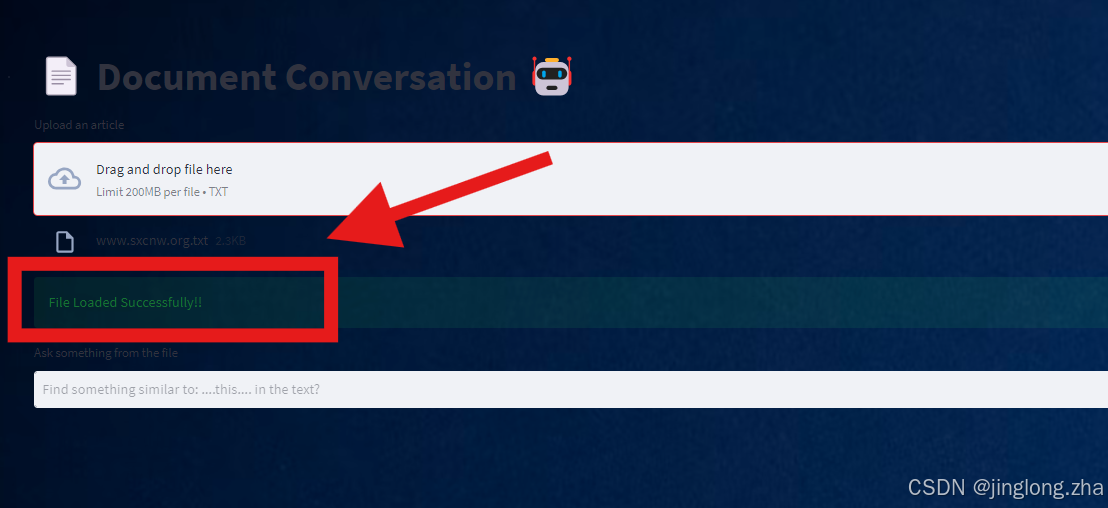

6、上传txt文件(Tips,目前英文的,中文报错,大家可以调试)

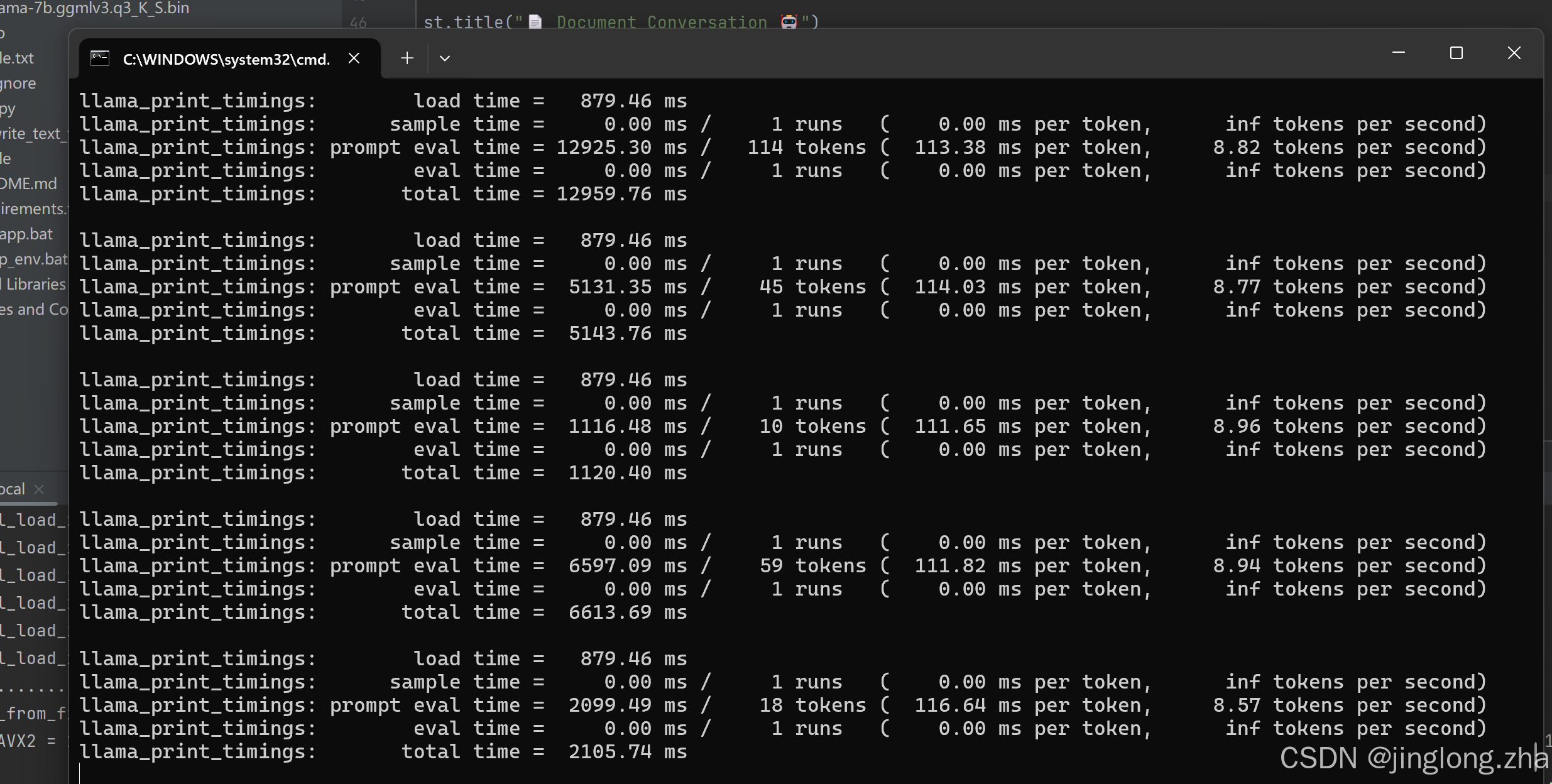

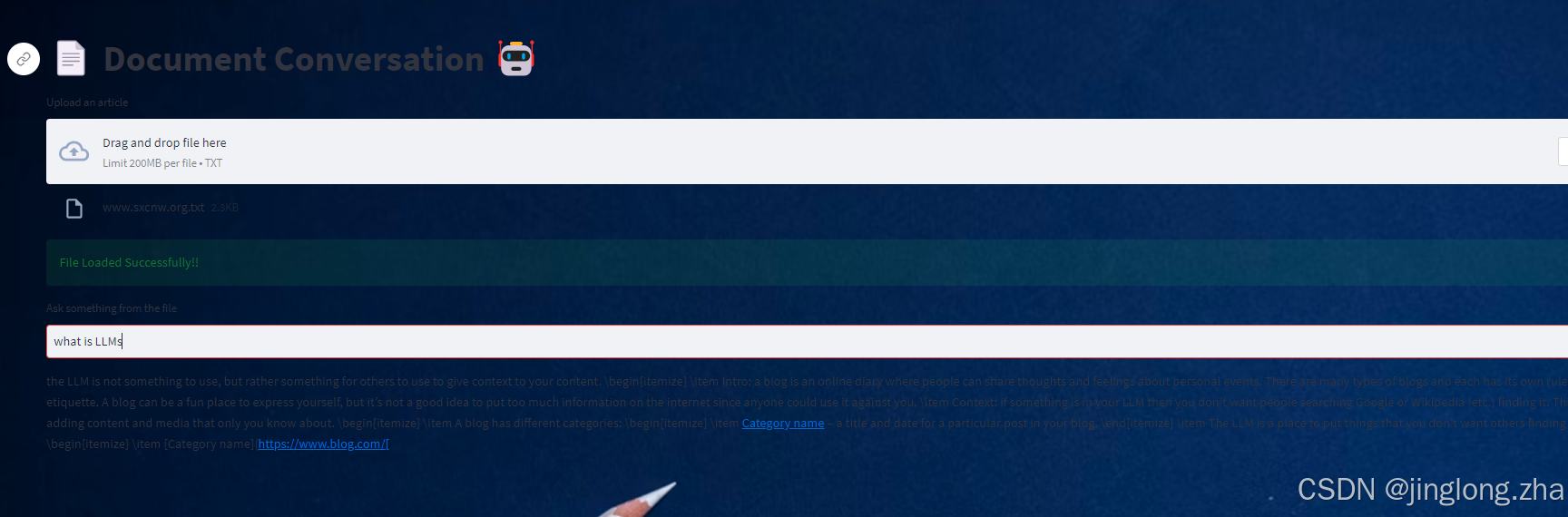

7、文本框里边提问:下面是跑的结果,跟你训练的数据有关系,数据量太小的话,有可能造成幻读,大家可以多跑一些数据,测试一下效果,毕竟cpu电脑跑数据还是挺差劲的,太慢了!!!

好了,今天就先到这里,如果有什么不懂的?可以私聊一下老师,欢迎大家一键三连啊!!!