近年来,随着图神经网络(GNN)在各种复杂网络数据中的广泛应用,如何提升其在大规模图上的效率和性能成为了研究的热点之一。在这个背景下,标签注意蒸馏(Label Attention Distillation,简称LAD)作为一种新兴的技术,为优化GNN模型的训练和推理过程提供了一种创新的解决方案。

本文所涉及所有资源均在传知代码平台可获取

目录

概述

在当今的数据科学领域,Graph Neural Networks (GNNs) 已成为处理图结构数据的强大工具。然而,传统的GNN在图分类任务中面临一个重要挑战——嵌入不对齐问题。本文将介绍一篇名为“Label Attentive Distillation for GNN-Based Graph Classification”的论文,该论文提出了一种新颖的解决方案——LAD-GNN,以显著提升图分类的性能,您可以在 AAAI 上找到这篇论文的详细内容。

本文提出了一种新的图神经网络训练方法,称为 LAD-GNN。该方法通过标签注意蒸馏,显著提高了图分类任务的准确性。其主要思路是在训练过程中引入标签信息,通过师生模型架构,实现类友好的节点嵌入表示。

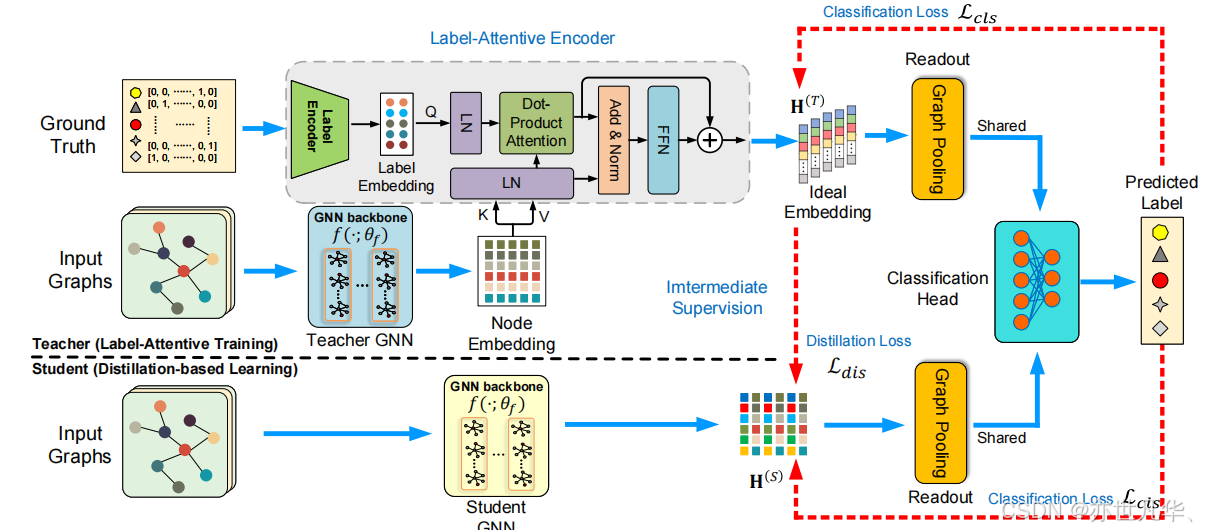

论文的主要创新点在于提出了一种名为标签注意蒸馏方法(LAD-GNN)的新颖方法。该方法通过引入标签注意编码器,将节点特征与标签信息结合在一起,生成更加理想的嵌入表示。标签注意编码器能够捕捉全局图信息,使得节点嵌入更加对齐,从而解决了传统GNN中常见的嵌入不对齐问题。此外,该方法采用了基于师生模型架构的蒸馏学习策略,教师模型通过标签注意编码器生成高质量的嵌入表示,学生模型通过蒸馏学习从教师模型中学习类友好的节点嵌入表示,从而优化图分类任务的性能。实验结果表明,LAD-GNN在多个基准数据集上显著提高了图分类的准确性,展示了其在图神经网络领域的创新性和有效性。以下是 LAD-GNN 的模型架构图:

该框架图可以看到该框架分为教师模型和学生模型两个阶段:

教师模型的训练过程是通过一种标签关注的训练方法进行的。在这个过程中,标签关注编码器会将真实标签编码成标签嵌入,并将其与由GNN骨干生成的节点嵌入结合,使用注意力机制形成一个理想的嵌入。这个理想嵌入被送入读出函数和分类头,以预测图的标签。标签关注编码器与GNN骨干一起训练,目的是最小化分类损失。

在学生模型的训练阶段,采用了一种基于蒸馏的方法。具体来说,教师模型训练完成后,生成的理想嵌入作为中间监督指导学生模型的训练。学生模型共享教师模型的分类头,通过最小化分类损失和蒸馏损失来继承教师模型的知识,生成有利于图级任务的节点嵌入。

在整个框架中,标签关注编码器起到了关键作用。它由标签编码器和多个注意力机制层组成,通过将标签嵌入和节点嵌入进行特征融合,捕捉两者之间复杂的关系,从而增强模型的表达能力。在实际操作中,标签编码器使用多层感知器(MLP)将标签编码成潜在嵌入,随后通过类似Transformer架构的注意力机制进行处理,形成高级的潜在表示。

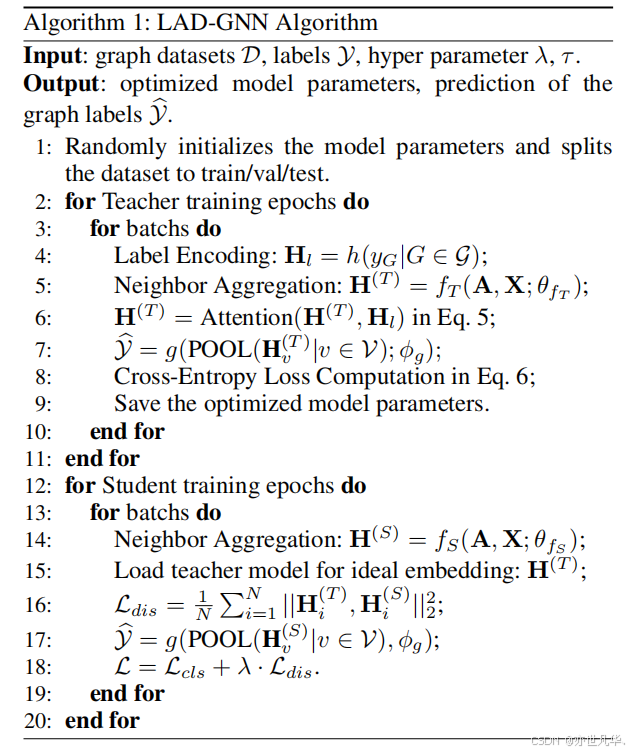

算法流程

标签注意蒸馏方法:

教师模型:使用标签注意编码器,将节点特征与标签信息结合,生成理想的嵌入表示。

学生模型:通过蒸馏学习,从教师模型中学习类友好的节点嵌入表示,以优化图分类任务。

方法流程:

标签注意教师训练:通过标签注意编码器,将节点特征与标签信息融合,生成理想的嵌入表示,并进行图分类训练。

蒸馏学生学习:学生模型通过蒸馏学习,从教师模型的理想嵌入表示中学习,生成类友好的节点嵌入表示,以提升图分类性能。

核心逻辑

论文通过在10个基准数据集上的实验验证了 LAD-GNN 的有效性。结果表明,与现有的最先进GNN方法相比,LAD-GNN 显著提高了图分类的准确性。例如,在 IMDB-BINARY 数据集上,LAD-GNN 使用 GraphSAGE 骨干网实现了高达16.8%的准确性提升,这个结果比许多单独使用GNN训练的结果都更好:

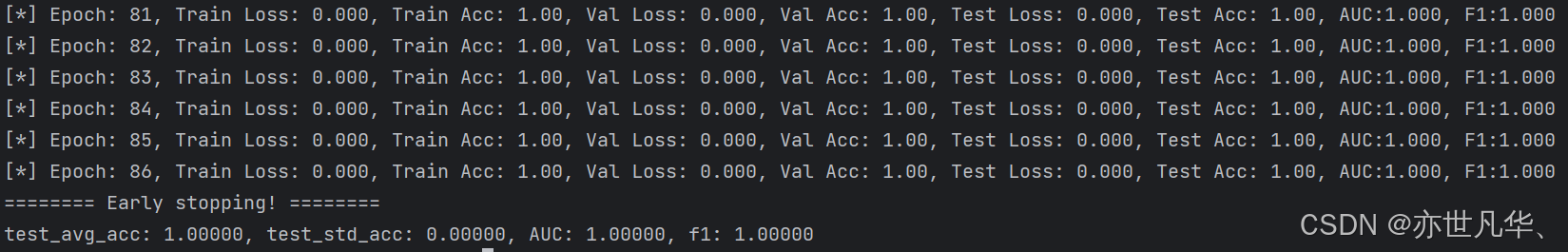

MUTAG 教师训练:

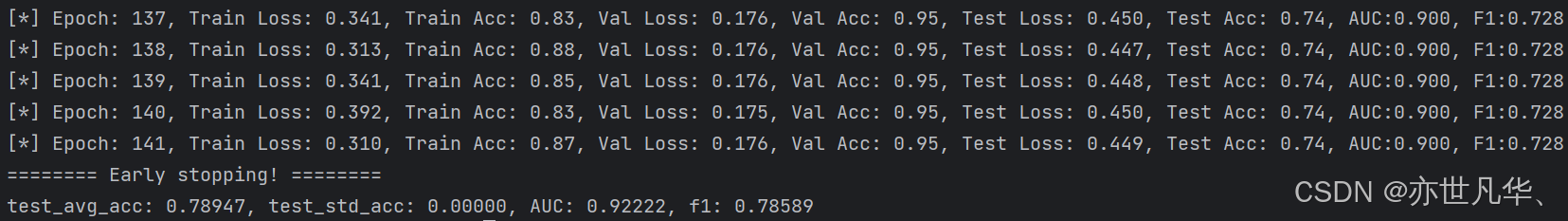

MUTAG 学生训练:

运行模型很简单,只需要下面两行命令,第一个是先运行教师模型,数据集可以根据数据名称在–dataset MUTAG这里更改,然后还有seed,一般情况下需要使用10个不同的seed进行训练,然后取平均值,数据集不需要自己下载,会自己联网下载,运行过程中请不要使用科技,否则下载会失败。

使用标签注意编码器运行教师模型:

python main.py --dataset MUTAG --train_mode T --device 0 --seed 1 --nhid 64 --nlayers 2 --lr 0.01 --backbone GCN老师模型训练完成之后使用该命令进行学生模型训练:

python main.py --dataset MUTAG --train_mode S --device 0 --seed 1 --nhid 64 --nlayers 2 --lr 0.001 --backbone GCN代码目录如下:

LAD-GNN/ │ ├── Figures/ # 图片目录 │ ├── motivation_fig.jpg # 动机示意图 │ ├── framework.jpg # 整体框架图 │ ├── dataset.jpg # 数据集示意图 │ └── result.jpg # 结果示意图 │ ├── GNN_models/ # 存放不同的图神经网络模型 │ ├── base_model.py │ ├── gat.py # 图注意力网络模型 │ ├── gcn.py # 图卷积网络模型 │ ├── gin.py # 图同构网络模型 │ ├── pna.py # 物理网络嵌入模型 │ └── sage.py # 子图聚合增强网络模型 │ ├── checkpoints/ # 模型检查点目录 │ └── GCN/ # GCN模型的检查点 │ ├── data/ # 数据集目录 │ └── MUTAG/ # 包含MUTAG数据集的子目录 │ ├── MUTAG │ ├── processed │ └── raw │ ├── README.md # 项目说明文件 ├── main.py # 主要的Python脚本,用于执行模型训练和测试 ├── test.py # 用于测试模型性能的脚本 ├── requirements.txt # 项目依赖文件 └── utils.py # 包含一些辅助函数的脚本写在最后

LAD-GNN标签注意蒸馏技术作为提升图神经网络(GNN)性能的创新方法,在当前复杂网络分析领域展现了巨大的潜力和前景。通过引入标签注意力机制,LAD-GNN有效地优化了模型的训练和推理过程,显著提升了模型在节点分类、图分类等任务中的准确性和效率。

本文深入探讨了LAD-GNN的技术原理,解析了其在信息传递和损失优化中的作用机制。通过实验效果的分析,我们展示了LAD-GNN在大规模图数据上优于传统方法的性能表现,特别是在处理标签稀疏或噪声数据时的优势。

未来,随着对复杂网络数据需求的增加,LAD-GNN技术有望在社交网络分析、生物信息学、推荐系统等多个领域得到广泛应用。然而,要实现其在实际工程中的全面应用,仍需解决模型扩展性、泛化能力以及计算效率等方面的挑战。因此,进一步的研究和探索将为推动LAD-GNN技术的进一步发展和应用提供重要的指导和支持。

通过本文的探讨,希望读者能够深入理解LAD-GNN技术的价值和应用前景,为其在未来的研究和实践中提供启发和指导。

详细复现过程的项目源码、数据和预训练好的模型可从该文章下方附件获取。