(笔记本电脑:intel处理器i9-13900HX、64G内存、NVIDIA RTX4080(12G)、操作系统windows11家庭版)

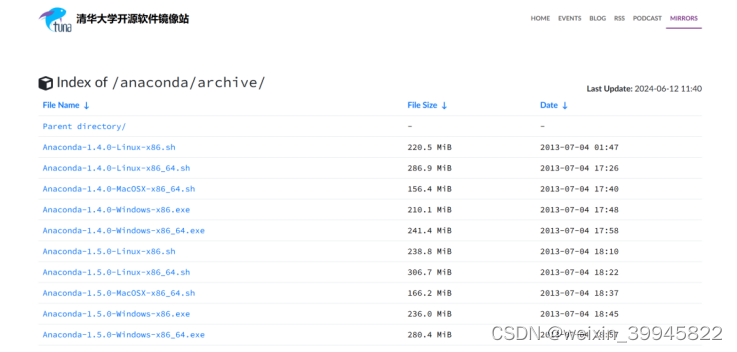

一、下载anaconda3

1.清华镜像源下载anaconda3。下载地址:Index of /anaconda/archive/ | 清华大学开源软件镜像站 | Tsinghua Open Source Mirror

在网页上找到Anaconda3-2024.02-1-Windows-x86_64.exe,点击下载。

2.双击安装文件,选择安装目录D:\anaconda3。

3.配置系统环境变量。在path 中添加环境变量:D:\anaconda3,D:\anaconda3\Scripts,D:\anaconda3\Library\bin,D:\anaconda3\Library\mingw-w64\bin,D:\anaconda3\Library\user\bin

二、创建chatglm虚拟环境

1.运行Windows PowerShell,创建虚拟环境chatglm:

conda create -n chatglm。

2.激活虚拟环境:conda activate chatglm。

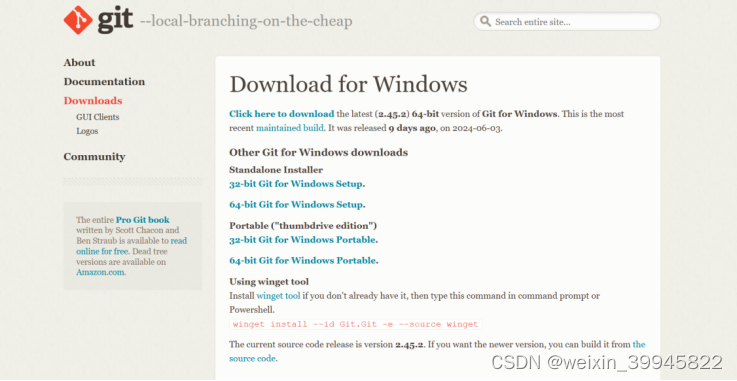

三、安装git命令运行环境

打开网址https://git-scm.com/download/win,点击“64-bit Git for Windows Setup”,下载文件Git-2.45.2-64-bit.exe,双击安装。

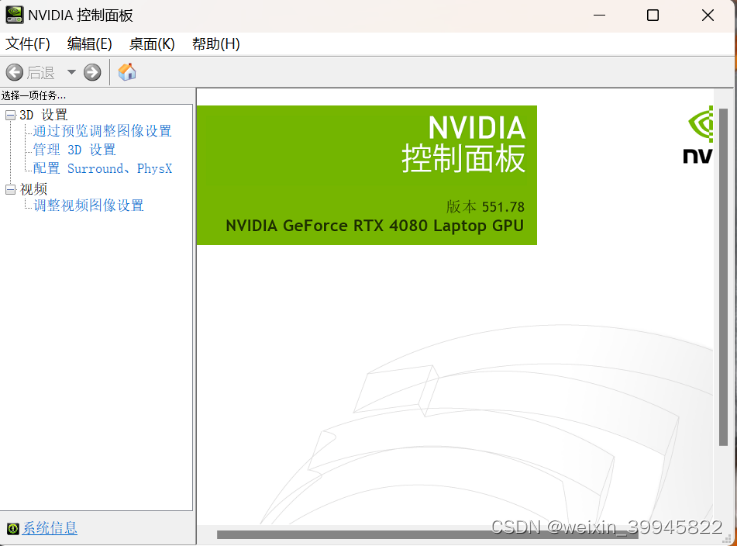

四、安装显卡驱动

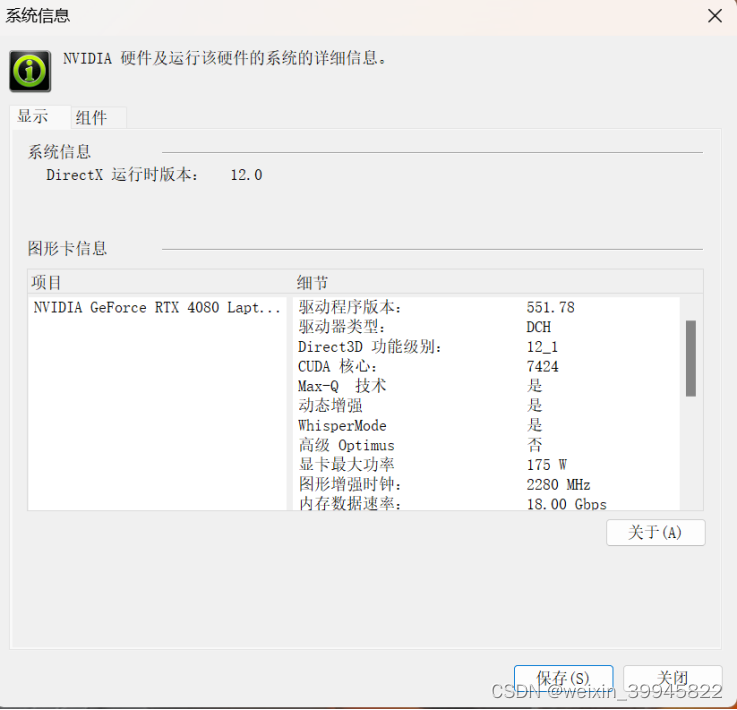

1.查看显卡信息。pytorch安装和显卡驱动版本有关,所以需要先检查显卡驱动版本:nvidia-smi。

2.cuda下载及安装。

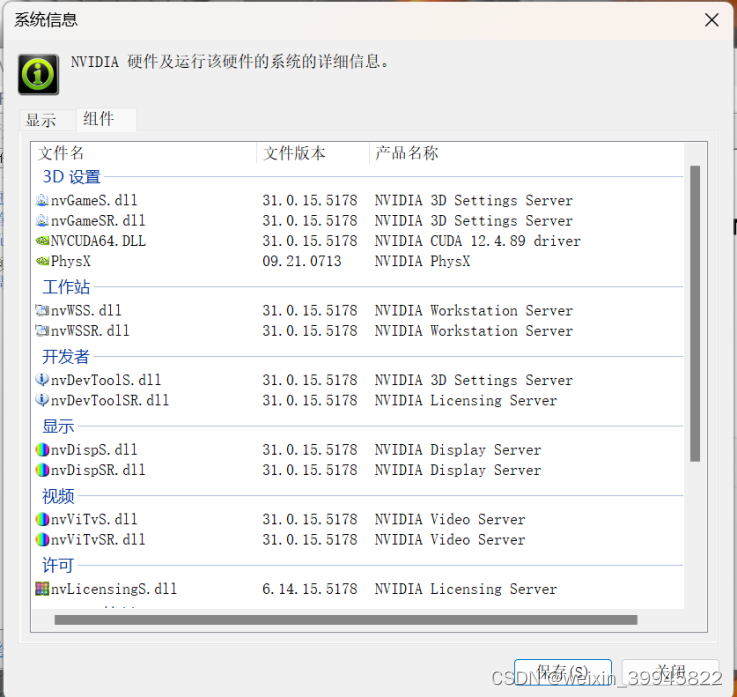

在笔记本电脑桌面点击鼠标右键->点击“显示更多选项”->点击“NIVIDIA控制面板”->点击左下角的“系统信息”->点击“组件”,可以看到第三行,笔记本电脑支持的CUDA版本是12.4.89

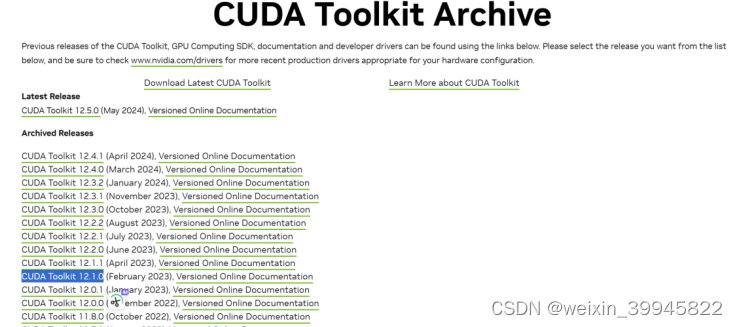

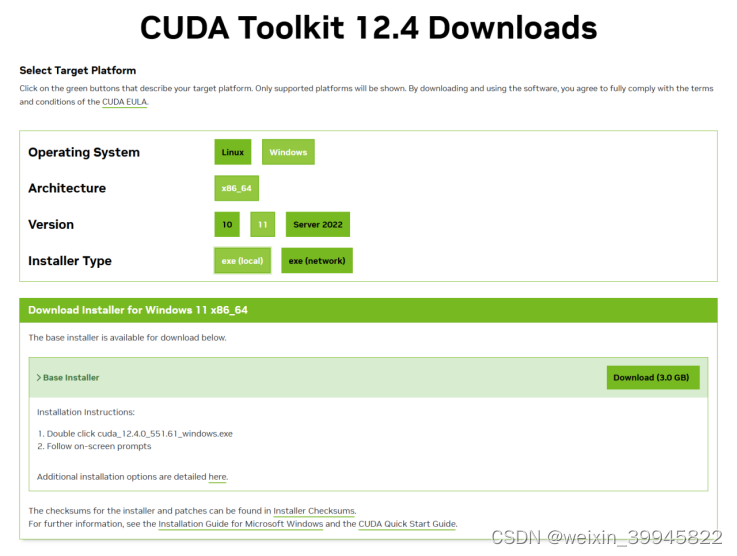

在https://developer.nvidia.com/cuda-toolkit-archive下载相应的cuda软件,比如选择CUDA Toolkit 12.4.1。

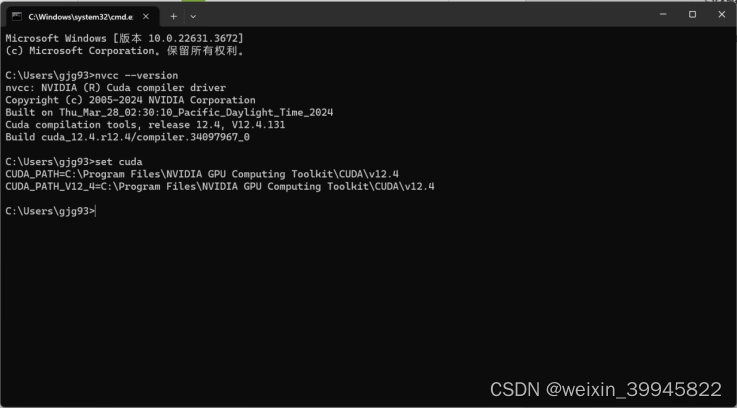

下载后点击文件cuda_12.4.1_551.78_windows.exe,安装时选择默认配置。验证是否安装成功:运行cmd,输入nvcc --version 即可查看版本号;set cuda,可以查看 CUDA 设置的环境变量。

安装之后增加两个系统环境变量:

变量名CUDA_PATH,变量值C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.4

变量名CUDA_PATH_V12_4,变量值C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.4

3.cudnn下载及安装。

在https://developer.nvidia.com/rdp/cudnn-download,使用邮箱注册一个账号。

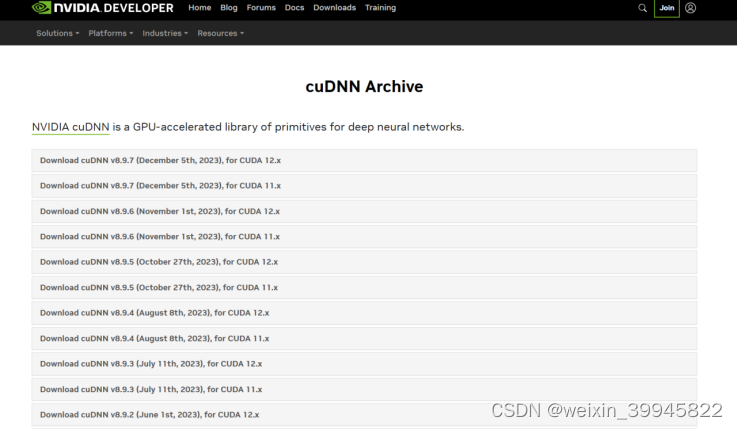

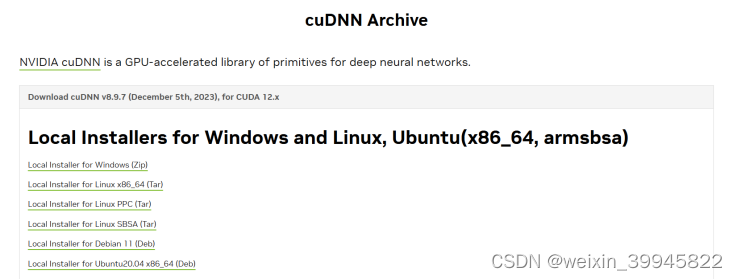

在https://developer.nvidia.com/rdp/cudnn-archive下载,比如v8.97 for CUDA 12.x。

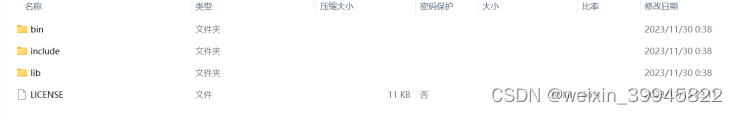

打开文件cudnn-windows-x86_64-8.9.7.29_cuda12-archive.zip,将把三个文件夹拷贝到cuda的安装目录下(覆盖原有文件)。

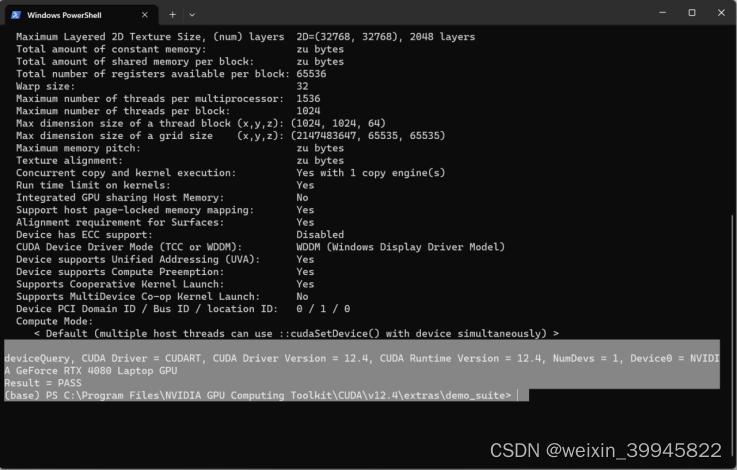

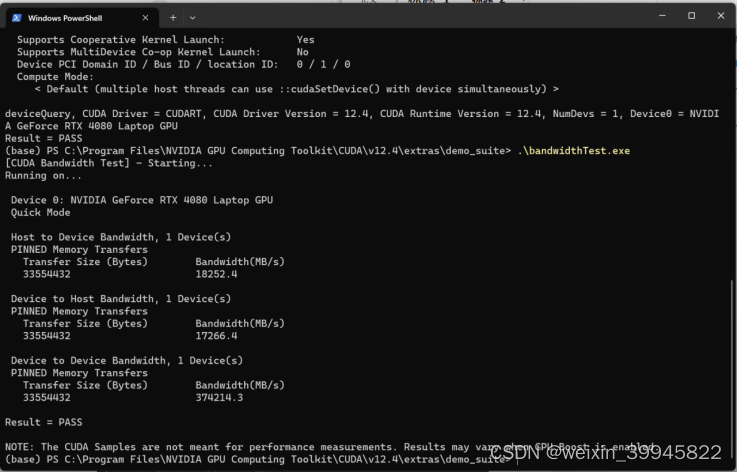

验证是否安装成功。

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.4\extras\demo_suite。执行bandwidthTest.exe和deviceQuery.exe(.\bandwidthTest.exe和.\deviceQuery.exe),“Result = PASS”表示成功。

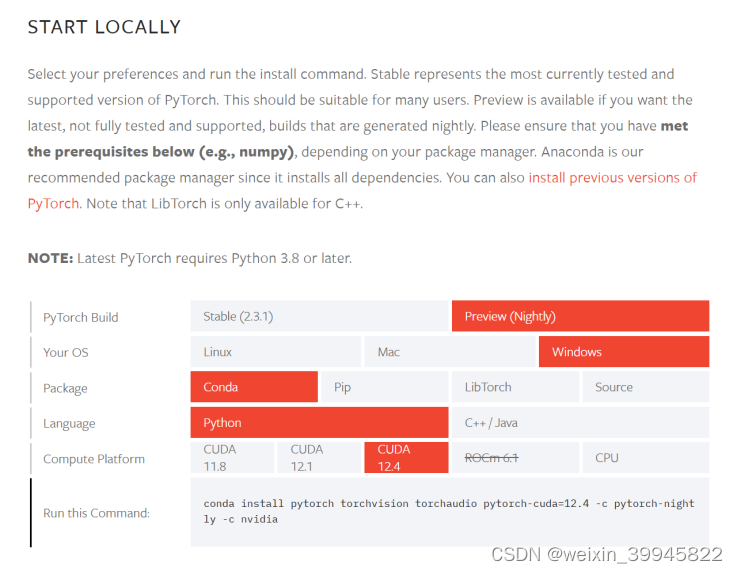

五、安装深度学习框架pytorch

1.安装pytorch,直接到官网https://pytorch.org/选择conda,并复制代码安装即可。比如cuda的版本是12.4,以管理员身份运行Windows PowerShell,激活虚拟环境chatglm,并输入命令:conda install pytorch torchvision torchaudio pytorch-cuda=12.4 -c pytorch-nightly -c nvidia

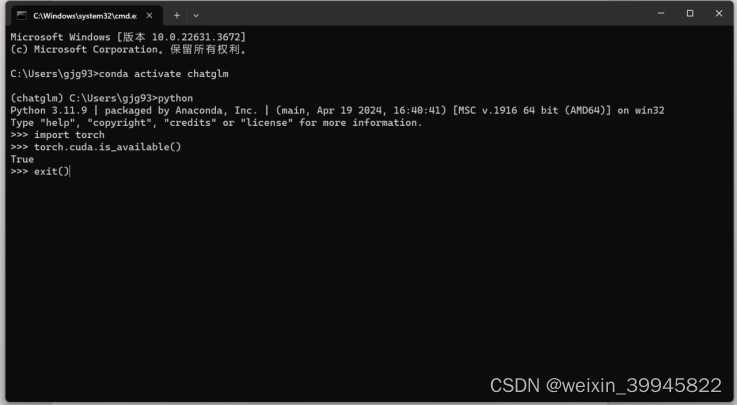

2.检查pytorch是否安装成功。

激活虚拟环境:conda activate chatglm

打开python

导入库:import torch

查看cuda是否可用,如果为TRUE为驱动正常:

torch.cuda.is_available()

退出python:exit()

六、下载开源大模型GLM4

GLM4 是智谱AI和清华大学 KEG 实验室联合发布的新一代对话预训练模型。

1.在D盘新建目录chatglm4,在该目录下点击鼠标右键,选择“在终端中打开”,输入:

git clone https://github.com/THUDM/GLM4

2.在chatglm4目录下新建glm-4-9b-chat-1m目录,在该目录下点击鼠标右键,选择“在终端中打开”,输入:

git clone https://www.modelscope.cn/ZhipuAI/glm-4-9b-chat-1m.git

七、模型部署

1.安装依赖。

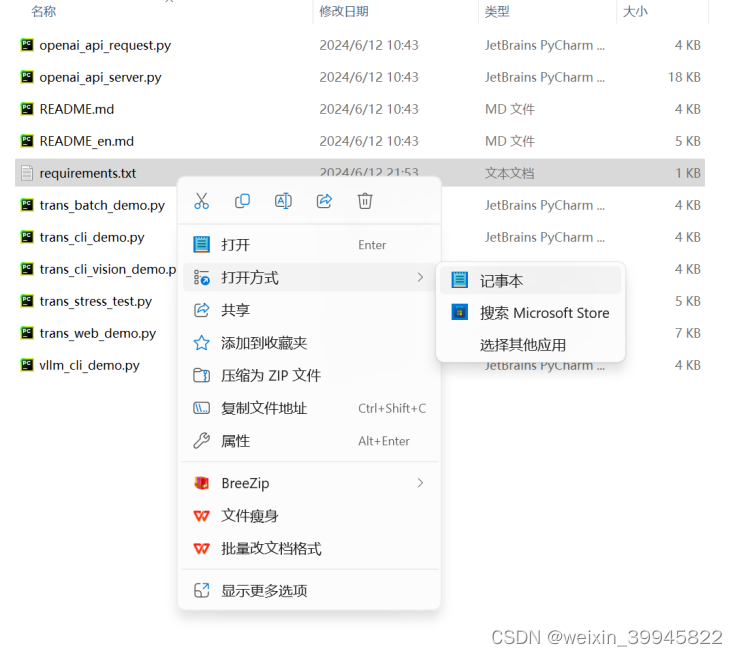

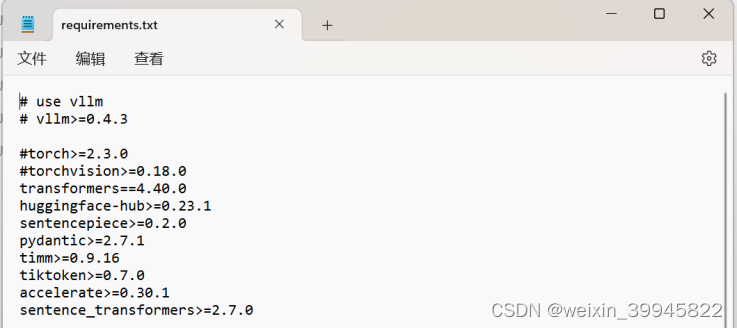

在D:\chatglm4\basic_demo目录下打开并修改requirements.txt。在第三行torch>=2.3.0和第四行torchvision>=0.18.0前面添加“#”。

在D:\chatglm4\basic_demo目录下点击鼠标右键,选择“在终端中打开”,激活环境chatglm,安装环境文件。

(base) PS D:\chatglm4\basic_demo>conda activate chatglm

(chatglm) PS D:\chatglm4\basic_demo>pip install -r requirements.txt

2.修改相关文件,加载本地模型。

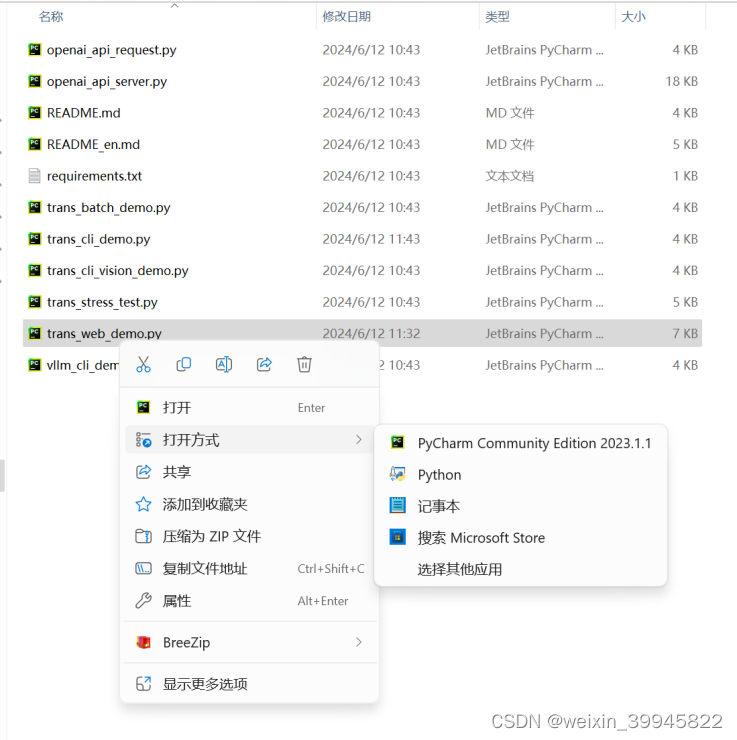

比如使用pyCharm编辑trans_web_demo.py文件,在D:\chatglm4\basic_demo目录下,点击鼠标右键,选择打开方式,找到编辑软件。

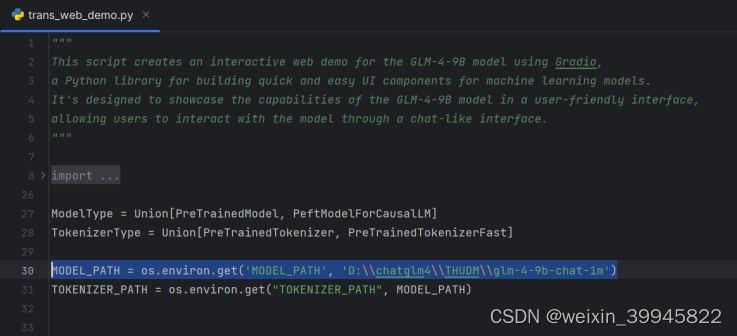

将模型目录\THUDM\glm-4-9b修改成D:\\chatglm4\\THUDM\\glm-4-9b-chat-1m:

MODEL_PATH = os.environ.get('MODEL_PATH', 'D:\\chatglm4\\THUDM\\glm-4-9b-chat-1m')

八、运行模型

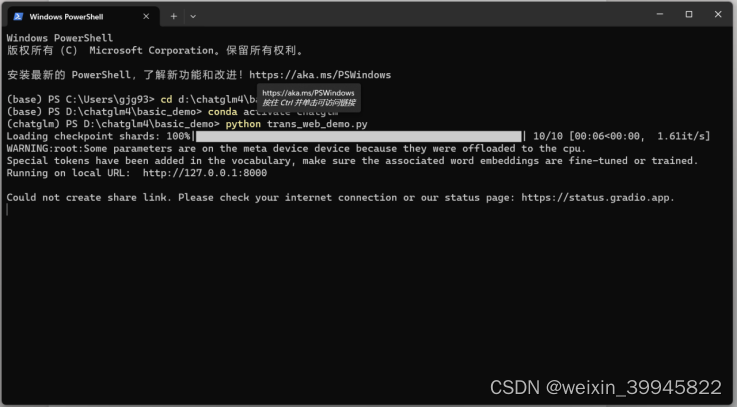

1.运行Windows PowerShell,激活环境ChatGLM,运行trans_web_demo.py

conda activate chatglm

cd d:\ChatGLM4\basic_demo

python trans_web_demo.py

2.自动打开网页http://127.0.0.1:8000/(使用时不要关闭终端,当退出大模型时关闭终端)。

备注:以上各项软件应根据个人电脑的实际配置下载对应版本(尤其是cudn、cudnn和pytorch)。