阅读量:0

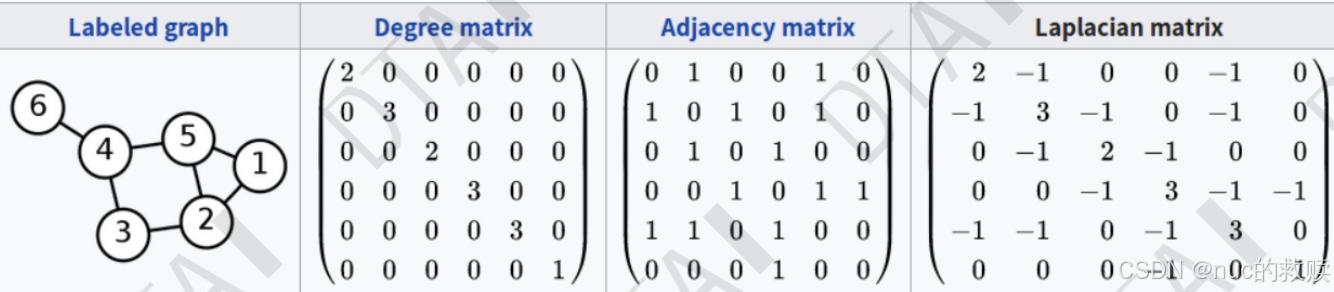

1.拉普拉斯矩阵

D是度矩阵,A是邻接矩阵

L的第二个公式常用

L的特征值>=0

2.图的整体,节点,边都能代表一个分类/回归问题。

3.GNN的感受野

N-Hop Neighbors,某一点的n阶邻居。n步以内能到达的点。

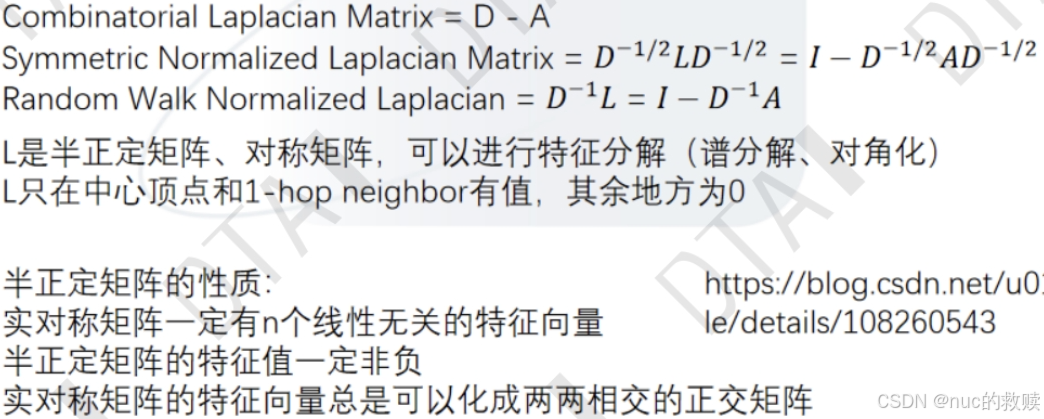

4.残差连接

最后对图结果的处理比较多样,比较自由。

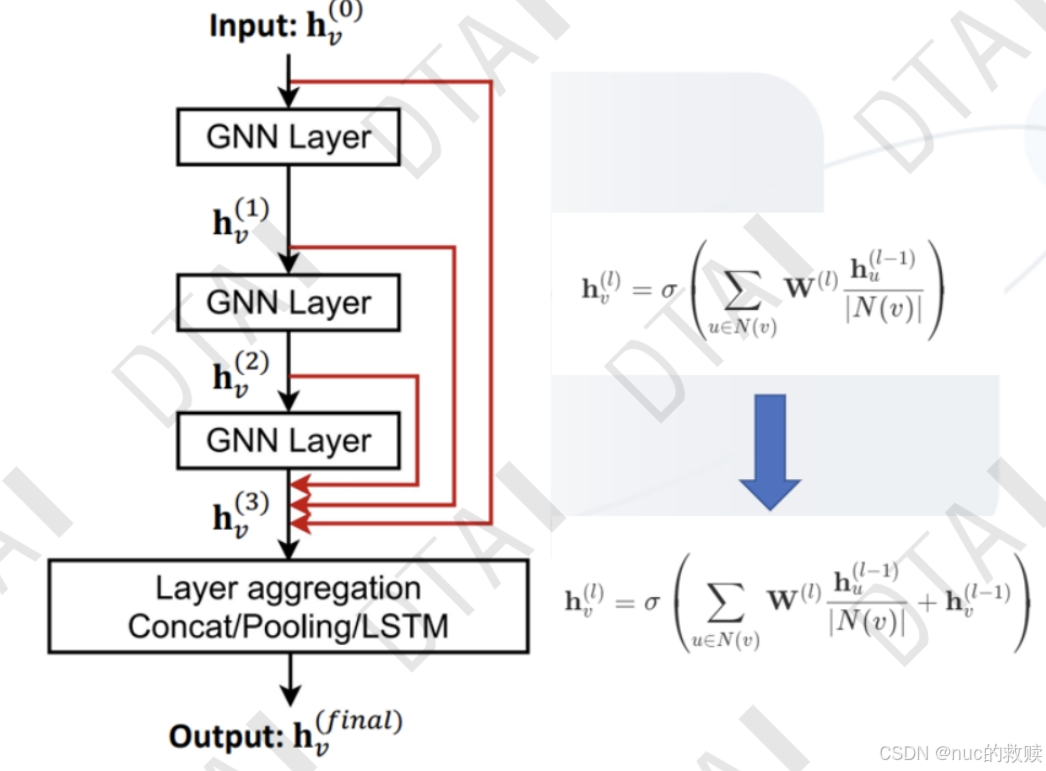

5.cnn与gnn

类比体会感受野和特征学习的过程,gnn比较随意 但也是针对某点的邻居进行学习。

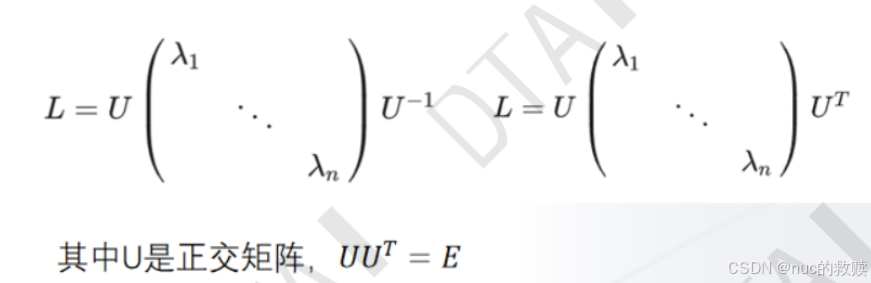

六、特征分解

GCN:有时候只根据邻居不能准确预测,还要加上自己的信息。

GNN概述:

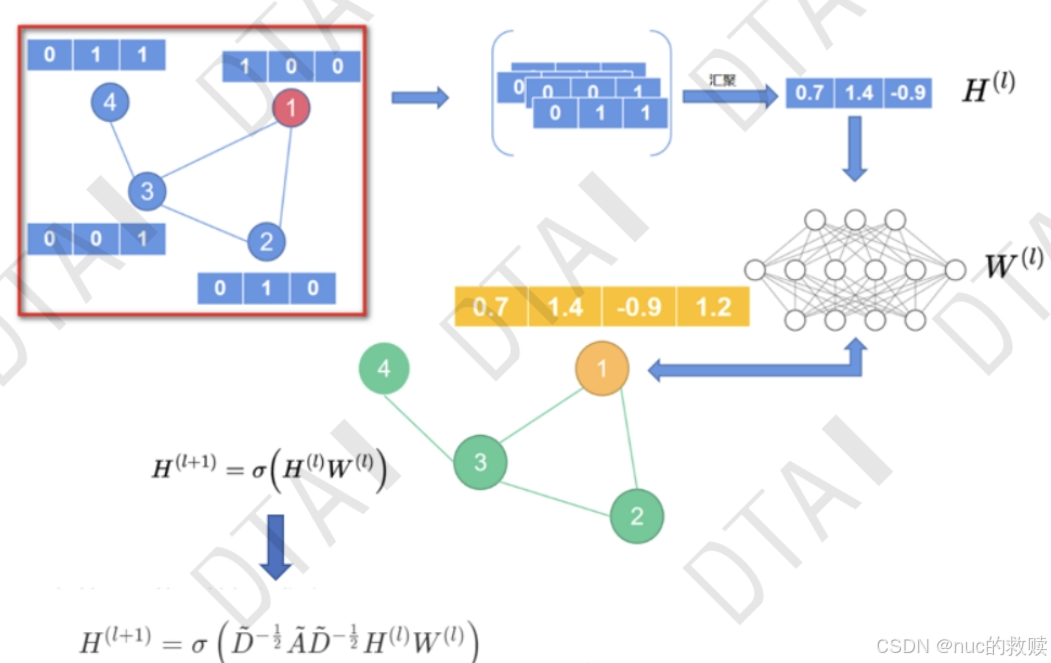

对每个边点图,进行编码然后学习。

通过池化,聚集各部分特征(sum,mean,avg),信息传递???图的连通信

消息传递步骤:就是只有边/点的信息

1.对于每个结点,收集所有邻接点的embedding。(这应该能加好几层吧)

2.aggregate所有embedding

3.最后放到神经网络

这些步骤是利用图形连通性的关键。我们将在 GNN 层中构建更精细的消息传递变体,从而产生具有更高表现力和功率的 GNN 模型。

消息传递的属性越多,模型性能越好。

GNN的研究前沿在于“如何构建图”,为图注入额外的结构或关系。添加更多的消息传递的属性。可以考虑在结点之间添加额外的空间关系。