系列文章目录

上手第一关,手把手教你安装kafka与可视化工具kafka-eagle

Kafka是什么,以及如何使用SpringBoot对接Kafka

架构必备能力——kafka的选型对比及应用场景

在现代大数据架构中,消息队列是不可或缺的一部分。前面我们介绍了Kafka是一种高吞吐量,低延迟的分布式消息队列系统,因其可靠性、可扩展性和灵活性而备受欢迎。本篇博客将比较Kafka与主流竞品之间的差异,并列出Kafka的典型应用场景以及与竞争对手相比的优势

📕作者简介:战斧,从事金融IT行业,有着多年一线开发、架构经验;爱好广泛,乐于分享,致力于创作更多高质量内容

📗本文收录于 kafka 专栏,有需要者,可直接订阅专栏实时获取更新

📘高质量专栏 云原生、RabbitMQ、Spring全家桶 等仍在更新,欢迎指导

📙Zookeeper Redis dubbo docker netty等诸多框架,以及架构与分布式专题即将上线,敬请期待

一、Kafka的模型与优势

1. Kafka 模型

在Kafka中,有几个主要的概念需要了解,包括broke、topic、partition等

Broker

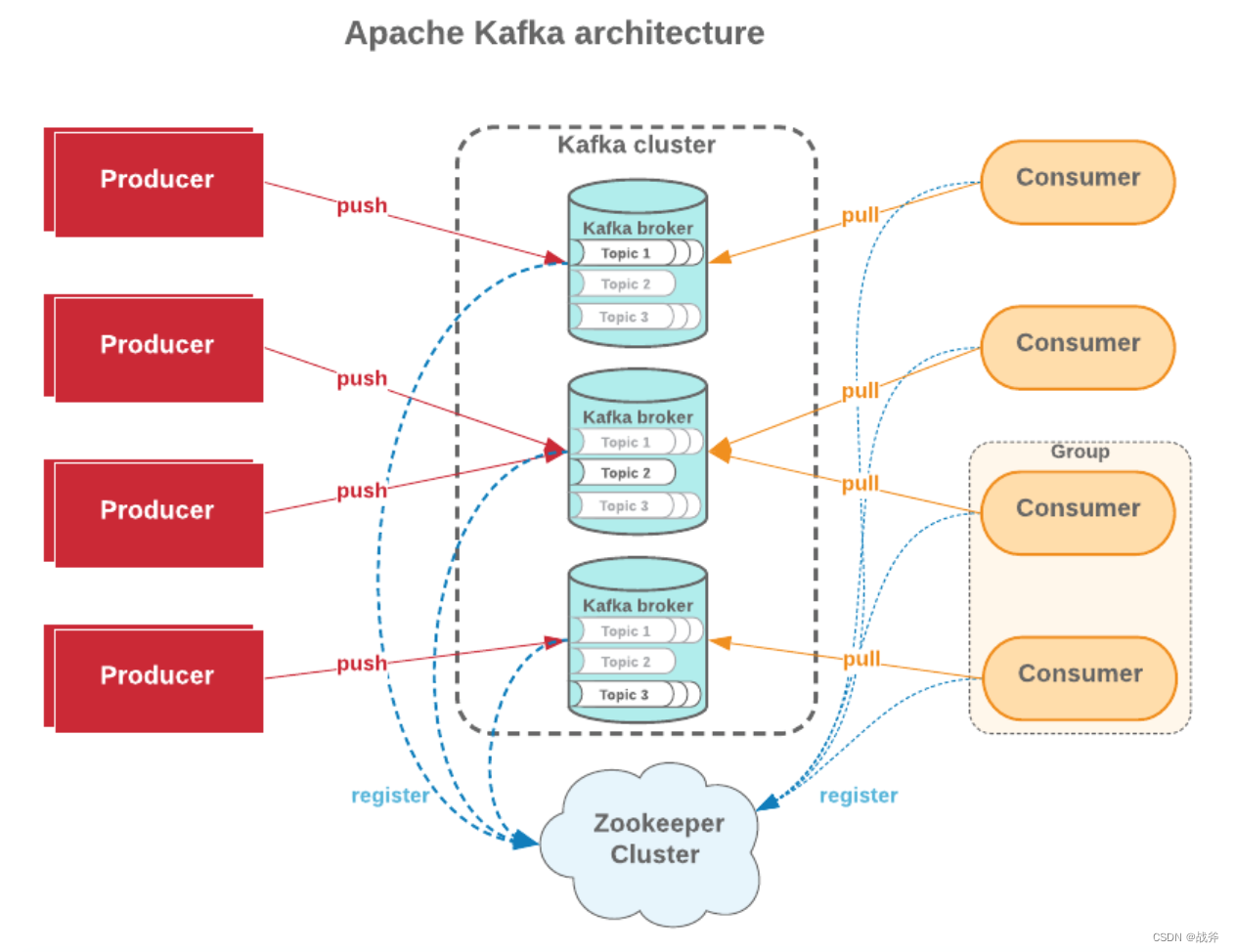

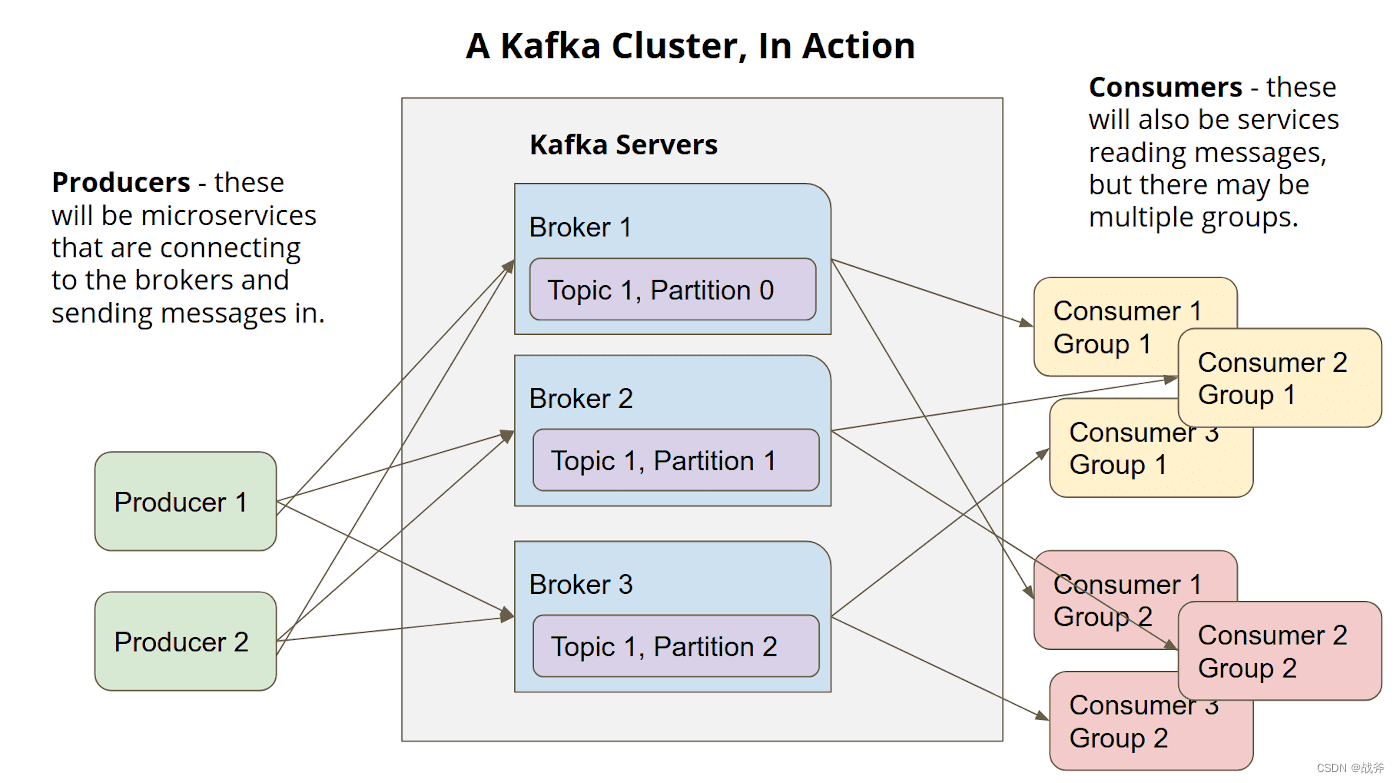

Broker是Kafka集群中的一个节点,可以理解为是一个Kafka实例,一个Kafka集群由多个Broker组成。Broker负责存储数据,处理客户端的请求,以及协调分布式环境下的各种工作。Topic

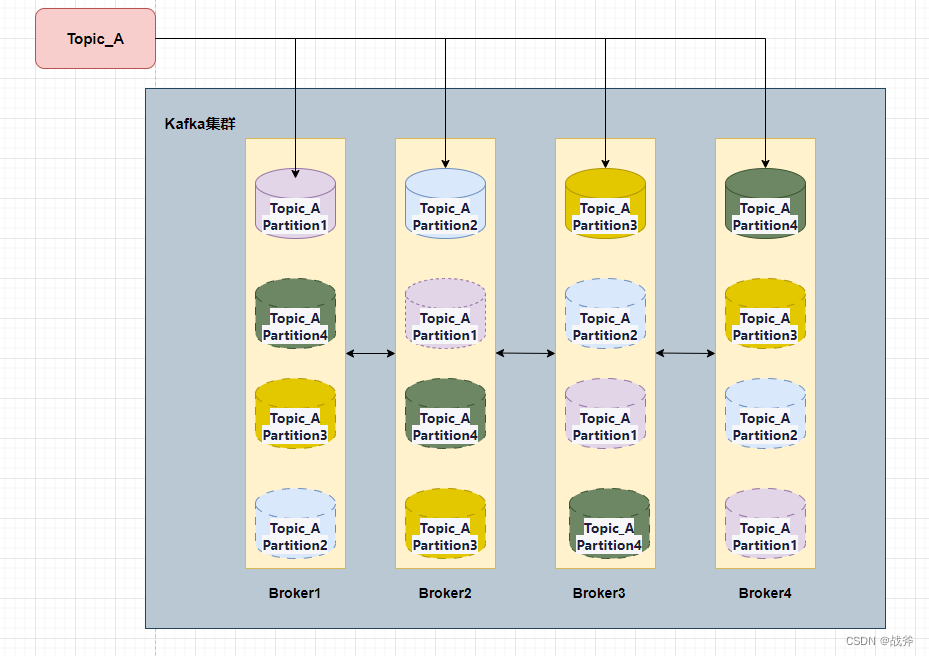

Topic是Kafka中消息的基本单位,相当于消息的分类。每个Topic包含了若干个消息,这些消息被存储在Broker中的一个或多个Partition中。一个Topic可以有多个Partition,同时每个Partition只能属于一个Topic。Topic名称是一个字符串,通常表示Topic所代表的业务或功能,例如"order"、"log"等等。Partition

Partition是Kafka中的一个概念,表示一个物理上的存储单元。一个Topic可以被分割成多个Partition,每个Partition可以存储一定数量的消息。Partition中的消息是有序的,每个消息都有一个唯一的编号,称为Offset。Offset是Partition中消息的唯一标识符,客户端可以根据Offset从Partition中读取消息。

当然,Partition 其实也分种类,有着主备关系。如上图,Partition1 在 Broker1中是主分区(Leader)用实线表示。在其他分区中也有Partition1 ,但都是备份(follower),用虚线表示。

2. Kafka 优势

不难看出,Kafka的设计很像分布式文件系统,因为天然就是要多个Broker节点,所以具有很大的吞吐能力。再加上可选数量的备份,配合以高效的数据存储,使得其有很强的性能,我们可以总结一下Kafka的几项优势

高吞吐率

Kafka的高吞吐率是其最为突出的优势。在Kafka的设计中,每个分区都有多个副本,如果需要,每个副本都可以独立地对外提供服务。这种设计使得Kafka能够轻松地扩展到数千个节点,从而实现高吞吐率的数据传输。此外,Kafka支持批量消息传送,可以将小消息合并为一个大的批处理消息,从而减少网络传输的开销。可靠性高

Kafka的分布式设计和多副本机制可以保证数据的高可靠性。每个分区都有多个副本,一旦某个副本出现故障,其他副本会自动接管服务。此外,Kafka支持消息的持久化存储,即使出现消息传输中断或节点崩溃,也可以在节点恢复后重新传输数据。灵活性高

Kafka的灵活性也是其优势之一。Kafka不仅能够作为消息中间件,还可以作为日志收集和数据处理的平台。此外,Kafka的存储模型很灵活,支持多种不同的数据类型和格式,可以自定义消息格式和处理逻辑。

当然,除了性能优异,Kafka 的生态系统也很丰富,有多种不同的消费者和生产者客户端,支持多种编程语言,例如Java、Python和Go等。此外,Kafka还提供了Kafka Connect和Kafka Streams API,可以将Kafka与不同的外部系统集成,并且支持实时数据处理和流式计算。

二、Kafka与竞争对手的区别

1. 与RabbitMQ相比

在之前的文章《消息队列选型——为什么选择RabbitMQ》 中,其实我们已经对Kafka RabbitMQ进行了一些对比,这里我把当时的对比表格再放出来:

RabbitMQ是一个流行的AMQP消息代理,可提供很好的消息传递性能,还可以在高可靠性和事务性方面提供更好的支持。然而,相对于Kafka,RabbitMQ在可扩展性和处理大量数据时的性能方面不够强大。但是,对于许多大数据应用程序来说,Kafka的可扩展性和性能优势使其成为更好的选择。

2. 与ActiveMQ相比

ActiveMQ是Apache旗下的分布式消息代理,可提供良好的Java集成和可靠性。

| 对比项 | ActiveMQ | Kafka |

|---|---|---|

| 应用场景 | 应用于企业内部的消息传递、集成、异步通信等 | 应用于大规模数据处理、流式计算等 |

| 消息存储模式 | 消息被发送到队列或主题,存储在磁盘上 | 消息以分区的方式存储在Kafka集群的磁盘上 |

| 消息消费 | 消息被消费后会被删除 | 消息被消费后不会立即删除,而是根据设置的保留时间保留在磁盘上 |

| 吞吐量 | 吞吐量相对较低 | 吞吐量相对较高 |

| 可扩展性 | 相对较差 | 相对较好 |

| 消息保证 | 支持消息事务,可保证消息的可靠性 | 支持至少一次消息传递,不保证消息的可靠性 |

| 消息顺序保证 | 支持消息顺序保证 | 支持基于分区的消息顺序保证 |

| 管理维护 | 相对较简单 | 相对较复杂 |

| 生态系统 | 生态系统相对较完善 | 生态系统相对较单一 |

| 开发难度 | 开发难度相对较大 | 开发难度相对较低 |

| 消息传递方式 | 传递方式基于TCP协议 | 传递方式基于TCP协议,支持Zero-copy技术 |

| 消息过滤器 | 支持类SQL语言的消息过滤器 | 不支持消息过滤器 |

| 消息分发机制 | 消费者需要轮询服务器获取消息 | 消息通过推模式由服务器主动分发给消费者 |

| 消息重复消费问题 | 相对较少 | 相对较多 |

但是,相对于Kafka,ActiveMQ 在处理大量数据时的性能不足,并且在滞后和可扩展性方面也存在问题,这意味着,Kafka 在高性能、大规模数据处理时,具备很强的优势。

3. 与RocketMQ相比

Kafka和RocketMQ都是流行的分布式消息队列系统,它们都可以用于数据传输和处理,他们的一些特征对比如下

| 特性 | Kafka | RocketMQ |

|---|---|---|

| 适用场景 | 大规模实时数据处理,高吞吐量,低延迟 | 大规模分布式消息传递和处理 |

| 数据模型 | 基于日志的消息传递模型,消息有序 | 基于 JMS 的消息传递模型,支持消息批量发送 |

| 存储方式 | 消息使用队列存储,副本机制保证数据可靠性 | 消息使用主题存储,支持多种存储方式 |

| 分区设计 | 分布式分区,水平扩展容易 | 分布式分区,支持水平、竖直扩展 |

| 性能表现 | 高吞吐量,低延迟,处理大数据流效果更佳 | 处理高并发、大数据流效果更佳 |

| 可靠性 | 通过多个副本保证数据可靠性,并具有良好的容错性 | 基于分布式架构,具有较强的可靠性和容错性 |

| 社区支持 | 开源社区支持广泛,文档丰富,插件可扩展 | 独立开源社区支持,文档和插件相对较少 |

总的来说,RocketMQ在性能方面与Kafka相当。至于社区的话,两者现在都是Apache软件基金会的顶级项目,Kafka最初是由LinkedIn公司开发的,而RocketMQ最初是由阿里巴巴公司开发的,但是贡献给了Apache软件基金会稍微晚一些,所以相对活跃度低一些,但其在国内应用很广泛。

4. 与Pulsar对比

Apache Pulsar和Apache Kafka都是可扩展、可靠的流式数据平台。它们都具有高可用性、高并发性和高吞吐量,并支持分布式订阅和发布,他们的一些对比如下:

| 对比项 | Apache pulsar | Kafka |

|---|---|---|

| 发布时间 | 2017年 | 2011年 |

| 语言 | Java | Scala |

| 群集模式 | 多租户 | 无多租户 |

| 可伸缩性 | 低延迟和高容量 | 可扩展性极高 |

| 事务 | 支持 | 不支持 |

| 消息顺序 | 有序 | 有序 |

| 多语言客户端 | 支持 | 支持 |

| 跨数据中心复制 | 支持 | 支持 |

| 批量发送 | 支持 | 支持 |

| 多租户安全 | 支持 | 不支持 |

| 社区支持 | 相对较新,但增长迅速 | 相对成熟的社区支持 |

| 性能 | Pulsar在延迟、吞吐量和可伸缩性方面表现出色,特别是在多租户和跨数据中心复制方面。 | Kafka在吞吐量和可伸缩性方面表现出色,是一个可靠而高效的消息传递系统。 |

总的来说,Apache pulsar和Kafka都是高性能分布式消息传递系统,用于实时数据传输。它们都具有不同的功能和性能特点。Apache pulsar具有更多的功能,例如异地复制、多租户设计等,但Kafka具有更高的性能和更成熟的社区支持。

三、 Kafka的典型应用场景

1. 常用场景

消息队列

Kafka可以作为传统消息队列的替代方案。它可以快速传输大量消息,保持消息的可靠性和顺序性,并允许多个消费者读取消息,尽管在MQ功能性上的特点稍逊一筹,相比其他MQ插件,Kafka拥有更好的可扩展性和吞吐量。

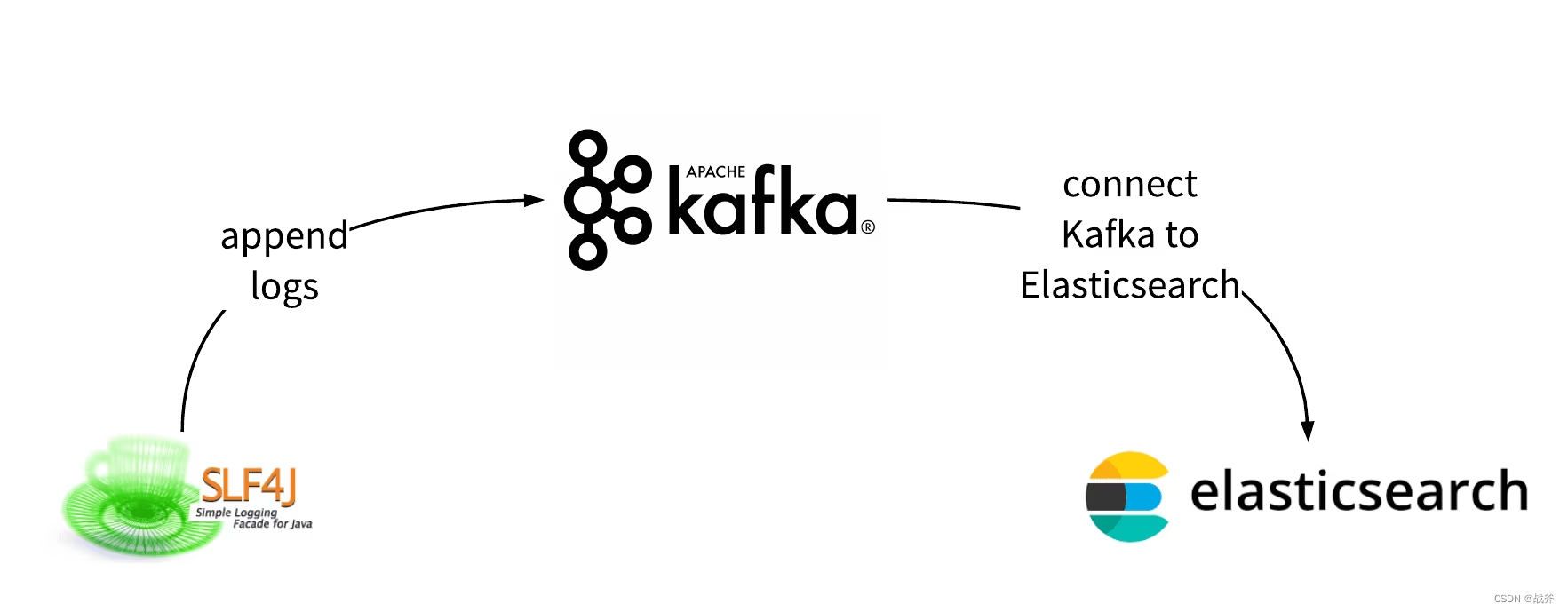

日志收集

Kafka可以作为日志收集的理想平台。由于其可靠性和可扩展性,Kafka可以在数百个服务器上实时收集日志,这些日志可以进行后续处理和分析。Kafka的高效处理能力使其成为收集实时日志的最佳选择。我们在《日志搞不定?手把手教你如何使用Log4j2

》 里也提到可以配置Appenders将日志传输至Kafka服务器。 相比其他MQ插件,Kafka预设了这种场景,使用更容易,并且能够处理更高的数据量和更快的数据传输速率。

流处理

Kafka的流处理功能使其成为构建实时处理系统的首选平台。它可以让开发人员通过处理无限流来自动触发和响应事件,并可以在流中使用各种数据处理步骤。与其他MQ插件相比,Kafka使用分布式流处理,可以处理大量的数据并提供更高的可靠性。事件驱动

Kafka可以作为事件驱动架构的后端,帮助处理大量的事件数据,包括用户行为数据、交易数据、日志数据等。相比其他MQ插件,Kafka拥有更好的扩展性和容错性。

2. 案例分析

场景: 一个大型电商网站需要实时监控用户的购买行为,以便及时调整商品推荐策略和优惠活动,提高用户购买率。这个网站有数千万的用户和数百万个商品,每秒钟会产生成千上万的购买行为事件,如何高效地收集、处理和分析这些数据,是一个非常具有挑战性的问题。

解决方案: 使用Kafka来搭建一个实时数据处理系统,主要包含以下组件:

1.数据收集:在电商网站的应用程序中,使用Kafka的Producer API将用户的购买行为数据发送到Kafka的Topic中。

2.数据处理:在Kafka的消费者端,运行一个或多个消费者进程来处理数据。消费者进程可以使用Kafka Connect将数据写入到NoSQL数据库、Hadoop集群等数据存储系统中。在处理数据时,消费者需要注意以下几个关键点:

- 保证数据的可靠性:使用Kafka的消息确认机制来保证数据不会丢失或重复处理。

- 支持分布式处理:使用Kafka的分区机制来实现高效的水平扩展,并避免单点故障的影响。

- 时间戳管理:在处理数据时,需要记录数据到Kafka中的时间戳来确保正确性。

3.数据分析:使用实时流处理工具,如Apache Storm、JStorm或Apache Flink,对数据进行实时分析和处理,并输出结果到实时报表和仪表盘中。在使用这些工具时,需要注意以下几个关键点:

- 窗口机制:使用窗口机制来控制处理数据的时间段,以便对数据进行聚合、分析和统计。

- 数据源管理:与Kafka相同,实时流处理工具也需要支持分布式处理,并且可以通过Kafka Connect来实现数据源的管理。

- 处理结果数据的可视化:使用可视化工具,如Grafana、Kibana等,将处理结果可视化,并输出到实时报表和仪表盘中,便于业务人员和技术人员了解实时数据变化。

总结

经过上述的讲解,我们不难知道Kafka的应用场景非常广泛,你可以只把他当MQ组件,也可以使用它进行日志传输或流处理。它的特点也非常鲜明,就是强大的吞吐量、扩展性和可靠性。当然它与传统MQ组件对比,它在复杂场景下的使用会比较麻烦。但其在大数据领域应用广泛,比如经常作为 Hadoop 的数据源,将数据传输到 Hadoop 中进行存储和处理。

当然,在实际选型中我们往往要考虑更多问题,除了明确需求和场景,还要考虑已用的技术栈情况、开发语言支持、版本更新情况。并没有哪一种框架是万金油。而对于一些要求比较单薄的场景,可能许多的框架都可以满足要求,那么易用和易维护就会成为选型的关键