目录

(4)全连接层(Fully Connected Layer):

前言

在人工智能的浪潮中,卷积神经网络(CNN)以其卓越的性能在图像识别、视频处理等领域大放异彩。它通过模拟人脑视觉系统,利用卷积层、池化层等结构,从数据中自动提取并学习特征,实现高效且准确的分类与识别。

本文旨在以简洁明了的方式,揭开CNN的神秘面纱,解析其工作原理,让小伙伴们快速了解这一前沿技术如何推动图像处理的进步,并激发对深度学习领域的兴趣与探索。

一、卷积神经网络概述

定义与特点

定义:

卷积神经网络是一类包含卷积计算且具有深度结构的前馈神经网络(Feedforward Neural Networks)。它通过卷积操作来提取输入数据的局部特征,并通过多层卷积和池化操作形成复杂的特征表示,最终通过全连接层进行分类或回归等任务。

特点:

局部连接:卷积层中的神经元仅与输入数据的一个局部区域(即局部感受野)相连,这有助于捕捉图像的局部特征。

权值共享:同一个卷积核在输入数据的所有位置上共享权重,这大大减少了网络的参数数量,降低了模型的复杂度。

平移不变性:无论输入数据中的特征出现在哪个位置,卷积操作都能提取到相同的特征,这使得卷积神经网络在处理图像等具有网格结构的数据时具有很高的效率和准确性。

基本结构

卷积神经网络的基本结构通常由以下几个部分组成:

输入层(Input Layer):接收原始图像数据或其他类型的网格结构数据。

卷积层(Convolution Layer):通过卷积操作提取输入数据的局部特征。卷积层中的每个卷积核可以提取一种特定的特征,多个卷积核可以并行工作以提取不同类型的特征。

池化层(Pooling Layer):对卷积层的输出进行下采样(或称为降维),以减少参数数量和提高计算效率。常见的池化操作包括最大池化和平均池化。

全连接层(Fully Connected Layer):将前面层提取的特征综合起来,用于分类或回归等任务。全连接层的每个神经元都与前一层的所有神经元相连。

二、结构原理详解

(1)输入层(Input Layer):

在神经网络中,输入层(Input Layer)是神经网络的第一层,负责接收外部输入的数据。这些数据可以是图像、声音、文本、传感器数据等。输入层的主要作用是将这些数据以数值的形式传递给网络,以便进行后续的处理和分析。

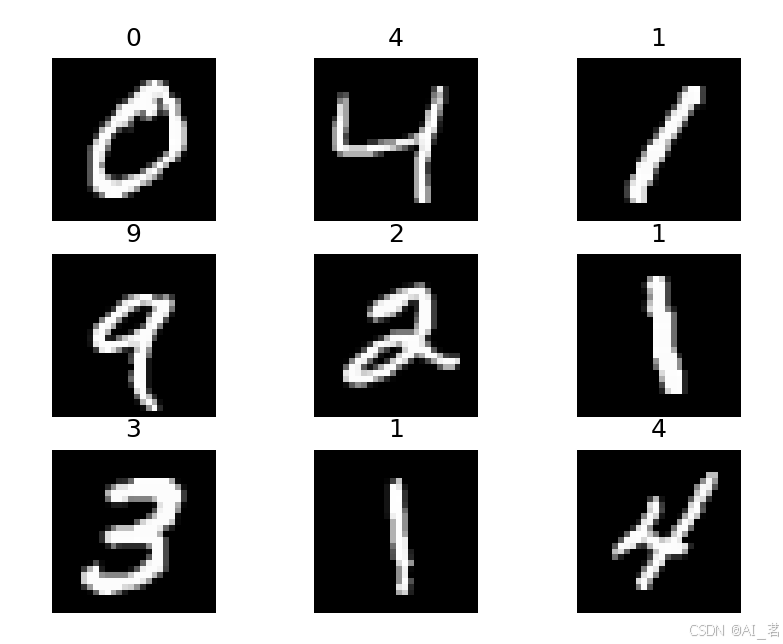

假设我们正在设计一个用于手写数字识别的神经网络(如MNIST数据集),该数据集包含0到9的手写数字图像,每张图像的大小为28x28像素。在这种情况下,输入层将包含784个神经元(因为28*28=784),每个神经元对应图像中的一个像素。这些像素值(通常是灰度值,范围从0到255)在输入到网络之前可能会进行归一化处理,即将它们缩放到0到1之间。

图像在计算机中是一堆按顺序排列的数字,数值为 0 到 255 。 0 表示最暗,255 表示最亮。

(2)卷积层(Convolution Layer):

卷积层(Convolution Layer)是卷积神经网络(Convolutional Neural Network, CNN)中的核心层(核心组件)之一,它主要负责在输入图像上执行卷积操作,以提取输入图像中的不同特征。卷积层通过卷积核(滤波器或特征检测器) 与输入图像进行局部连接和卷积运算,以生成特征图(Feature Map),这些特征 图包含了输入数据的不同特征信息。

Input表示输入的特征图,数字为像素点的值,其中黄色的部分表示卷积核的关注区域。kernel表示了一个尺寸为 3×3 的卷积核,其中绿色部分表示卷积核的权重。output表示经过卷积运算后得到的输出结果,其黄色区域表示的就是卷积的运算结构。

Output = 2 ∗ −1 + 1 ∗ 0 + 0 ∗ 1 + 9 ∗ −1 + 5 ∗ 0 + 4 ∗ 1 + 2 ∗ −1 + 3 ∗ 0 + 4 ∗ 1 = −5

参数详解:

卷积核大小(Kernel Size):定义了卷积操作时覆盖的输入数据区域大小,影响特征提取的尺度。

步长(Stride):卷积核在输入数据上滑动的距离,影响输出特征图的尺寸。

填充(Padding):在输入数据边缘添加的额外像素,用于控制输出特征图的尺寸。

输入/输出通道数(In/Out Channels):输入数据的深度/通道数和输出特征图的数量,决定了卷积层处理的深度和能够生成的特征图种类

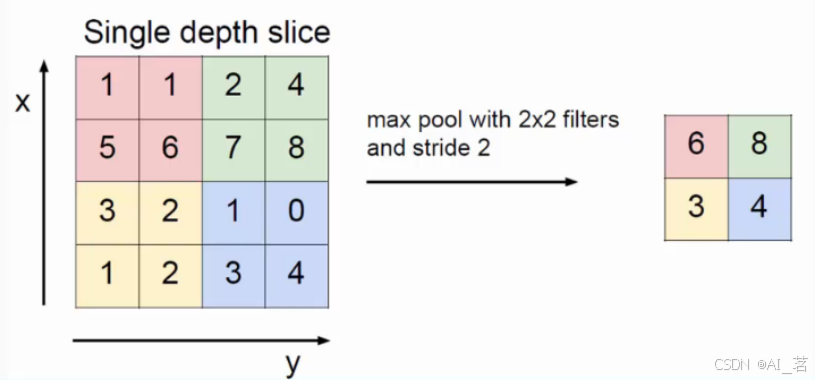

(3)池化层(Pooling Layer):

池化层(Pooling Layer)是深度学习神经网络中常用的一种层级结构,主要用于减小输入数据的空间尺寸,降低模型的计算复杂度,减少过拟合,并在一定程度上提取输入数据的重要特征。池化层主要对卷积层输出的特征图进行下采样操作,一般跟在卷积层之后。

主要功能

特征降维(下采样):通过减小特征图的尺寸来降低计算量,并且可以提取出特征图的主要信息;

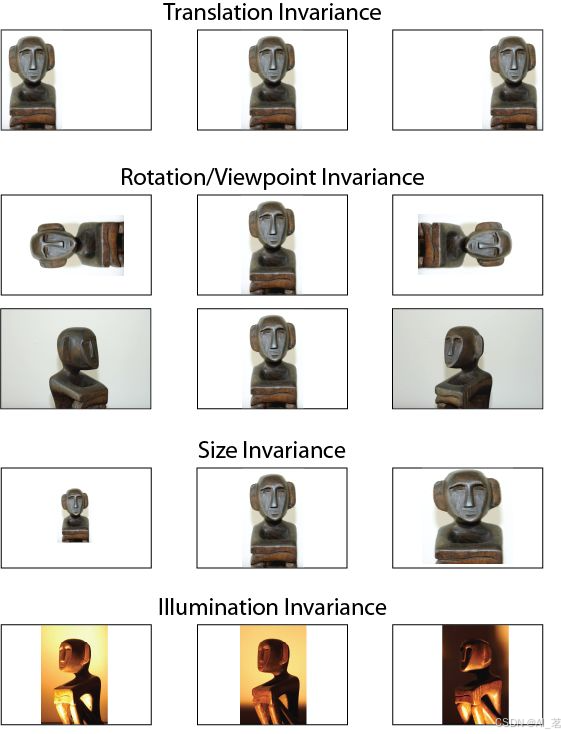

特征不变性:池化操作使模型更加关注是否某些特征是否存在,而不是特征具体的位置,特征不变性包括平移不变性、旋转不变性和尺度不变性等;

防止过拟合:通过减小数据量和参数个数,降低模型的复杂度,提高模型的泛化能力。

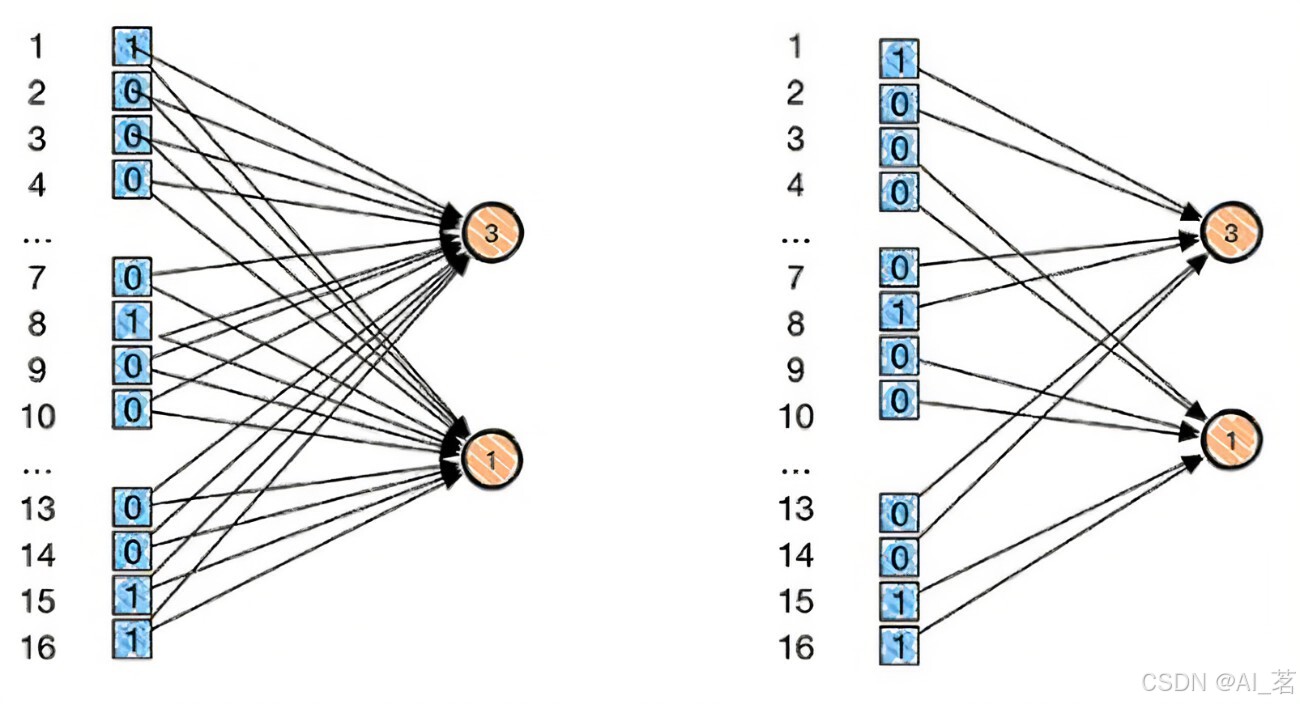

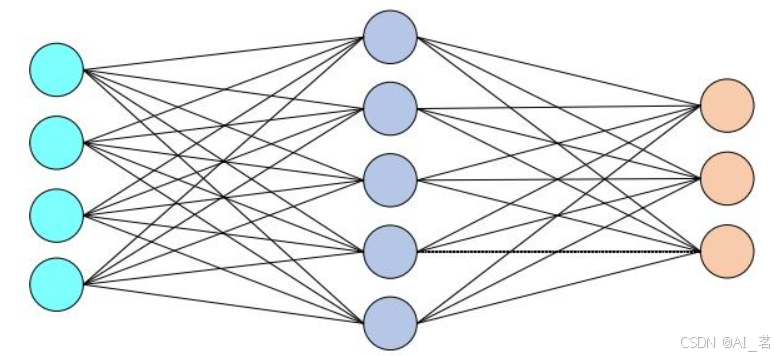

(4)全连接层(Fully Connected Layer):

全连接层(Fully Connected Layer)是深度学习中常用的一种神经网络层,常用于图像识别等,它的主要作用是学习到前面层(如卷积层、池化层等)输出的特征,进行全局整合,并映射到样本的标记空间(输出空间)。

在全连接层中,每个神经元都与前一层的所有神经元相连接,以实现全局特征的加权组合。通过对特征权重和偏置的学习,使得神经网络能够提取到更有意义的特征。全连接层通过其全连接的特性,能够整合输入数据的全局特征,并将这些特征进一步映射到输出层,以实现最终的分类或回归任务。

三、应用领域

卷积神经网络在计算机视觉、自然语言处理、语音识别等领域有着广泛的应用。以下是一些具体的应用示例:

计算机视觉:图像分类(如识别猫、狗、车等物体)、目标检测(如检测车辆、行人、交通标志等)、图像分割(如医学影像中的器官分割)、人脸识别、图像搜索等。

自然语言处理:情感分析、文本分类、命名实体识别等。

语音识别:识别语音指令、语音转文本等。

视频分析:动作识别、视频内容理解等。

综上所述,卷积神经网络是一种强大的深度学习模型,在多个领域都展现出了卓越的性能。随着技术的不断发展,卷积神经网络的应用前景将更加广阔。