🎓作者简介:科技自媒体优质创作者

🌐个人主页:莱歌数字-CSDN博客

💌公众号:莱歌数字

📱个人微信:yanshanYH

211、985硕士,职场15年+

从事结构设计、热设计、售前、产品设计、项目管理等工作,涉足消费电子、新能源、医疗设备、制药信息化、核工业等领域

涵盖新能源车载与非车载系统、医疗设备软硬件、智能工厂等业务,带领团队进行多个0-1的产品开发,并推广到多个企业客户现场落地实施。

每日篇行业发展资讯,让大家更及时了解外面的世界。

更多资讯,请关注B站/公众号【莱歌数字】,有视频教程~~

数据中心的能源成本是相当大的,其中包括冷却日益炎热的硬件的费用。大多数数据中心都依赖于环境空气冷却解决方案来满足其冷却需求。

然而,环境空气冷却解决方案往往无法处理高热负荷,没有针对性,可能成本和能源效率低。随着高功率应用程序和服务器密度的增加,需要新的方法来散热。

液体冷却解决方案的使用是许多数据中心冷却策略中越来越流行的一部分。

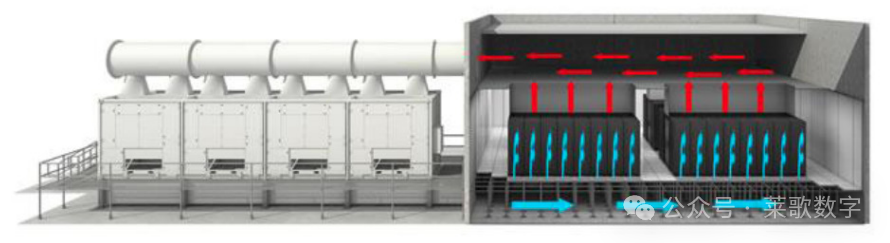

一个典型的数据中心有一个以空气为中心的基础设施来提供热管理。

一组冷却器、压缩机和空气处理器用冷空气代替热空气,一排排的服务器可以布置在较暖的区域和较冷的区域。

但是,虽然这些方法可以提供更酷的计算环境,但在管理成本时,它们可能不是最有效的方法。

在某些情况下,机架和板级的本地化冷却解决方案可以以较低的费用提供所需的冷却。

环境空气冷却

数据中心环境空气冷解决方案在机架之间使用交替的冷空气通道。冷空气通过CRAC机组提供的升高的数据中心地板下的管道供应到冷排。

空气从热排的架子后面排出。另一种在数据中心内部冷却的方法是使用安装在服务器机架的屋顶或后门上的风扇,并使用安装在机架上和墙上的空调。

环境空气冷却解决方案在他们处理高热负荷的能力上是有限的,因为他们通常只能有效地冷却5到10 kW每个机架。

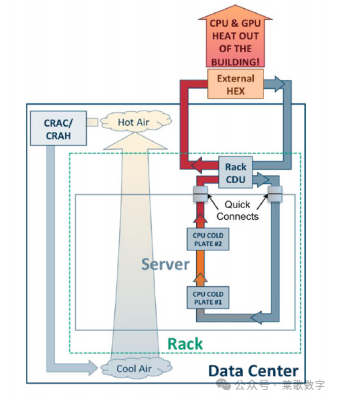

Asetek公司为数据中心的HPC集群提供一系列液体冷却解决方案。他们的冷却技术直接从处理器中去除热量,并将其转移到影响环境的最佳位置。

Asetek方法包括用于快速冷却的处理器的内环液体冷却;机架CDU液体冷却从机架服务器和叶片从数据中心获取组件热量,而不需要空调或水冷却机。

公司采用的密封服务器液体冷却过程从数据中心去除所有服务器热量,这意味着数据中心不需要服务器冷却的空气。

图1.来自热数据中心服务器的空气上升至调节室,在那里冷却并返回到数据中心底部,用于将服务器机架冷却至安全工作温度

内环液体冷却从高密度服务器中的cpu和gpu中捕获热量,并将其转移到气流中。

这使得可以在服务器上使用更高功率的cpu和处理器超频,否则就无法依赖于安全性能。

在这些系统中,当冷板将处理器的热量移入流动的冷却液体时,多个cpu被液体冷却。安装在每个冷板上的低功率泵提供流量,从液体到空气的热交换器中抽取冷液体,以极低的压力通过冷板泵入它,并将其送回热交换器。

标准底盘风扇通过热交换器移动空气。液体中的热量被传递到通过底盘流动的空气中。

Asetek的机架冷却剂分配单元CDU使用液体直接冷却服务器内的高热通量组件,包括cpu和gpu。

通过在服务器中直接进行液体冷却热点,这种方法消除了CRAC、机房空调上一半以上的热负荷。

图2.具有机架冷却CDU的数据中心使用两个冷却路径从数据中心去除热量。使用CRAC单元的传统空气路径可以消除由磁盘驱动器、电源和其他低热通量组件产生的热量。机架CDU系统使用直接的液体冷却路径从数据中心去除所有处理器的热量。

密封服务器液体冷却是一种从数据中心去除所有服务器热量并消除对CRAC系统的需要的方法。这些都是独立的冷却单元,不与周围环境交换任何空气。

两种循环包括:一个低压服务器循环和一个设施循环。它们不共用液体。在液对液热交换器中,热量在循环之间移动。

密封服务器内的所有热量都通过液体排出到外部环境中。再循环的冷却器内部空气冷却服务器内的其他组件。

谷歌的数据中心冷却解决方案

谷歌定制了其数据中心的大部分操作,这些数据中心是其庞大互联网业务的引擎。

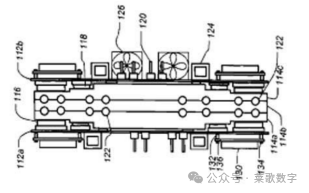

这包括他们的冷却解决方案。由谷歌获得专利的液体冷却设计的特点是定制的主板,组件连接到两侧。

散热处理器被放置在与散热器接触的主板的一侧,散热器是一个铝块,其中包含携带冷却液的管。

产生较少热量的组件,如存储器芯片,被放置在主板的另一侧,靠近为这些组件提供空气冷却的风扇。

主板连接到散热器的两侧,创建一个“服务器夹层”组件,可以安置在一个机架中。

图3.谷歌专利图显示了液冷服务器组件设计的横截面,其两侧都有主板的散热器。

集成了冷冻水冷却单元的服务器机柜提供了刀片服务器、1U服务器和其他高密度热负载的高效热管理。

数据中心资源提供独立的机柜,用于无条件空间,包括仓库、服务器壁橱等。

另外,水冷式热交换机也可以通过传统的冷却方式吸收数据中心的IT热负荷,从而显著降低冷却需求和能源成本。